Author

一作: Anh Nguyen Wyoming大学 二作: Jason Yosinski Cornell大学 三作:Jeff Clune Wyoming 三个作者都是好基友,好多工作都是一起做的,做了挺多可视化方面的工作 主攻understanding & improving neural networks and generative

Abstract

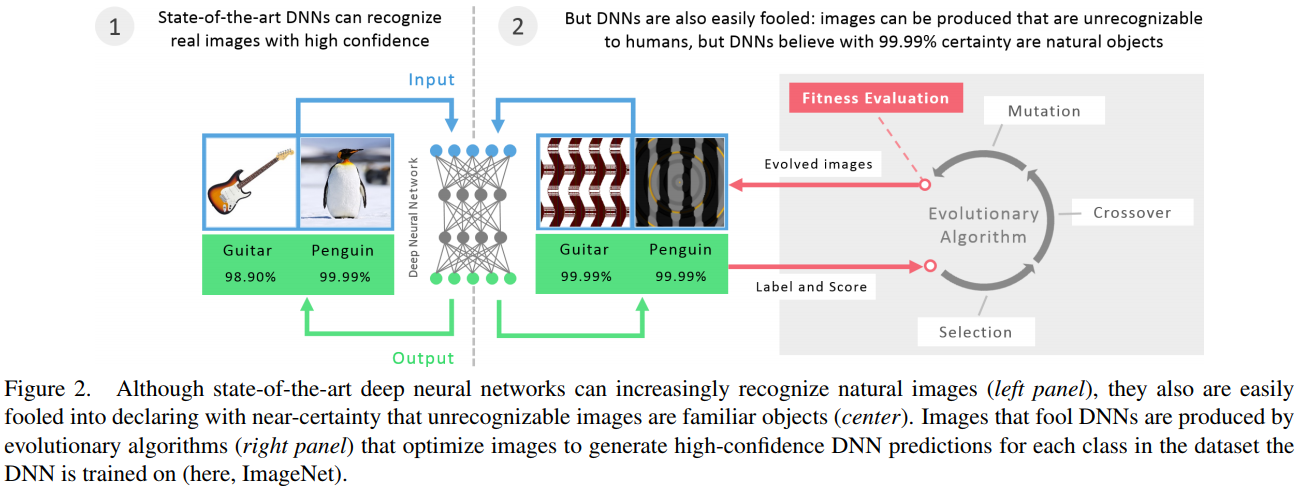

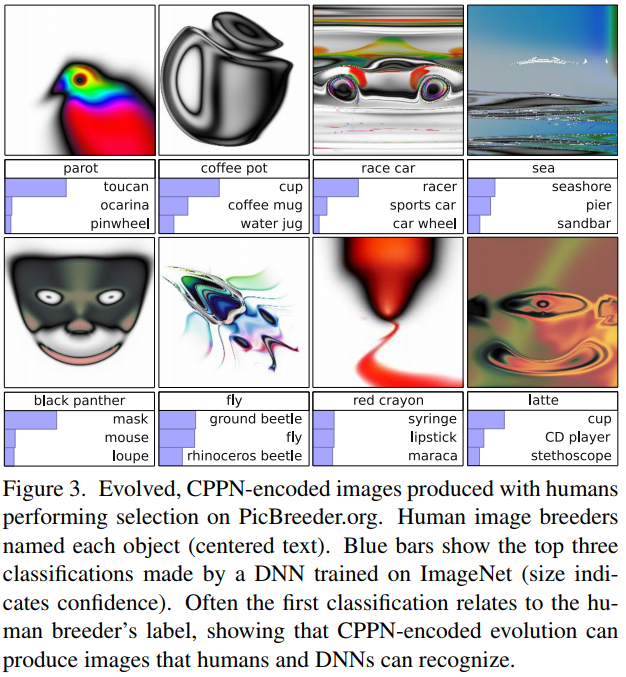

问题来了,计算机和人类视觉有什么不同? Intriguing这篇论文揭示了对人眼不可察觉的改变一张图会导致DNN把它完全分错。我们发现可以产生人类完全识别不同的图片,但是DNN可以正确分类

我们的论文结果主要突出人类视觉和当前DNN的有趣不同,同时关于DNN计算机视觉 generality 提出问题

对比与Intriguing, 这篇论文从另一个方便揭示了DNN和人类视觉的不同。

Introduction

Generating images with evolution

用来测试的新的图片由evolutinary algorithm(EA)算法产生。

这篇工作,主要是做了对Intriguing这篇论文的补充: 不只是对图像细微变化使致DNN分类错误,而且根据DNN很容易产生人眼看毫无意义,但是DNN却能用高置信度分类,这是对DNN以及人类视觉 generality的思考

看别的想法说,在分类空间中有一部分高置信度的空间为人眼不可识别的图像。

面对人类完全无法识别的样本(Fooling Examples), 深度学习模型会以高置信度将它们分类,例如将噪声识别为狮子。这意味着模型很容易被愚弄,例如垃圾 邮件发送者可以利用对抗样本来骗过垃圾邮件识别系统,人脸支付也面临着巨大的挑战。当然,只要不公开这些系统,骗子也就无法针对它进行大规模制造对抗样本。然而,可怕的是,在不同训练子集上用不同架构学习的不同的模型,居然能被同一套对抗样本愚弄!这意味着骗子可以自己训练出一个模型,并在此模型上找到一组对抗样本后就能愚弄其他的模型。