Learning to Detect Objects with a 1 Megapixel Event Camera

2020-12-31 17:05:48

Paper: NIPS-2020

Dataset: https://www.prophesee.ai/category/dataset/

Evaluation Toolkit: https://github.com/prophesee-ai/prophesee-automotive-dataset-toolbox

1. Background and Motivation:

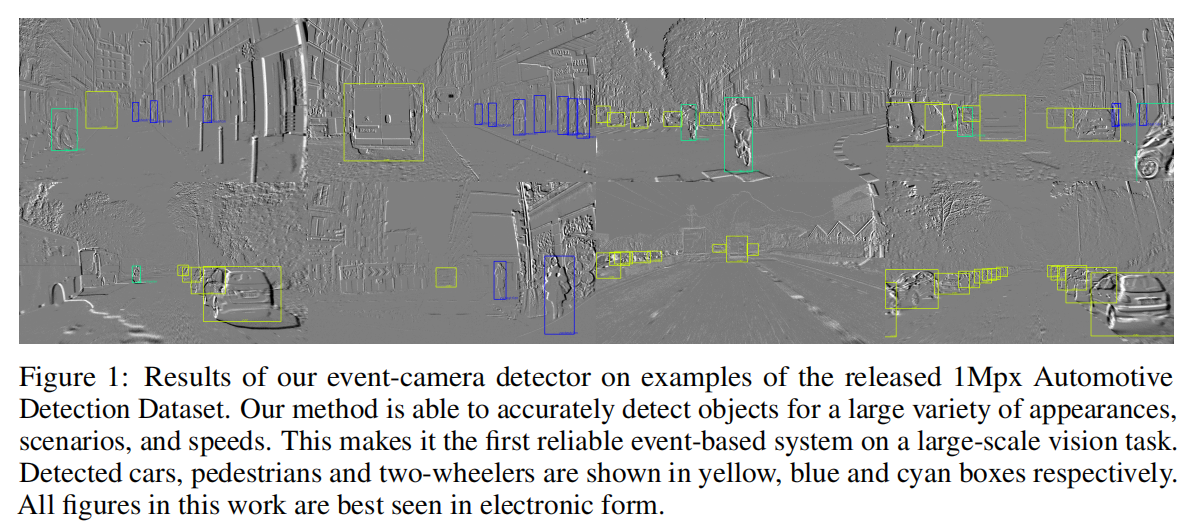

本文在 event camera 上进行了物体检测的任务,主要是因为该传感器具有较好的时间分辨率,没有运动模糊,高动态,以及低功耗等。在自动驾驶领域,有较好的应用前景。

但是目前基于该传感器的物体检测数据集并不多,所以,作者提出一个大型物体检测数据集。与此同时,也提出利用 CNN-LSTM 的框架来学习时空特征,进行物体检测的基准方法。

2. Method:

如下图所示,本文利用 CNN-LSTM 的框架搭建了一个baseline 方法。

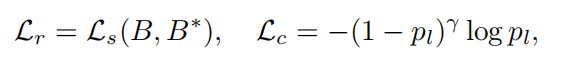

可以看出,该方法首先将异步的事件流转换为 C*H*W 的格式,即 feature map 的形式。然后利用 CNN 提取特征,然后用 ConvLSTM 模块来学习时空特征。最终,在预测模块,作者采用了 SSD 的方式,进行bbox 的预测和类别的判断。从损失函数的角度来说,即:

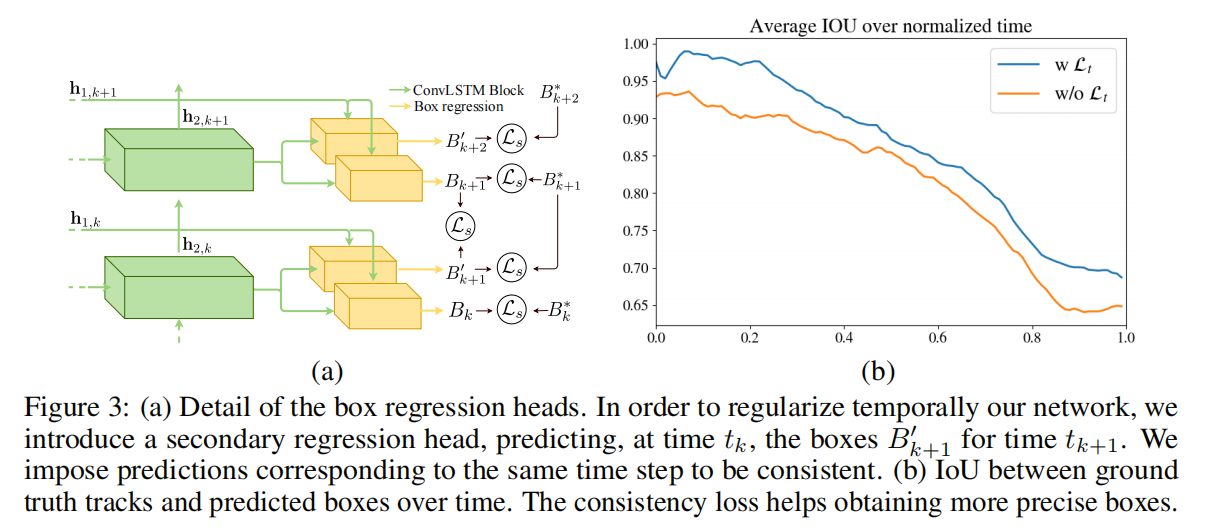

作者还借助预测的一致性损失,来进一步提升检测的性能。

![]()

因此,总体的损失函数就是这三项的组合:

3. Dataset:

从算法的角度来说,其实创新不大。重点在于数据集。由于直接在 event data 上进行标注比较困难,因为该数据只有物体的轮廓信息。有时很难区分物体之间的差异,所以,需要引入另外一个模态的传感器来协助标注。本文,作者采用了一个 RGB camera,来同时进行数据的收集。然后在 RGB camera 上进行标注,迁移变换后得到 event camera 的对应坐标。

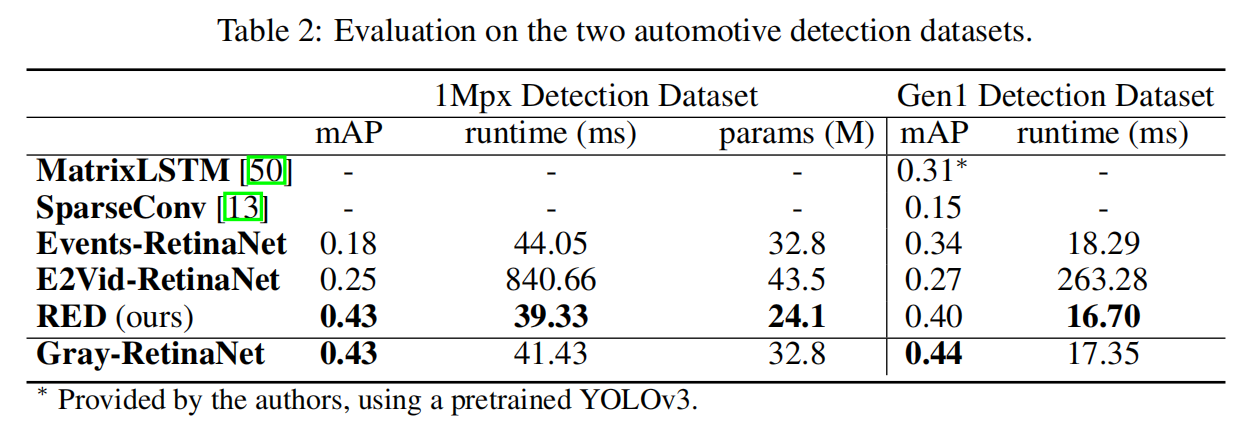

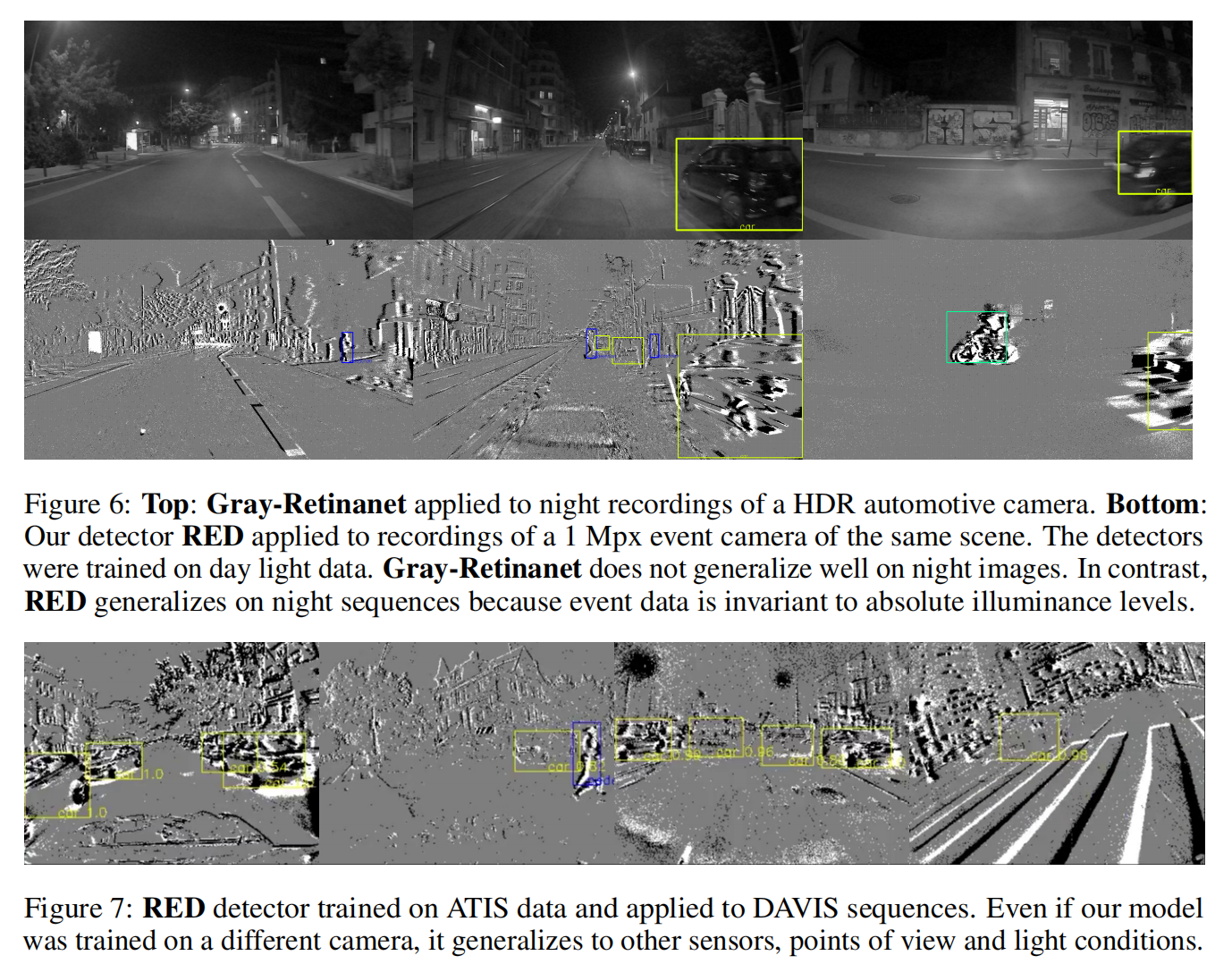

4. Experiment: