Intellij IDEA使用Maven搭建spark开发环境(1)

(接https://www.cnblogs.com/janeszj/p/12230833.html)

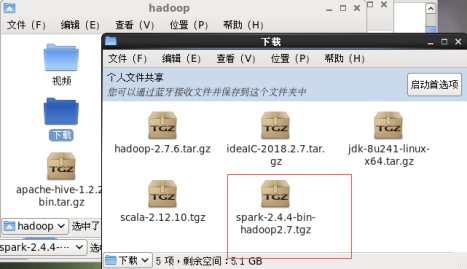

下载Spark(官网下载只能下载比较新的版本,老版本资源没有找到,我下载的是)

复制到虚拟机中

把spark-2.4.4-bin-hadoop2.7压缩包拷贝到/usr/local/spark中

创建spark文件夹

mkdir -p /usr/local/spark

移至压缩包所在目录拷贝其到指定位置

cp -r spark-2.4.4-bin-hadoop2.7.tgz /usr/local/spark

移至到spark目录下解压

tar -zxvf spark-2.4.4-bin-hadoop2.7.tgz

修改配置文件

配置文件位于/usr/local/spark/spark-2.4.4-bin-hadoop2.7/conf目录下。

将spark-env.sh.template重命名为spark-env.sh。

mv spark-env.sh.template spark-env.sh

添加如下内容:

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_241

export SCALA_HOME=/usr/local/share/scala-2.12.10

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

SPARK_MASTER_IP=ltt1.bg.cn

SPARK_MASTER_PORT=7077

SPARK_MASTER_WEBUI_PORT=8080

SPARK_WORKER_CORES=1

SPARK_WORKER_MEMORY=1g

SPARK_WORKER_PORT=7078

SPARK_WORKER_WEBUI_PORT=8081

SPARK_WORKER_INSTANCES=1

将slaves.template重命名为slaves

配置环境变量

回到根目录cd ~

设置环境变量vim .bash_profile

export SPARK_HOME=/usr/local/spark/spark-2.4.4-bin-hadoop2.7

export PATH=PATH:SPARK_HOME/bin

再修改一下vim /etc/profile

export SPARK_HOME=/usr/local/spark/spark-2.4.4-bin-hadoop2.7

export PATH=PATH:SPARK_HOME/bin

两处环境变量可能是有重复(差别参考:https://www.cnblogs.com/bandiao/p/10805749.html)

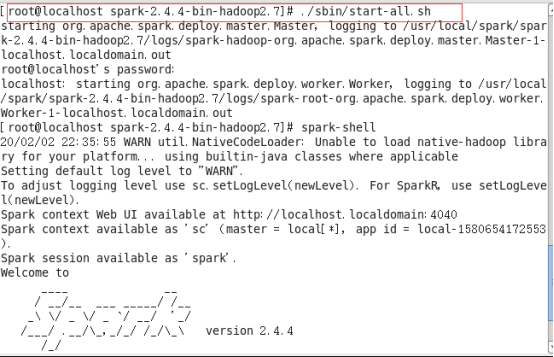

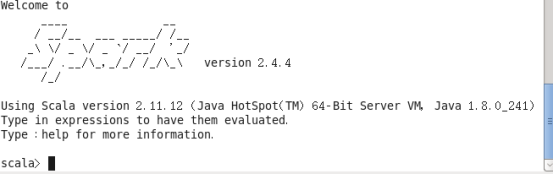

先启动hadoop然后启动spark

cd $HADOOP_HOME

./sbin/start-dfs.sh

进入spark目录