爬虫的基本原理

爬虫概述

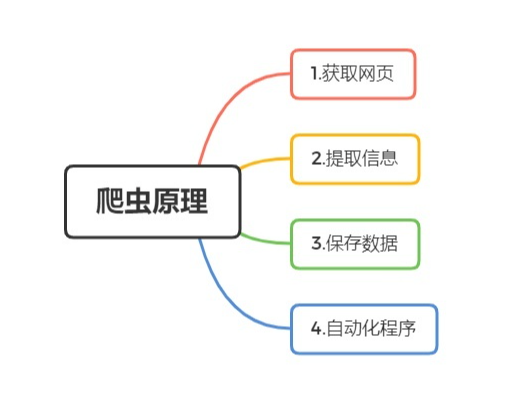

简单来说,爬虫就是获取网页并提取和保存信息的自动化程序。

可以将爬虫总结为4个步骤:

1.获取网页

爬虫首先要做的工作就是获取网页,也就是获取网页的源代码,源代码包含了网页的部分有用信息,所以只要把源代码获取下来,就可以从中提取想要的信息。

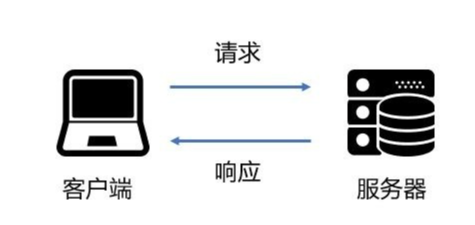

根据请求和响应的概念,向网站的服务器发送一个请求,返回的响应体便是网页源代码,因此最关键的部分就是构造一个请求并发送给服务器,然后接受到响应并将其解析出来。

2、爬虫分类

通用爬虫

实例: 百度、360、Google等搜索引擎 功能: 访问网页->抓取数据->数据存储->数据处理->提供检索服务-> robots协议 一个约定俗成的协议,添加robots.txt.文件来说明本网站哪些内容不可以被抓取,起不到限制作用。

聚焦爬虫

功能:

根据需求,实现爬虫程序,抓取需要的数据

设计思路

1、确定要爬取的url

如何获取url

2、模拟浏览器通过http协议访问url,获取服务器返回的html代码

如何访问

3、解析html字符串(根据一定规则提取需要的数据)

如何解析

3、反爬手段

1、User-Agent: User Agent中文名为用户代理,简称UA,它是一个特殊字符串头,使得服务器能够识别客户使用的操作系统及版本、CPU类型、浏览器及版本、浏览器渲染引擎、浏览器语言、浏览器插件等。 2、代理IP 透明代理:对方服务器可以知道你使用了代理,并且也知道你的真实IP. 匿名代理:对方服务器可以知道你使用了代理,但不知道你的真实IP。 高匿名代理:对方服务器不知道你使用了代理,更不知道你的真实IP。 3、验证码访问 打码平台 云打码平台 4、动态加载网页,网站返回的是js数据,并不是网页的真实数据 selenium驱动真实的浏览器发送请求 5、数据加密 分析js代码