安装前的建议:

将 vm 虚拟机连上网络后,在 secureRCT 中连接ubuntu,然后进行编写。 secureCRT 可以直接复制代码,如果在ubuntu桌面就必须纯手打代码,无法将外部浏览器的内容复制进去。

利用 secureRCT 可以进行 windows 与 linux 文件传输,比如在 windows 系统安装了 jdk1.8 要上传到 linux 系统,则需要用到 secureRCT.

一、创建hadoop用户

$ sudo useradd -m hadoop -s /bin/bash #创建hadoop用户,并使用/bin/bash作为shell

$ sudo passwd hadoop #为hadoop用户设置密码,之后需要连续输入两次密码

$ sudo adduser hadoop sudo #为hadoop用户增加管理员权限

$ su - hadoop #切换当前用户为用户hadoop

$ sudo apt-get update #更新hadoop用户的apt,方便后面的安装

二、安装SSH,设置SSH无密码登陆

$ sudo apt-get install openssh-server #安装SSH server

$ ssh localhost #登陆SSH,第一次登陆输入yes

$ exit #退出登录的ssh localhost

$ cd ~/.ssh/ #如果没法进入该目录,执行一次ssh localhost

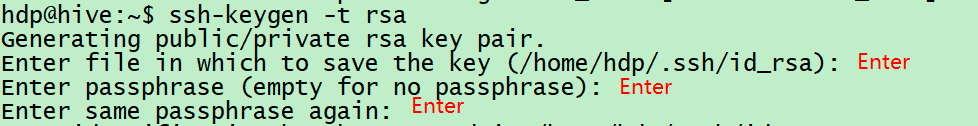

$ ssh-keygen -t rsa

输入完 $ ssh-keygen -t rsa 语句以后,需要连续敲击三次回车,如下图

其中,第一次回车是让KEY存于默认位置,以方便后续的命令输入。第二次和第三次是确定passphrase,相关性不大。

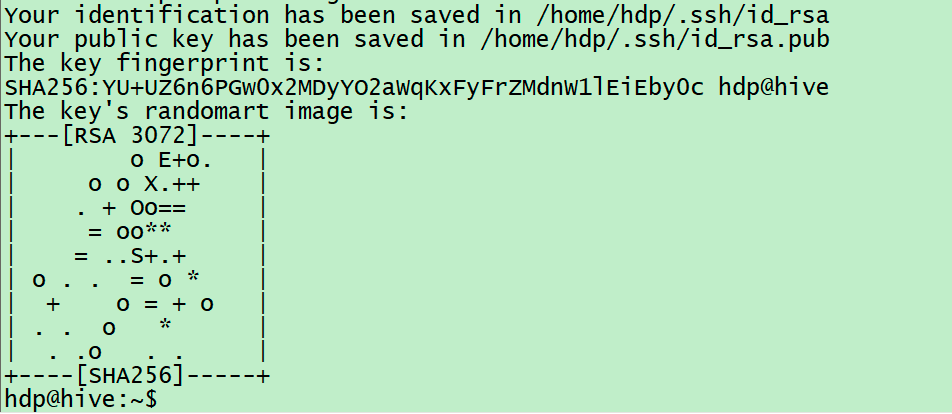

两次回车输入完毕以后,如果出现类似于下图所示的输出,即成功:

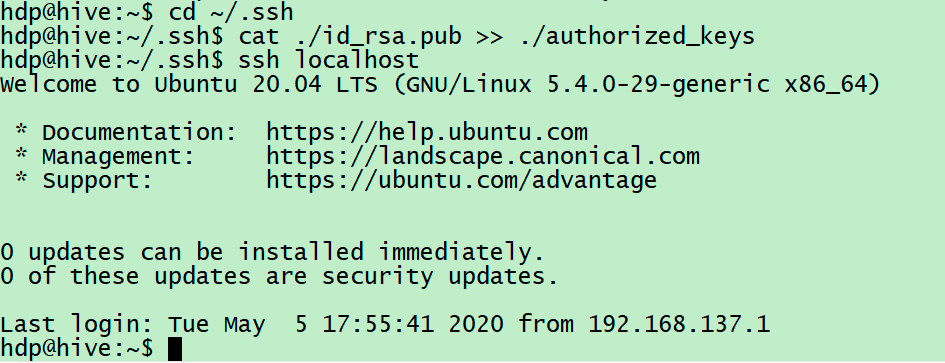

然后继续输入:

$ cat ./id_rsa.pub >> ./authorized_keys #加入授权

$ ssh localhost #此时已不需密码即可登录localhost,并可见下图。如果失败则可以搜索SSH免密码登录来寻求答案

在此之前先将jdk安装好

三、安装hadoop-2.6.0

$ sudo tar -zxvf hadoop-2.6.0.tar.gz -C /usr/local #解压到/usr/local目录下

$ cd /usr/local

$ sudo mv hadoop-2.6.0 hadoop #重命名为hadoop

$ sudo chown -R hadoop ./hadoop

安装好后,在hadoop用户下给hadoop配置环境变量,若用户不是hadoop则输入 su - hadoop切换用户

切换完成后输入 vi /etc/profile(权限要求root)

在文件底部添加

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

:wq 保存文件后执行source /etc/profile使设置生效。

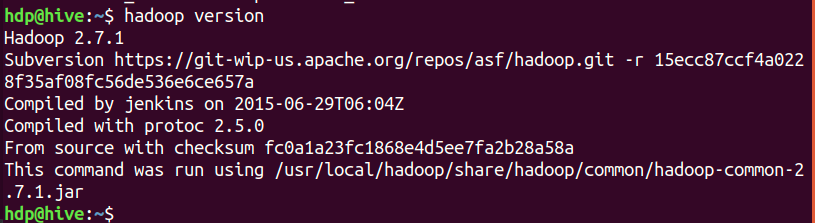

安装完成后输入 hadoop version 查看:

四、伪分布式配置

1、先将 jdk1.8 的路径添加到 hadoop-env.sh 中

2、修改core-site.xml文件:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

wq保存

3、接下来修改配置文件 hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

配置完成后,执行 NameNode 的格式化

hdfs namenode -format

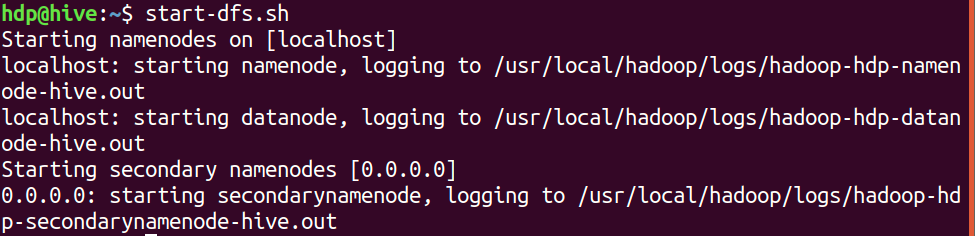

然后启动namenode和datanode进程,并查看启动结果

$ start-dfs.sh

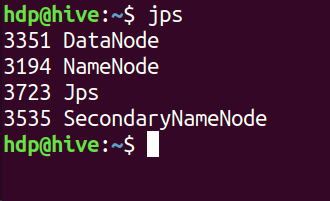

$ jps

启动完成后,可以通过命令 jps 来判断是否成功启动,若成功启动则会列出如下进程: “NameNode”、”DataNode” 和 “SecondaryNameNode”

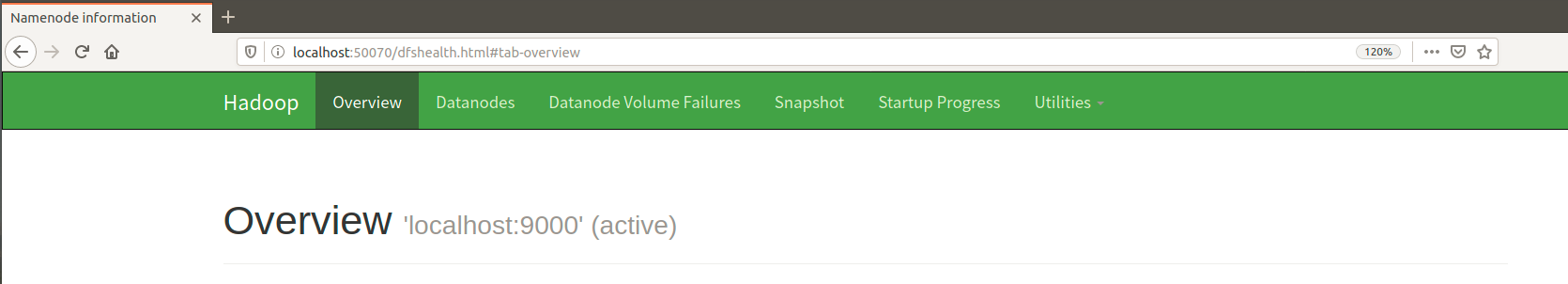

进入ubuntu-Firefox中输入http://localhost:50070,若出现以下画面,则代表hadoop配置成功