郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布!

PLOS COMPUTATIONAL BIOLOGY, (2008): e1000180-e1000180

Abstract

奖励调节的脉冲时序依赖可塑性(STDP)最近已成为学习规则的候选者,该规则可以解释如何通过局部突触可塑性以自组织方式实现复杂的脉冲神经网络中行为相关的自适应变化。然而,到目前为止,这种学习规则的能力和局限性只能通过计算机模拟来测试。本文提供了对奖励调节的STDP进行分析处理的工具,这使我们能够预测在哪些条件下奖励调节的STDP将达到预期的学习效果。这些分析结果表明,神经元可以通过奖励调节的STDP学习,不仅可以对突触前神经元的空间发放模式进行分类,还可以对时间发放模式进行分类。他们还可以学习以特定的脉冲模式对特定的突触前发放模式做出反应。最后,由此产生的学习理论预测,即使是困难的信度分配问题,也很难判断应该修改哪些突触权重以增加系统的全局奖励,可以通过奖励调节的STDP以自组织方式解决。这为Fetz和Baker对猴子生物反馈的基本实验结果提供了解释。在这个实验中,猴子因增加皮层中特定神经元的发放率而获得奖励,并且能够解决这个极其困难的信度分配问题。我们的这个实验模型依赖于奖励调节的STDP与可变的自发发放活动的组合。因此,它还为试验间变异性提供了一种可能的功能解释,这是神经元皮质网络的特征,但在当前现有的人工计算系统中没有类似物。此外,我们的模型表明,奖励调节的STDP可以应用于大型循环神经网络中的所有突触,而不会危及网络动态的稳定性。

Author Summary

计算神经科学的一个主要开放问题是解释学习,即中枢神经系统中与行为相关的修改,如何可以基于突触可塑性的实验数据来解释。脉冲时序依赖可塑性(STDP)是单个突触强度变化的规则,该规则由来自各种物种的实验数据支持。然而,尚不清楚这种突触可塑性规则如何在神经元网络中产生有意义的修改。只有考虑到突触可塑性的巩固需要第三个信号,例如神经调节剂浓度的变化(例如,可能与奖励或期望奖励有关),那么神经元网络的结构可能会发生有意义的变化。我们在本文中为这种奖励调节的STDP版本提供了分析基础,该版本可以预测这种类型的突触可塑性何时可以在神经元网络中产生功能相关的变化。特别是,我们展示了看似莫名其妙的生物反馈实验数据,其中一只猴子学会了增加运动皮层中任意选择的神经元发放率,可以根据这种新的学习理论来解释。

Introduction

大量实验研究(参见[1]的综述;[2]讨论了更近期的体内结果)表明突触功效依赖于突触前和突触后神经元的发放时间tpre和tpost之间的时差Δt= tpost - tpre。这种效应称为脉冲时序依赖可塑性(STDP)。但是,理解生物有机体学习的一个主要难题是,在微观层面上实验确立的STDP规则与宏观层面上生物有机体行为的适应性变化之间的关系。神经调节系统向大脑中的几个大型神经元网络发送与增强(奖励)和行为状态相关的扩散信号,已被确定为与这两个可塑性水平相关的可能中介。众所周知,响应突触前和突触后神经元活动的突触权重变化的巩固需要存在这种第三信号[3,4]。特别是,已经证明多巴胺(在行为上与新颖性和奖励预测相关[5])可控制皮质纹状体突触[6,7]和皮层内[8]的可塑性。还表明,乙酰胆碱可控制皮质中的突触可塑性(参见例如[9]和[10,11]包含对文献的精彩回顾)。

形式突触可塑性的相应基于脉冲的规则:

![]()

在[12]和[13]中已经提出(参见图1以了解该学习规则的说明),其中wji是从神经元 i 到神经元 j 的突触权重,cji(t)是该突触的资格迹,收集STDP提出的权重变化,并且![]() 来自具有平均值

来自具有平均值![]() 的神经调节信号h(t)。在[12]中表明,大型神经元网络中的许多有趣的学习任务可以通过公式1中的这个简单规则来完成。最近表明,当应用从[14]到脉冲神经网络[13,15]的分布式强化学习的通用框架时,或者如果在所需的发放时间最大化突触后发放的可能性[16],会出现非常相似的脉冲神经元学习规则。然而,没有可用的分析工具可以预测哪些学习任务以及在哪些参数设置下,奖励调节的STDP将是成功的。本文提供了这样的分析工具,并通过各种计算机模拟证明了它们的适用性和意义。特别是,我们确定了神经元可以通过奖励调节的STDP学习的条件,以对时序突触前发放模式进行分类,并以特定的脉冲模式作出反应。

的神经调节信号h(t)。在[12]中表明,大型神经元网络中的许多有趣的学习任务可以通过公式1中的这个简单规则来完成。最近表明,当应用从[14]到脉冲神经网络[13,15]的分布式强化学习的通用框架时,或者如果在所需的发放时间最大化突触后发放的可能性[16],会出现非常相似的脉冲神经元学习规则。然而,没有可用的分析工具可以预测哪些学习任务以及在哪些参数设置下,奖励调节的STDP将是成功的。本文提供了这样的分析工具,并通过各种计算机模拟证明了它们的适用性和意义。特别是,我们确定了神经元可以通过奖励调节的STDP学习的条件,以对时序突触前发放模式进行分类,并以特定的脉冲模式作出反应。

我们还为[17]的显著操作性条件反射实验提供了一个模型(另见[18,19])。在这些更简单的实验中,记录了单个神经元(在猴子皮层中央前回区域4)的脉冲活动,通过照明仪表臂的位移,猴子可以看到任意选择的神经元的当前发放率与其平均发放率的偏差,其右侧位置对应于馈线放电的阈值。猴子因增加(或在交替试验中降低)该神经元的发放率而获得食物奖励。猴子非常可靠地(在几分钟内)学会了改变这个神经元在当前奖励方向上的发放率。相邻的神经元倾向于在相同方向上改变它们的发放率,但在[17]中报告了成对神经元发放率方向的差异变化(当这些差异变化得到奖励时)。例如,[17]的图9(另见[19]中的图1)显示,相隔不超过几百微米的神经元对可以独立训练以提高或降低它们的发放率。显然,大脑中存在能够解决这一极其困难的信度分配问题的学习机制,为理解大脑中的学习组织提供了重要线索。我们在本文中分析研究了奖励调节STDP在什么条件下能够解决此类学习问题。我们通过对生物学上非常现实的循环连接的神经元网络进行计算机模拟来测试分析得出的预测的正确性,其中通过奖励(发送到这个循环网络中兴奋性神经元之间所有142813个突触)。我们还为[17]中更复杂的操作性条件反射实验提供了一个模型,表明可以通过奖励调节的STDP对神经元对进行差异化训练,其中一个神经元因提高其发放率而获得奖励,同时另一个神经元因降低其发放率而获得奖励。更准确地说,我们增加了奖励信号d(t),每当第一个神经元发放时,它就会传输到网络中兴奋性神经元之间的所有突触,并在第二个神经元发放时减少这个奖励信号(由此产生的组合奖励对应于在这些更复杂的操作性条件反射实验中向猴子展示的仪表臂的位移)。

我们的理论和计算机模拟还表明,奖励调节的STDP可以长时间应用于大型神经元网络中的所有突触,而不会危及网络的稳定性。特别是这种突触可塑性规则使网络保持在异步不规则发放状态内,这在[20]中被描述为类似于皮层自发活动的动态状态。使用奖励调节STDP进行学习的另一个有趣方面是,它需要在学习发生的神经元网络内自发发放和试验间的变异性。因此,我们针对这种突触可塑性规则的学习理论为功能性解释神经元皮质网络的这些特征提供了基础,这些特征从大多数计算理论的角度来看是不受欢迎的。

Results

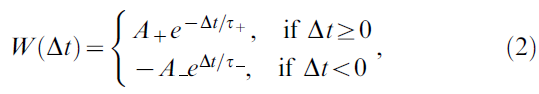

我们首先在等式1中给出了奖励调节STDP学习规则的精确定义。STDP的标准规则是根据突触前和突触后神经元的发放时间tpre和tpost之间的时差Δt=tpost - tpre指定兴奋性突触的突触权重的变化W(Δt),它基于许多实验数据(见[1])。它通常由以下形式的所谓学习曲线建模:

其中正常数A+和A-分别衡量增强和抑制的强度,τ+和τ-是定义正负学习窗口宽度的正时间常数。对于突触前脉冲序列![]() 和突触后脉冲序列

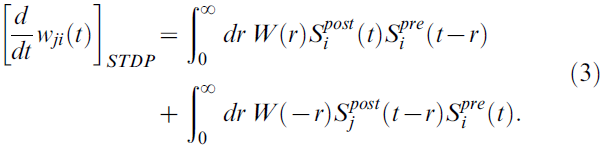

和突触后脉冲序列![]() 在时间 t 的突触 ji 的权重变化通常通过将此学习规则瞬时应用于所有脉冲配对与时间 t 的第二个脉冲来建模[21]:

在时间 t 的突触 ji 的权重变化通常通过将此学习规则瞬时应用于所有脉冲配对与时间 t 的第二个脉冲来建模[21]:

神经元 i 的脉冲序列在时间![]() 在这里由狄拉克三角函数的总和形式化

在这里由狄拉克三角函数的总和形式化![]() 。

。

本文分析的模型基于这样的假设,即STDP建议的所有突触 ji 处突触前和突触后脉冲对的正负权重变化(根据公式3中的两个积分)收集在突触部位的资格迹cji(t)。在时间t - s与第二个脉冲的所有脉冲配对对cij(t)的贡献由函数fc(s)为s>0建模(参见图1A);本文假设资格迹的时间尺度为秒级。因此,在时间 t 的突触 ji 的资格迹的值由下式给出:

![]()

参见图1B。对于奖励调节的STDP,在时间 t 的实际权重变化![]() 是资格迹与公式1定义的奖励信号d(t)的乘积cij(t) · d(t)。由于这个简单的模型原则上可以导致权重的无限增长,我们假设权重在下边界值0和上边界wmax处被裁剪。

是资格迹与公式1定义的奖励信号d(t)的乘积cij(t) · d(t)。由于这个简单的模型原则上可以导致权重的无限增长,我们假设权重在下边界值0和上边界wmax处被裁剪。

兴奋性神经元之间的所有连接都受STDP影响的脉冲神经元模拟循环网络的网络动力学对所使用的特定STDP规则非常敏感。因此,我们不仅使用等式3中的加性STDP规则(其效果可以从理论上分析)进行了网络模拟,而且还使用了[22]中提出的更复杂的规则(它适合于海马神经元的实验数据[23]),其中权重变化的幅度取决于权重的当前值。在我们的生物反馈实验(计算机模拟1)以及学习模式分类(计算机模拟4)的网络模拟中产生的这个STDP规则的实现(具有[22]中提出的参数)在定量上与在等式3中规则的结果相同。

Theoretical Analysis of the Resulting Weight Changes

Application to Models for Biofeedback Experiments

Computer Simulation 1: Model for Biofeedback Experiment

Rewarding Spike-Times

Computer Simulation 2: Learning Spike Times

Computer Simulation 3: Testing the Analytically Derived Conditions

Pattern Discrimination with Reward-Modulated STDP

Computer Simulation 4: Learning Pattern Classification

Computer Simulation 5: Training a Readout Neuron with Reward-Modulated STDP To Recognize Isolated Spoken Digits

Methods

Linear Poisson Neuron Model

Learning Equations

Derivation of Equation 6.

Simplification of Equation 6.

Derivations for the Biofeedback Experiment

Weight change for the reinforced neuron (derivation of Equation 10)

Weight change for non-reinforced neurons (derivation of Equation 11)

For uncorrelated neurons, Equation 11 evaluates to zero.

Analysis of Spike-Timing-Dependent Rewards (Derivation of Conditions 13–15)

Analysis of the Pattern Discrimination Task (Derivation of Equation 17)

Common Models and Parameters of the Computer Simulations

LIF Neuron Model

Short-Term Dynamics of Synapses

Model of Background Synaptic Activity

Reward-Modulated STDP

Initial Weights of Trained Neurons

Software

Details to Individual Computer Simulations

Cortical Microcircuits

Readout Neurons

Details to Computer Simulation 1: Model for Biofeedback Experiment

Details to Computer Simulation 2: Learning Spike Times

Details to Computer Simulation 3: Testing the Analytically Derived Conditions

Details to Computer Simulation 4: Learning Pattern Classification

Details to Computer Simulation 5: Training a Readout Neuron with Reward-Modulated STDP To Recognize Isolated Spoken Digits

Spike representations of speech utterances.

Training procedure.

Cortical microcircuit details.

Discussion

我们在本文中介绍了分析工具,这些工具可以预测在哪些条件下奖励调节STDP将在神经元网络中实现给定的学习目标。这些条件指定了奖励调节STDP学习规则的规范中涉及的参数和辅助函数(STDP的学习曲线、资格迹、奖励信号等)之间的关系。尽管我们的分析结果是基于一些简化的假设,但我们已经表明,它们很好地预测了神经元皮质网络相当复杂模型的计算机模拟结果。

我们已经将这种奖励调节STDP的学习理论应用于许多生物学相关的学习任务。我们已经证明Fetz and Baker [17]的生物反馈结果原则上可以基于奖励调节STDP来解释。潜在的信度分配问题非常困难,因为猴脑没有关于神经元身份的直接信息,其发放率与接收奖励相关。从单个突触的角度来看,这个信度分配问题甚至更加困难,因此对于应用局部突触可塑性规则(例如奖励调节STDP)而言。然而,我们的理论分析(见公式10和11)表明,突触权重的长期演变仅取决于突触前和突触后脉冲对与奖励信号的相关性。因此,奖励神经元的发放率在几个分钟的模拟生物时间内增加(对于由4000个基于电导的LIF神经元组成的循环网络的计算机模拟,这些神经元具有典型的体内条件的真实背景噪声,以及表现出基于数据的短期突触可塑性的228954个突触),就像在[17]的实验数据中一样,而其他神经元的发放率保持不变)见图4B)。我们还能够以这种方式模拟两个神经元的差异强化(图2)。尽管所有兴奋性突触都不断受到奖励调节STDP的影响,但这些计算机模拟证明了网络动态的显著稳定性(参见图2A、4A和5)。特别是,电路保持在异步不规则发放状态,类似于皮层中的自发发放活动[9]。其他维持这种发放机制的STDP规则(没有奖励调节)之前已经在[22]中展示过。在[17]中也有报道,并在[46]中进一步研究,在Fetz and Baker的生物反馈实验中,强化神经元的爆发通常伴随着特定肌肉的激活。但据报道,中枢前运动皮层中记录的神经元的爆发与肌肉激活之间的关系非常复杂,并且经常在单独继续强化神经元后退出。此外,在[46]中表明,该研究中测试的所有神经元都可以通过差异增强同时抑制EMG活动而与其相关的肌肉活动分离。这些结果表明,猴子对信度分配问题的解决(以更强地激活其中央前回中数十亿神经元中被强化的神经元)可能得到了与肌肉激活相关的大规模探索策略的支持。但是前面提到的关于两个附近神经元的差异增强的结果表明,这种大规模的探索策略必须通过在更精细的空间尺度上的探索来补充,这很难根据肌肉激活来解释(参见[19]的详细讨论)。

虽然这项学习任务侧重于发放率,但我们还表明(参见图7)神经元可以通过奖励调节STDP学习以响应具有特定脉冲序列的输入,即特定的时间输出模式。在[27]中已经指出,对于奖励调节STDP,这是一个特别困难的学习任务,并且在那里表明,它可以通过修改的STDP规则和更复杂的奖励预测信号来完成而没有延迟。我们通过推导特定条件(公式13-15)补充了[27]的结果,在这些条件下,该学习任务可以通过奖励调节STDP的标准版本来解决。广泛的计算机模拟表明,对于更简单的神经元模型,这些分析得出的条件也可以预测具有基于电导的突触的LIF神经元是否能够解决该学习任务。图8表明,这种奖励调节STDP的学习理论也能够很好地预测神经元学习产生所需时间输出模式的速度。[27]的一个有趣方面是,还探索了提供有关奖励期望变化信息的第三个信号的效用。我们在本文中只考虑了无法进行奖励预测的学习场景。合乎逻辑的下一步是将我们的奖励调节STDP学习理论扩展到包括奖励预测在内的经典强化学习理论的场景。

我们还解决了神经元可以在多大程度上通过奖励调节STDP学习以不同的发放率响应不同的时空突触前发放模式的问题。[12]中已经表明,这种学习规则使神经元能够对空间发放模式进行分类。 我们通过推导此学习场景中预期权重变化的分析表达式来补充这项工作(参见公式17),它阐明了神经元可以在多大程度上通过奖励调节STDP学习以区分突触前发放模式的时间结构的差异。该理论分析表明,在极端情况下,所有传入信息都以突触前脉冲的相对时间编码,奖励调节STDP无法为选定的突触前发放模式产生更高的平均膜电位,即使这会得到奖励。但它能够增加膜电位的方差,从而增加任何具有(与简单的线性泊松神经元不同)发放阈值的神经元模型的脉冲数。图9中的模拟结果证实,通过这种方式,LIF神经元可以学习标准版本的奖励调节STDP,通过响应其中一种模式产生更多的脉冲来区分甚至纯粹的时序突触前发放模式。

一个令人惊讶的特征是,尽管神经元在这里仅因对一种突触前发放模式P以更高的发放率做出响应而得到奖励,但它会自动开始以特定的时间脉冲模式响应这种模式P,这种模式在训练期间会随着时间的推移而提前(参见图9A)。

最后,我们已经证明,可以通过奖励调节STDP训练脉冲神经元,以从模拟的皮层微电路中读取信息(参见图10)。这是令人感兴趣的,因为之前的工作[31,34,47]已经表明,通用皮层微电路模型具有固有的能力,可以作为此类读出神经元的预处理器,通过以不同的线性和非线性方式组合包含在电路脉冲输入的不同时间段中的信息("液体计算模型")。口语单词的分类(首先转化为脉冲序列)已被引入作为通用基准任务,用于评估使用脉冲神经元进行计算的不同方法[31–33,45,48]。但到目前为止,所有基于学习(而不是聪明的结构)的方法都必须依赖于对简单线性读数的监督训练。这引发了一个问题,是否也可以通过生物学上更合理的学习场景来训练读出神经元的生物学上更合理的模型来对口语进行分类。图10的结果可以解释为对这个问题的初步肯定回答。我们已经证明,具有基于电导的突触(受生物学合理短期可塑性影响)的LIF神经元可以在没有监督者的情况下通过奖励调节STDP对口语数字进行分类。与图9的结果相反,这里出现的输出代码是一个发放率代码。这可以通过电路对同一单词的不同发音的显著类内差异来解释(参见图10C和10D)。虽然LIF神经元在没有监督者的情况下在这里学习,以不同的发放率响应同一说话者的不同单词的话语(而在学习开始时两个单词的发放率输出非常相似,参见图10E),这些神经元的分类能力尚未达到主管训练的线性读数水平(例如,还不能以这种方式实现与说话者无关的词分类)。需要进一步的工作来测试LIF读出神经元的分类能力是否可以通过皮层微电路模型中的额外预处理、奖励调节STDP规则的适当变化或通过不同的学习场景(模仿例如也修改突触前回路的发育学习)。

奖励调节STDP的新学习理论也将有助于生物学实验,这些实验旨在澄清大脑不同部位突触可塑性的生物学实现细节,因为它允许预测哪些类型的信号和时间过程对于特定范围的学习任务是最佳的。对于前面讨论的每个学习任务,理论分析提供了保证成功学习的奖励信号d(t)结构的条件。例如,在生物反馈学习场景中(图4),强化神经元的每个动作电位都会在一些延迟之后导致奖励信号d(t)的变化。这种变化的形状由奖励核ε(r)定义。我们的分析表明,只要核上的积分为零,并且核与资格函数的乘积上的积分为正,就可以相当随意地选择这个奖励核。对于另一个学习场景,目标是某个神经元 j 的输出脉冲序列![]() 近似于某个目标脉冲序列S*的脉冲时序(图7),奖励信号必须依赖于

近似于某个目标脉冲序列S*的脉冲时序(图7),奖励信号必须依赖于![]() 和 S*。奖励信号对这些脉冲时间的依赖性由奖励核κ(r)定义。我们的分析表明,必须为此任务选择奖励核,以便如果突触后神经元在接近目标脉冲序列S*中的脉冲时间或更晚的时间发放,则突触获得正奖励,而在输出脉冲出现的时间早了大约10毫秒时获得负奖励。在图9的模式辨别任务中,每个突触后动作电位都在经过一段时间的延迟后跟随奖励信号的变化,这取决于所呈现的模式。我们的理论分析预测,如果公式18定义的积分

和 S*。奖励信号对这些脉冲时间的依赖性由奖励核κ(r)定义。我们的分析表明,必须为此任务选择奖励核,以便如果突触后神经元在接近目标脉冲序列S*中的脉冲时间或更晚的时间发放,则突触获得正奖励,而在输出脉冲出现的时间早了大约10毫秒时获得负奖励。在图9的模式辨别任务中,每个突触后动作电位都在经过一段时间的延迟后跟随奖励信号的变化,这取决于所呈现的模式。我们的理论分析预测,如果公式18定义的积分![]() 和

和![]() 满足

满足![]() 和

和![]() 。再一次,对于一大类奖励核满足了这个约束,一个自然的选择是使用非负奖励核。目前没有关于生物神经系统中奖励核形状的数据。先前概述的理论分析对奖励核的形状进行了具体预测(取决于涉及生物神经系统的学习任务的类型),这可能会通过生物实验进行测试。

。再一次,对于一大类奖励核满足了这个约束,一个自然的选择是使用非负奖励核。目前没有关于生物神经系统中奖励核形状的数据。先前概述的理论分析对奖励核的形状进行了具体预测(取决于涉及生物神经系统的学习任务的类型),这可能会通过生物实验进行测试。

我们在本文中提出的学习理论的一个有趣的一般方面是,它需要在神经回路中进行大量的试验变化,这通常被视为理论上理想神经元的回路的不完美生物学实现的"噪音"。这种奖励调节STDP的学习理论表明,噪声的主要功能作用是维持适当水平的自发发放(因为如果神经元不发放,它无法确定这是否会得到奖励),这应该因试验而异,以探索奖励哪种发放模式([31,34,47]中已经表明,这种高度可变的电路活动与线性读数的稳定性能兼容)。另一方面,如果一个神经元的发放主要是基于直接注入该神经元的噪声电流,而不是基于突触前活动,那么STDP对该神经元的突触连接没有所需的影响(参见图S6)。这一观点为后续研究打开了大门,这些研究将针对具体生物学习任务的理论推导的最佳数量和试验间变异性的分布与相应的实验数据进行比较。

Related Work

Conclusion

奖励调节的STDP是一个非常有前途的突触可塑性规则候选者,它能够协调局部突触修改,从而可以实现和维持更大的神经元网络的特定功能特性(我们参考[12]和[27]讨论此可塑性规则的潜在生物学实现)。我们在本文中提供了分析工具,这些工具不仅可以通过计算机模拟,而且可以通过理论分析来评估该规则和该规则的变体。特别是,我们已经表明,只有在所涉及的参数之间存在某些关系时,成功的学习才是可能的。其中一些预测的关系可以通过生物实验进行测试。

只要满足这些关系,奖励调节的STDP就成为一个强大的规则,可以在大型循环神经网络中实现突触权重的自组织。特别是,它使我们能够解释看似莫名其妙的关于猴子生物反馈的实验数据。此外,奖励调节STDP使神经元能够区分突触前神经元的复杂发放模式,即使对于基于数据的标准STDP形式也是如此,并且不需要监督者告诉神经元何时应该发放脉冲。此外,奖励调节的STDP需要大量的自发活动和试验间的变异性以支持成功的学习,从而为神经元皮质网络的这些普遍存在的特征提供功能解释。事实上,在这种情况下,不仅自发活动而且STDP本身都可以被视为一种支持在循环网络中探索不同发放链的机制,直到找到一个解决方案,因为它支持网络的成功计算功能而获得奖励。

Supporting Information