本次作业来源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/2881

1. 简单说明爬虫原理

网络爬虫,即Web Spider,是一个很形象的名字。把互联网比喻成一个蜘蛛网,那么Spider就是在网上爬来爬去的蜘蛛。网络蜘蛛是通过网页的链接地址来寻找网页的。从网站某一个页面(通常是首页)开始,读取网页的内容,找到在网页中的其它链接地址,然后通过这些链接地址寻找下一个网页,这样一直循环下去,直到把这个网站所有的网页都抓取完为止。如果把整个互联网当成一个网站,那么网络蜘蛛就可以用这个原理把互联网上所有的网页都抓取下来。这样看来,网络爬虫就是一个爬行程序,一个抓取网页的程序。网络爬虫的基本操作是抓取网页。

2. 理解爬虫开发过程

1).简要说明浏览器工作原理;

浏览器的主要功能是将用户选择的web资源呈现出来,它需要从服务器请求资源,并将其显示在浏览器窗口中,资源的格式通常是HTML,也包括PDF、image及其他格式。用户用URI来指定所请求资源的位置,在网络一章有更多讨论。

2).使用 requests 库抓取网站数据;

requests.get(url) 获取校园新闻首页html代码

import requests

requests

url='http://news.gzcc.cn/html/2019/xiaoyuanxinwen_0320/11029.html'

res=requests.get(url)

type(res)

res.encoding='utf-8'

res.text

3).了解网页

写一个简单的html文件,包含多个标签,类,id

html_sample = '

<html>

<body>

<h1 id="title">Hello</h1>

<a href="#" class="link"> This is link1</a>

<a href="# link2" class="link" qao=123> This is link2</a>

</body>

</html> '

4).使用 Beautiful Soup 解析网页;

通过BeautifulSoup(html_sample,'html.parser')把上述html文件解析成DOM Tree

soupn=BeautifulSoup(res.text,'html.parser')

soupn

select(选择器)定位数据

#使用select找出含有h1标签的元素,返回list

header=soups.select('h1')

#使用select找出特定CSS属性的元素

t = soups.select('#title')

l = soups.select('.link')

找出含有特定标签的html元素

找出含有特定类名的html元素

找出含有特定id名的html元素

soups = BeautifulSoup(html,'html.parser')

a1 =soups.a

a = soups.select('a')

h = soups.select('h1')

t = soups.select('#title')

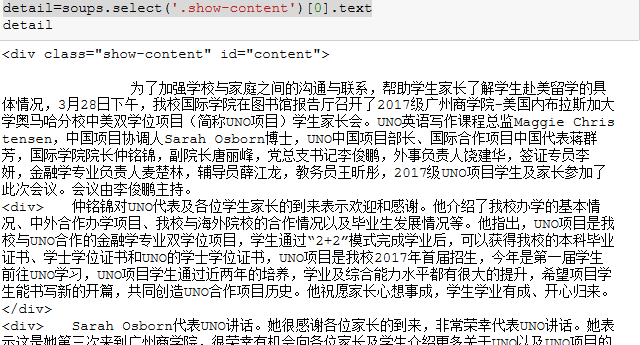

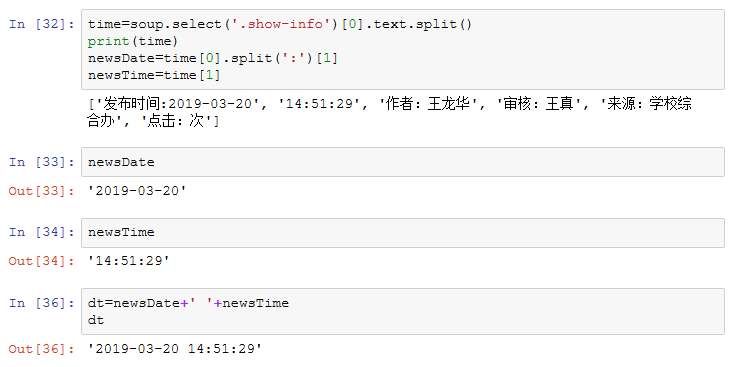

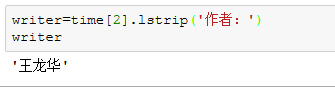

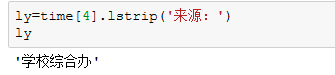

3.提取一篇校园新闻的标题、发布时间、发布单位、作者、点击次数、内容等信息

如url = 'http://news.gzcc.cn/html/2019/xiaoyuanxinwen_0320/11029.html'

要求发布时间为datetime类型,点击次数为数值型,其它是字符串类型。

新闻的标题:

发布时间

作者:

发布单位:

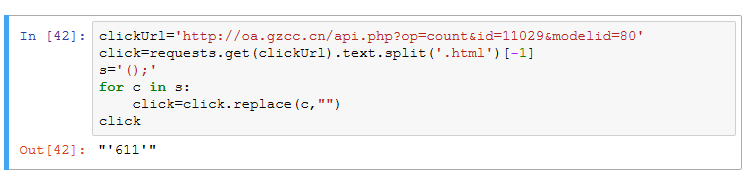

点击次数:

内容: