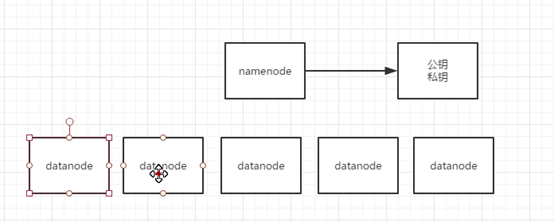

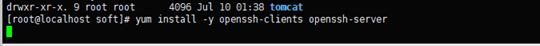

1.ssh免秘钥登录

参考http://www.powerxing.com/install-hadoop/

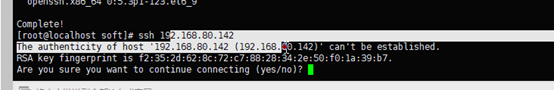

ssh localhost

exit # 退出刚才的 ssh localhost

cd ~/.ssh/ # 若没有该目录,请先执行一次ssh localhost

ssh-keygen -t rsa # 会有提示,都按回车就可以

cat ./id_rsa.pub >> ./authorized_keys # 加入授权

2.Hadoop配置(伪分布)

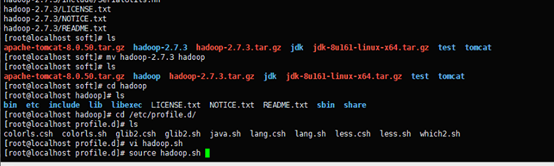

2.1导入Hadoop压缩包,解压

tar -zxvf hadoop-2.7.3.tar.gz

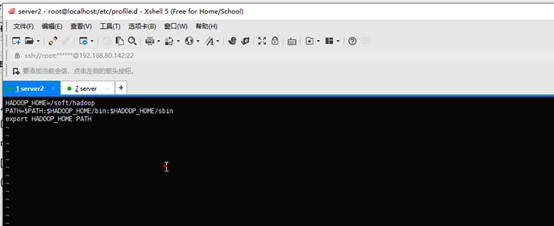

2.2 配置环境变量

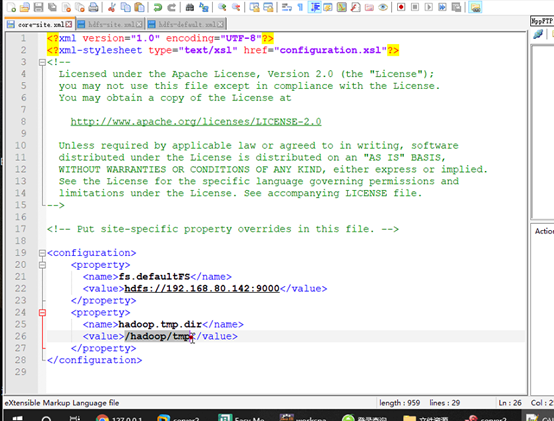

2.3 配置XML文件

core-site

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

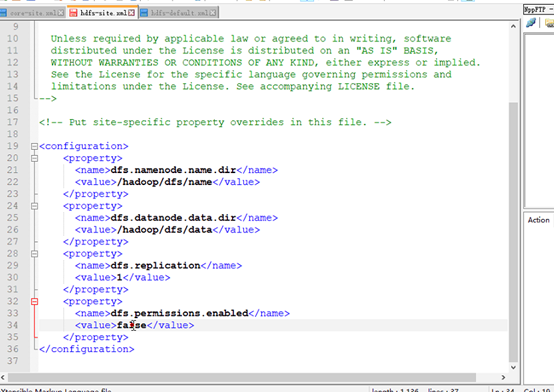

hdfs-site

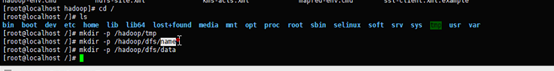

2.4格式化

hadoop namenode -format

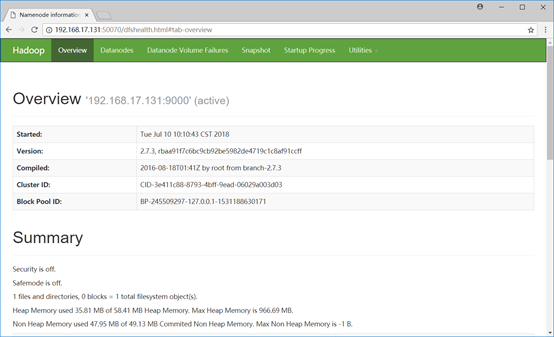

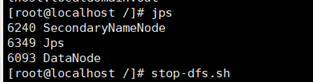

2.5启动HDFS

start-dfs.sh

HDFS基本命令

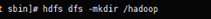

新建文件夹

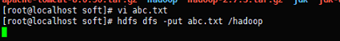

上传文件

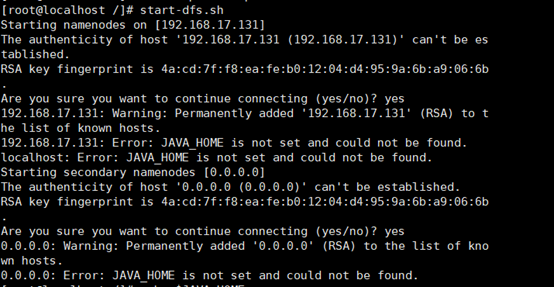

配置完报错

JAVA_HOME找不到

echo $JAVA_HOME 可以显示出来但是Hadoop找不到,具体原因暂不清楚

参考博客https://blog.csdn.net/dianzishijian/article/details/52094569

修改hadoop/etc/hadoop目录下的hadoop-env.sh

将语句 export JAVA_HOME=$JAVA_HOME

修改为 export JAVA_HOME=/soft/jdk(jdk路径)

保存后退出。

再次输入start-dfs.sh启动hadoop,成功。

Namenode无法启动

重新格式化 问题解决