Hadoop综合大作业 要求:

1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

选一篇小说写

启动hadoop

Hdfs上创建文件夹

上传文件至hdfs

启动Hive

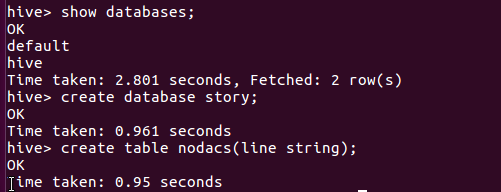

创建原始文档表

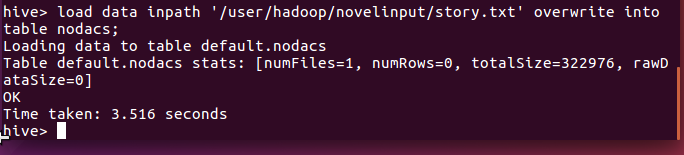

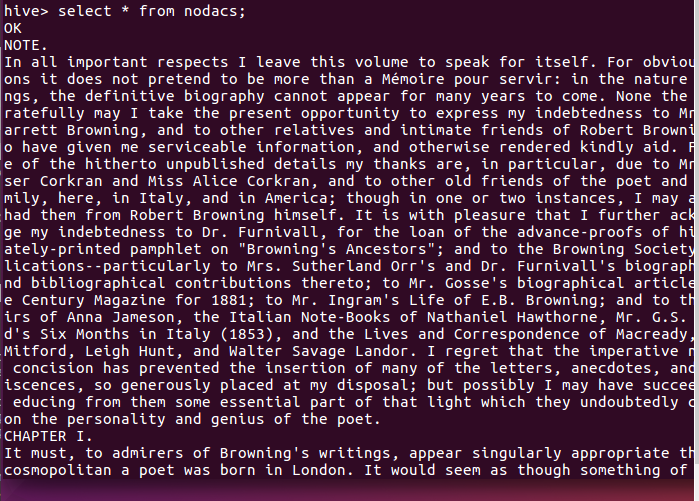

导入文件内容到表nodacs并查看

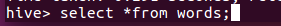

用HQL进行词频统计,结果放在表words里

查看统计结果

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

我爬取的京剧网信息词频统计后放到op.csv文件中:

将文件保存在邮箱,下载到虚拟机中,复制并改为csv模式

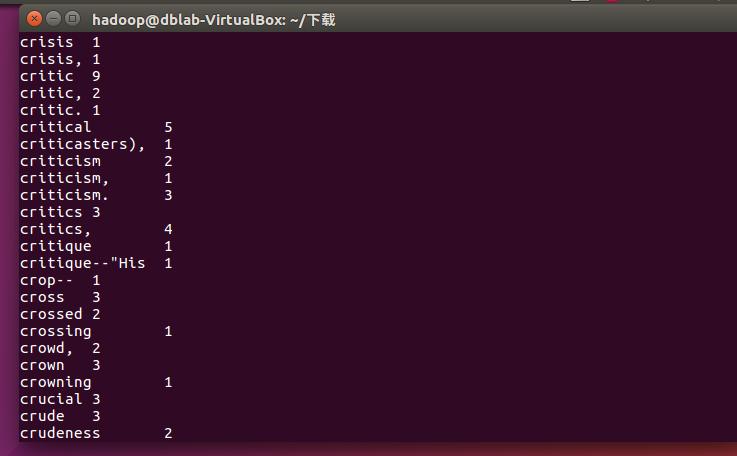

将本地系统hadoop文件夹里的op.csv上传至hdfs的openginput文件夹中:

查看hdfs上的op.csv文件前20条数据的内容:

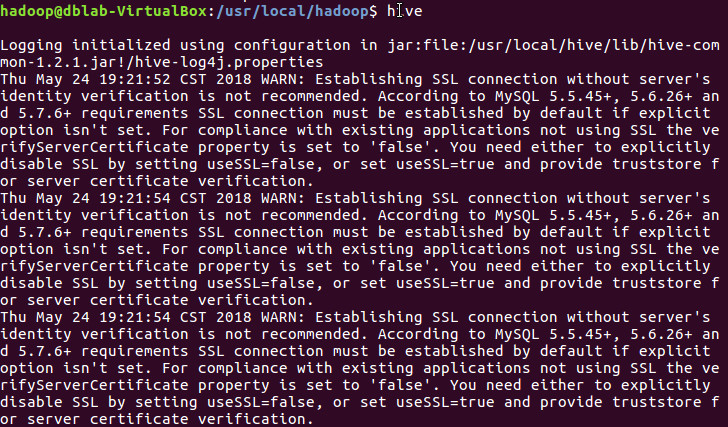

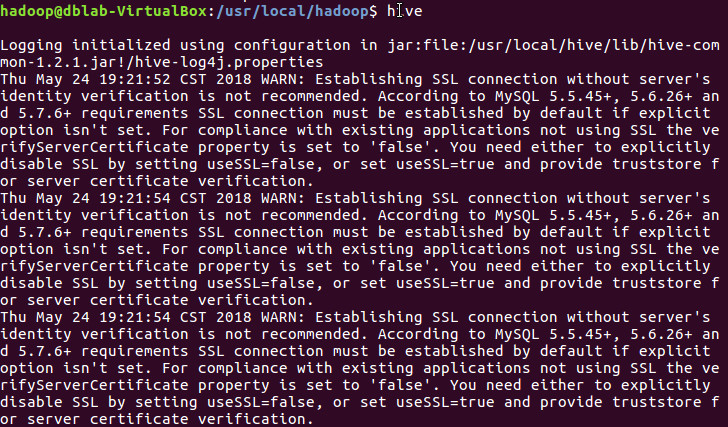

启动Hive

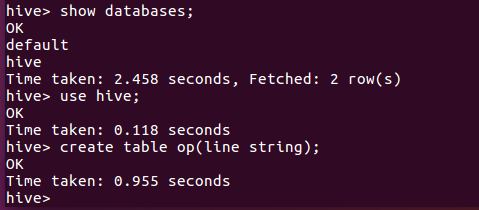

在数据库hive里创建文档表op:

导入文件内容到表op:

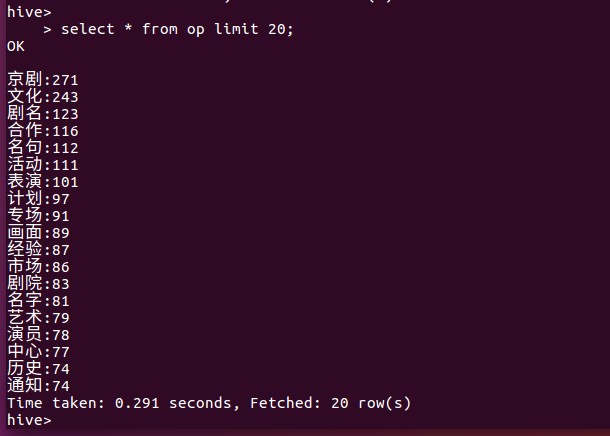

查看表的前20条数据: