一、安装jdk、hadoop

- 解压jdk、hadoop压缩包:

注意在主节点上解压安装

# tar -zxvf jdk-8u201-linux-x64.tar.gz -C /usr/lcoal/src

# tar -zxvf hadoop-2.6.0.tar.gz -C /usr/local

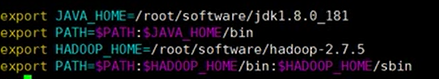

2. 配置环境变量 编辑/etc/profile文件:

加入(里面的安装目录自己修改!!)

配置机器映射关系:(如何修改Linux系统IP地址自己问百度)

master主机:/etc/hostname 修改主机主节点为 master 修改IP地址192.168.56.1

在每台机器 /etc/hosts文件添加:

192.168.56.1 master

192.168.56.2 slaves

192.168.56.3 slaves2

slaves:/etc/hostname 修改为slaves 修改IP地址192.168.56.2

slaves2:/etc/hostname 修改为slaves2 修改IP地址192.168.56.3

完成这一步所有机器重启生效。

3.配置免密码登录ssh:

# ssh-keygen -t rsa

# cd .ssh/

# ssh-copy-id master

# ssh-copy-id slaves

# ssh-copy-id slaves2

测试登录:

# ssh master

# chmod 600 ~/.ssh/authorized_keys

4. 配置hadoop文件:

在本人园子内的hadoop随笔内,请查看另一篇文档。

格式化文件:

# cd /usr/local/hadoop

# bin/hdfs namenode -format

5.将文件发送到奴隶节点:

#scp -r /etc/profile slaves:/etc/profile

#scp -r /etc/profile slaves2:/etc/profile

# scp -r /usr/local/src/jdk1.8.0_201 slaves:/usr/local/

# scp -r /usr/local/src/jdk1.8.0_201 slaves2:/usr/local/

# scp -r /usr/local/hadoop slaves:/usr/local/

# scp -r /usr/local/hadoop slaves2:/usr/local/

6.启动hadoop:

# cd /usr/local/hadoop

# sbin/start-dfs.sh

# sbin/start-yarn.sh

# sbin/start-all.sh