写一个程序来模拟操作系统的进程调度。假设该系统只有一个CPU,每一个进程的到达时间,执行时间和运行优先级都是已知的。其中运行优先级用自然数表示,数字越大,则优先级越高。如果一个进程到达的时候CPU是空闲的,则它会一直占用CPU直到该进程结束。除非在这个过程中,有一个比它优先级高的进程要运行。在这种情况下,这个新的(优先级更高的)进程会占用CPU,而老的只有等待。如果一个进程到达时,CPU正在处理一个比它优先级高或优先级相同的进程,则这个(新到达的)进程必须等待。一旦CPU空闲,如果此时有进程在等待,则选择优先级最高的先运行。如果有多个优先级最高的进程,则选择到达时间最早的。

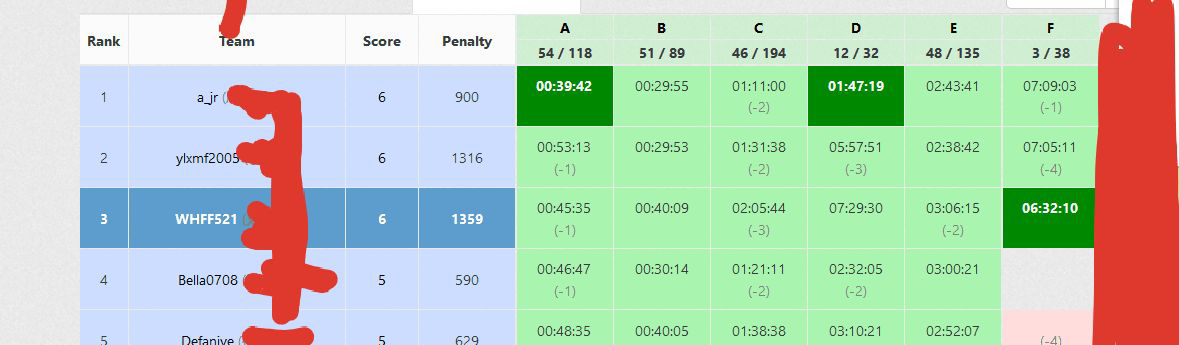

Sample Output1 6 3 19 5 30 6 32 8 34 4 35 7 40 2 42

Input

输入文件包含若干行,每一行有四个自然数(均不超过108),分别是进程号,到达时间,执行时间和优先级。不同进程有不同的编号,不会有两个相同优先级的进程同时到达。输入数据已经按到达时间从小到大排序。输入数据保证在任何时候,等待队列中的进程不超过15000个。

Output按照进程结束的时间输出每个进程的进程号和结束时间

Sample Input1 1 5 3 2 10 5 1 3 12 7 2 4 20 2 3 5 21 9 4 6 22 2 4 7 23 5 2 8 24 2 4#include<cstdio> #include<cstring> #include<queue> #include<algorithm> using namespace std; typedef long long ll; struct node { int num,rank; ll sta,last; bool operator<(const node &x) const { if(rank==x.rank) return sta>x.sta;//等级相同的看时间 return rank<x.rank;//剩下的看等级,因为给序列是有序的,进堆的顺序就是时间顺序 } }now; priority_queue<node> q;//大根堆 ll tim;//时间 int main() { while(scanf("%d%lld%lld%d",&now.num,&now.sta,&now.last,&now.rank)!=EOF) { node fin; while(!q.empty()&&tim+q.top().last<=now.sta)//堆顶是正在执行的任务,在下一个任务开始之前能结束的就结束 { fin=q.top();q.pop(); printf("%d %lld ",fin.num,tim+fin.last); tim+=fin.last; } if(!q.empty())//堆顶还有 { fin=q.top(); q.pop(); fin.last=fin.last-now.sta+tim;//不管什么程序直接把剩余时间算出来然后在重新入栈 q.push(fin); } q.push(now); tim=now.sta; } while(!q.empty())//剩下的 { node fin=q.top(); printf("%d %lld ",fin.num,tim+fin.last); tim+=fin.last; q.pop(); } return 0; }

给我很大的感触就是,当时第一眼看这个题的时候就知道是一个模拟,但是这些事件的时间和等级不知道什么时候判断,出堆入堆的条件过于繁琐;

但是我们可以看见我们写的是while(!q.empty())

(能写empty就别写size,省时间)

只要堆中有任务我们就会执行,所以只要有任务我们就把任务扔进去就行了,里面会自动判断要执行的任务是什么,我们先把正在执行的任务拿出来,算出还剩多少时间,然后和当前任务一起进去,只要正在执行的等级高,那么正在执行的任务就不会变,当前插入的也就乖乖的排到后面去了。

当然别忘了插入完堆中还有任务要执行完;