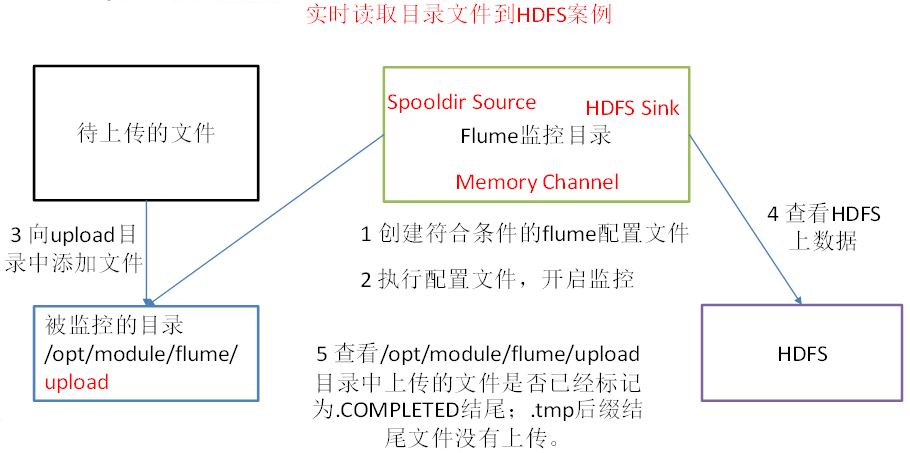

实时读取目录文件到HDFS案例

1)案例需求:使用flume监听整个目录的文件

2)需求分析:

创建一个文件

[jason@hadoop102 job]$ vim flume-dir-hdfs.conf

添加如下内容

a3.sources = r3 #定义source a3.sinks = k3 #定义sink a3.channels = c3 #定义channel # Describe/configure the source a3.sources.r3.type = spooldir #定义source类型:目录 a3.sources.r3.spoolDir = /opt/module/flume/upload #定义监控目录 a3.sources.r3.fileSuffix = .COMPLETED #定义文件上传成功,后缀 a3.sources.r3.fileHeader = true #是否有文件头 #忽略所有以.tmp结尾的文件,不上传 a3.sources.r3.ignorePattern = ([^ ]*.tmp) # Describe the sink a3.sinks.k3.type = hdfs #sink类型hdfs a3.sinks.k3.hdfs.path = hdfs://hadoop102:9000/flume/upload/%Y%m%d/%H #上传目标hdfs路径 #上传文件的前缀 a3.sinks.k3.hdfs.filePrefix = upload- #是否按照时间滚动文件夹 a3.sinks.k3.hdfs.round = true #多少时间单位创建一个新的文件夹 a3.sinks.k3.hdfs.roundValue = 1 #重新定义时间单位 a3.sinks.k3.hdfs.roundUnit = hour #是否使用本地时间戳 a3.sinks.k3.hdfs.useLocalTimeStamp = true #积攒多少个Event才flush到HDFS一次 a3.sinks.k3.hdfs.batchSize = 100 #设置文件类型,可支持压缩 a3.sinks.k3.hdfs.fileType = DataStream #多久生成一个新的文件(0表示不按照时间来分割文件),单位:秒 a3.sinks.k3.hdfs.rollInterval = 600 #设置每个文件的滚动大小大概是128M a3.sinks.k3.hdfs.rollSize = 134217700 #多少event生产新文件,0表示:文件的滚动与Event数量无关 a3.sinks.k3.hdfs.rollCount = 0 #多少个副本 a3.sinks.k3.hdfs.minBlockReplicas = 1 # Use a channel which buffers events in memory a3.channels.c3.type = memory a3.channels.c3.capacity = 1000 a3.channels.c3.transactionCapacity = 100 # Bind the source and sink to the channel a3.sources.r3.channels = c3 a3.sinks.k3.channel = c3

3)启动监控文件夹命令

[jason@hadoop102 flume]$ bin/flume-ng agent --conf conf/ --name a3 --conf-file job/flume-dir-hdfs.conf

说明: 在使用Spooling Directory Source时

① 不要在监控目录中创建并持续修改文件,在另一篇博客中有处理方案(shell重命名文件)

② 上传完成的文件会以.COMPLETED结尾

③ 被监控文件夹每600毫秒扫描一次文件变动

4)向upload文件夹中添加文件

在/opt/module/flume目录下创建upload文件夹

[jason@hadoop102 flume]$ mkdir upload

向upload文件夹中添加文件

[jason@hadoop102 upload]$ touch jason.txt [jason@hadoop102 upload]$ touch jason.tmp [jason@hadoop102 upload]$ touch jason.log

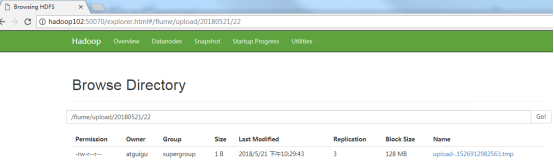

5)查看HDFS上的数据

6)等待1s,再次查询upload文件夹

[jason@hadoop102 upload]$ ll 总用量 0 -rw-rw-r--. 1 jason jason 0 5月 20 22:31 jason.log.COMPLETED -rw-rw-r--. 1 jason jason 0 5月 20 22:31 jason.tmp -rw-rw-r--. 1 jason jason 0 5月 20 22:31 jason.txt.COMPLETED