3.1跳过

3.2跳过

3.3语言与智能:信息熵

1)Claude Shannon: 更多研究从高校转移到企业

2) information Entropy:

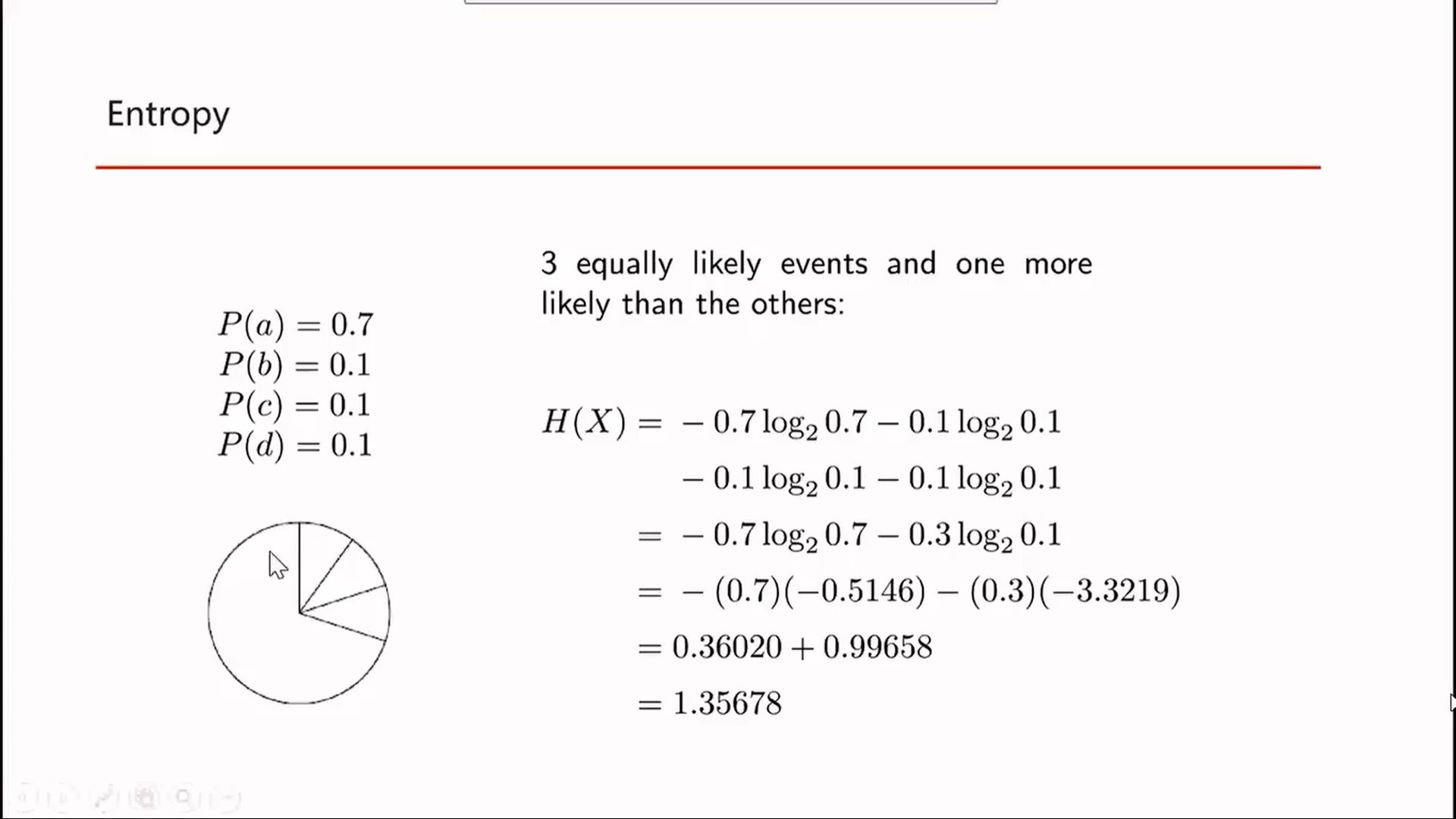

3)熵

a) 熵是一个 信息增量函数 H(x) >=0

b) 发生概率越低的事件,信息量越大; H(x)与P(x)成反比

c) H(x1,x2) = H(x1)+ H(x2) 当发生多事件时,需要将熵相加,而对于概率是相乘的,所以采用了log

d) 在二分类问题中,p(x1)=p(x2) = 0.5时,信息熵最大, 越相同,越没有规律,信息熵越大,越不同,信息熵越小

3.4交叉熵