以下为搭建一套分布式文件集群系统,参考了很多资料,自己经过在服务器上搭建并且经过了测试。记录以方便以后使用查看。

FastDfs + Dht 安装手册

一:概述

FastDFS是由淘宝的余庆先生所开发,是一个轻量级、高性能的开源分布式文件系统,由跟踪服务器(tracker server)、存储服务器(storage server)和客户端(client)三个部分组成,适合以中小文件(建议范围:4KB < file_size < 500MB)位载体的在线服务,用纯C语言开发,包括文件存储、文件同步、文件访问(上传、下载)、存取负载均衡、在线扩容、相同内容只存储一份等功能,适合有大容量存储需求的应用或系统。做分布式系统开发时,其中要解决的一个问题就是图片、音视频、文件共享的问题,分布式文件系统正好可以解决这个需求。同类的分布式文件系统有谷歌的GFS、HDFS(Hadoop)、TFS(淘宝)等。

FastDFS系统架构:

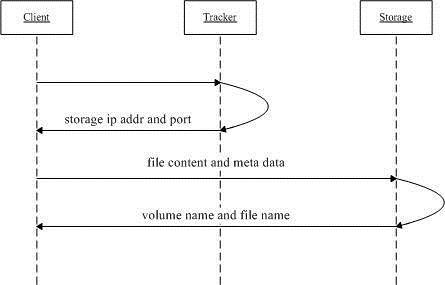

FastDFS文件上传流程:

1、client询问tracker上传到的storage,不需要附加参数;

2、tracker返回一台可用的storage;

3、client直接和storage通讯完成文件上传。

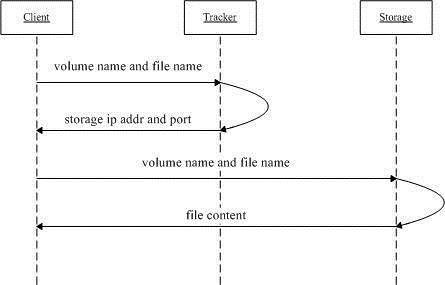

FastDFS文件下载流程:

1、client询问tracker下载文件的storage,参数为文件标识(组名和文件名);

2、tracker返回一台可用的storage;

3、client直接和storage通讯完成文件下载。

术语

FastDFS两个主要的角色:Tracker

Server 和 Storage Server

Tracker Server:跟踪服务器,主要负责调度storage节点与client通信,在访问上起负载均衡的作用,和记录storage节点的运行状态,是连接client和storage节点的枢纽。跟踪器和存储节点都可以由一台或多台服务器构成,跟踪器和存储节点中的服务器均可以随时增加或下线而不会影响线上服务,其中跟踪器中的所有服务器都是对等的,可以根据服务器的压力情况随时增加或减少。Tracker负责管理所有的Storage和group,每个storage在启动后会连接Tracker,告知自己所属的group等信息,并保持周期性的心跳,tracker根据storage的心跳信息,建立group==>[storage

server list]的映射表,Tracker需要管理的元信息很少,会全部存储在内存中;另外tracker上的元信息都是由storage汇报的信息生成的,本身不需要持久化任何数据,这样使得tracker非常容易扩展,直接增加tracker机器即可扩展为tracker

cluster来服务,cluster里每个tracker之间是完全对等的,所有的tracker都接受stroage的心跳信息,生成元数据信息来提供读写服务。

Storage Server:存储服务器,保存文件和文件的meta data(元数据)。采用了分卷[Volume](或分组[group])的组织方式,存储系统由一个或多个组组成,组与组之间的文件是相互独立的,所有组的文件容量累加就是整个存储系统中的文件容量。一个卷[Volume](组[group])可以由一台或多台存储服务器组成,一个组中的存储服务器中的文件都是相同的,组中的多台存储服务器起到了冗余备份和负载均衡的作用,数据互为备份,存储空间以group内容量最小的storage为准,所以建议group内的多个storage尽量配置相同,以免造成存储空间的浪费。

Group:文件组,也可以称为卷。同组内服务器上的文件是完全相同的,做集群时往往一个组会有多台服务器,上传一个文件到同组内的一台机器上后,FastDFS会将该文件即时同步到同组内的其它所有机器上,起到备份的作用。

meta data:文件相关属性,键值对(Key Value

Pair)方式,如:width=1024, height=768。和阿里云OSS的meta data相似。

二:安装环境如下:

Tracker服务器:实现跟踪服务冗余

10.10.2.207

10.10.2.208

Storage 服务器:实现数据冗余

10.10.2.207

10.10.2.208

Dht 服务安装到storage服务上,实现本地storage存储文件去重。

系统:centos 7.3 64bit

安装用户:root

安装目录:/opt

l 所有tracker和storage节点执行如下:

1.安装关联包:

yum install make cmake gcc gcc-c++

上传安装文件到/root/pkg/下(我这里已经下载好了)

2.安装libfatscommon

cd /root/pkg

#安装unzip 命令: yum install -y unzip zip

unzip libfastcommon-master.zip

cd libfastcommon-master

## 编译、安装

./make.sh

./make.sh install

由于libfastcommon安装完成,需要设置软链接:(这一步不用设置也可以)

ln -s /usr/lib64/libfastcommon.so /usr/local/lib/libfastcommon.so

ln -s /usr/lib64/libfdfsclient.so /usr/local/lib/libfdfsclient.so

ln -s /usr/lib64/libfdfsclient.so /usr/lib/libfdfsclient.so

3.安装FastDFS

cd /root/pkg

tar -xzvf fastdfs-master.zip

cd fastdfs-master

./make.sh

./make.sh install

采用默认安装方式,相应的文件与目录检查如下:

> 服务脚本:

/etc/init.d/fdfs_storaged

/etc/init.d/fdfs_trackerd

> 配置文件(示例配置文件):

ll /etc/fdfs/

-rw-r--r-- 1 root root 1461 1月 4 14:34 client.conf.sample

-rw-r--r-- 1 root root 7927 1月 4 14:34 storage.conf.sample

-rw-r--r-- 1 root root 7200 1月 4 14:34 tracker.conf.sample

> 命令行工具(/usr/bin目录下)

ll /usr/bin/fdfs_*

-rwxr-xr-x 1 root root 260584 1月 4 14:34 fdfs_appender_test

-rwxr-xr-x 1 root root 260281 1月 4 14:34 fdfs_appender_test1

-rwxr-xr-x 1 root root 250625 1月 4 14:34 fdfs_append_file

-rwxr-xr-x 1 root root 250045 1月 4 14:34 fdfs_crc32

-rwxr-xr-x 1 root root 250708 1月 4 14:34 fdfs_delete_file

-rwxr-xr-x 1 root root 251515 1月 4 14:34 fdfs_download_file

-rwxr-xr-x 1 root root 251273 1月 4 14:34 fdfs_file_info

-rwxr-xr-x 1 root root 266401 1月 4 14:34 fdfs_monitor

-rwxr-xr-x 1 root root 873233 1月 4 14:34 fdfs_storaged

-rwxr-xr-x 1 root root 266952 1月 4 14:34 fdfs_test

-rwxr-xr-x 1 root root 266153 1月 4 14:34 fdfs_test1

-rwxr-xr-x 1 root root 371336 1月 4 14:34 fdfs_trackerd

-rwxr-xr-x 1 root root 251651 1月 4 14:34 fdfs_upload_appender

-rwxr-xr-x 1 root root 252781 1月 4 14:34 fdfs_upload_file

l 配置所有tracker服务器

1、复制tracker样例配置文件,并重命名

cp /etc/fdfs/tracker.conf.sample /etc/fdfs/tracker.conf

2、修改tracker配置文件

vim /etc/fdfs/tracker.conf

# 修改的内容如下:

disabled=false # 启用配置文件

port=22122 # tracker服务器端口(默认22122)

base_path=/opt/fastdfs/tracker # 存储日志和数据的根目录

store_group=group1

3、创建base_path指定的目录

mkdir -p /opt/fastdfs/tracker

注意:本机防火墙要开始22122端口

4、启动tracker服务器

/etc/init.d/fdfs_trackerd start

初次启动,会在/fastdfs/tracker目录下生成logs、data两个目录。

drwxr-xr-x 2 root root 4096 1月 4 15:00 data

drwxr-xr-x 2 root root 4096 1月 4 14:38 logs

检查FastDFS Tracker Server是否启动成功:

ps -ef | grep fdfs_trackerd

三、配置所有storage服务

1、复制storage样例配置文件,并重命名

cp /etc/fdfs/storage.conf.sample /etc/fdfs/storage.conf

2、编辑配置文件

vi /etc/fdfs/storage.conf

# 修改的内容如下:

disabled=false # 启用配置文件

port=23000 # storage服务端口

base_path=/opt/fastdfs/storage # 数据和日志文件存储根目录

store_path_count=1 #存储路径个数,需要和store_path个数匹配

store_path0=/opt/fastdfs/storage # 实际文件存储路径

tracker_server=10.10.2.207:22122 # tracker服务器IP和端口

tracker_server=10.10.2.208:22122 #tracker服务器IP2和端口[Microsof1]

http.server_port=8888 # http访问文件的端口

3、创建基础数据目录

mkdir -p /fastdfs/storage

注意:如果有防火墙开始端口23000

4、启动storage服务器

/etc/init.d/fdfs_storaged start

初次启动,会在/fastdfs/storage目录下生成logs、data两个目录。

drwxr-xr-x 259 root root 4096 Mar 31 06:22 data

drwxr-xr-x 2 root root 4096 Mar 31 06:22 logs

检查FastDFS Tracker Server是否启动成功:

[root@gyl-test-t9 ~]# ps -ef | grep fdfs_storaged

root 1336 1 3 06:22 ? 00:00:01 /usr/bin/fdfs_storaged /etc/fdfs/storage.conf

root 1347 369 0 06:23 pts/0 00:00:00 grep fdfs_storaged

确定Storage服务器启动成功后,看看storage服务器是否已经登记到tracker服务器(可以理解为tracker与storage是否整合成功):

/usr/bin/fdfs_monitor /etc/fdfs/storage.conf

当看到ACTIVE时,即可说明Storage服务器已经成功登记到了tracker服务器上。

5.文件上传测试,分别修改2台tracker服务器的client.conf文件

cp /etc/fdfs/client.conf.sample /etc/fdfs/client.conf

vim /etc/fdfs/client.conf

# 修改以下配置,其它保持默认

base_path=/opt/fastdfs/tracker

tracker_server=10.10.2.207:22122 # tracker服务器IP和端口

tracker_server=10.10.2.208:22122 #tracker服务器IP2和端口

执行文件上传命令

#先给/opt目录下放一张图片test.png

通过执行客户端上传命令尝试上传:

/usr/bin/fdfs_upload_file /etc/fdfs/client.conf /opt/test.png

运行后返回一个路径:

表示文件已经上传成功,当文件存储到某个子目录后,即认为该文件存储成功,接下来会为该文件生成一个文件名,文件名由group、存储目录、两级子目录、fileid、文件后缀名(由客户端指定,主要用于区分文件类型)拼接而成,如下图:

4.在所有storage节点安装fastdfs-nginx-module

1、fastdfs-nginx-module 作用说明

FastDFS 通过 Tracker 服务器,将文件放在 Storage 服务器存储,但是同组存储服务器之间需要进入文件复制,有同步延迟的问题。假设 Tracker 服务器将文件上传到了 ip01,上传成功后文件 ID 已经返回给客户端。此时 FastDFS 存储集群机制会将这个文件同步到同组存储 ip02,在文件还没有复制完成的情况下,客户端如果用这个文件 ID 在 ip02 上取文件,就会出现文件无法访问的错误。而fastdfs-nginx-module 可以重定向文件连接到源服务器取文件,避免客户端由于复制延迟导致的文件无法访问错误。(解压后的 fastdfs-nginx-module 在 nginx 安装时使用)

2、解压 fastdfs-nginx-module-master.zip

cd /root/pkg

unzip fastdfs-nginx-module-master.zip

3、安装编译 Nginx 所需的依赖包

yum install gcc gcc-c++ make automake autoconf libtool pcre* zlib openssl openssl-devel

4、编译安装 Nginx (添加 fastdfs-nginx-module 模块)

cd /root/pkg/

tar -zxvf nginx-1.10.0.tar.gz

unzip ngx_cache_purge-master.zip

cd nginx-1.10.0

./configure --prefix=/opt/nginx --add-module=/root/pkg/fastdfs-nginx-module/src --add-module=/root/pkg/ngx_cache_purge-master

make && make install

5、复制 fastdfs-nginx-module 源码中的配置文件到/etc/fdfs 目录,并修改

cp /root/pkg/fastdfs-nginx-module/src/mod_fastdfs.conf /etc/fdfs/

vi /etc/fdfs/mod_fastdfs.conf

修改以下配置:

connect_timeout=10

base_path=/tmp

tracker_server=10.10.2.207:22122 # tracker服务器IP和端口

tracker_server=10.10.2.208:22122 #tracker服务器IP2和端口

url_have_group_name=true #url中包含group名称

#在最后添加 [group1]

group_name=group1

storage_server_port=23000

store_path_count=1

store_path0=/opt/fastdfs/storage

6、复制 FastDFS 的部分配置文件到/etc/fdfs 目录

cd /root/pkg/fastdfs-master/conf

cp http.conf mime.types /etc/fdfs/

7、在/opt/fastdfs/storage 文件存储目录下创建软连接,将其链接到实际存放数据的目录

ln -s /opt/fastdfs/storage/data/ /opt/fastdfs/storage/data/M00

8、配置 Nginx

user nobody;

worker_processes 2;

events {

worker_connections 1024;

}

http {

include mime.types;

default_type application/octet-stream;

sendfile on;

keepalive_timeout 65;

server {

listen 8888;

server_name localhost;

location ~/group([0-9])/M00{

ngx_fastdfs_module;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

upstream storage_server_group1{

server 10.10.2.207:8888 weight=10;

server 10.10.2.208:8888 weight=10;

}

}

说明:

A、8888 端口值是要与/etc/fdfs/storage.conf 中的 http.server_port=8888 相对应, 因为 http.server_port 默认为 8888,如果想改成 80,则要对应修改过来。

B、Storage 对应有多个 group 的情况下,访问路径带 group 名,如/group1/M00/00/00/xxx, 对应的 Nginx 配置为:

location ~/group([0-9])/M00 {

ngx_fastdfs_module;

}

C、如查下载时如发现老报 404,将 nginx.conf 第一行 user nobody 修改为 user root 后重新启动。

9:如果通过tracker服务器的http协议进行文件的上传,需要在此类服务器按照storage的方法安装nginx,配置如下:(根据开发情况参考安装,如果使用web访问tracker,则需要此功能)

修改nginx的配置文件,进入/usr/local/nginx/conf/nginx.conf,tracker的nginx无需修改listen端口,即磨人的80端口,并将upstream指向storage的nginx地址:

upstream fdfs_group1 {

这里举例指向storage的http端口 server 10.10.2.119:9999;

}

location /group1/M00 {

proxy_pass http://fdfs_group1;

}

启动 Nginx

/usr/local/nginx/sbin/nginx

重启:/usr/local/nginx/sbin/nginx -s reload)

六.FastDHT安装配置

FastDHT配合FastDFS进行文件上传去重

DFS软件本身不能对重复上传的文件进行去重, 作者余庆开源了一个解决的资源,就是FastDHT了,使用这个也可以做到去重。

FastDHT是一个高性能的分布式哈希系统,它是基于键值对存储的,而且它需要依赖于Berkeley DB作为数据存储的媒介,同时需要依赖于libfastcommon。

FastDHT集群由一个或者多个组 group组成,同组服务器上存储的数据是相同的,数据同步只在组的服务器之间进行;组内各个服务是对等的,对数据进行存取时,可以根据 key的hash值来决定使用哪台机器。

l 安装到所有的storage服务器上

1.先安装libfastcommon

由于上面安装dfs的时候已经安装此软件,所以跳过

2.安装Berkeley DB

Cd /root/pkg

tar zxvf db-6.2.32.tar.gz

cd db-6.2.32/build_unix

../dist/configure --prefix=/usr/local/db-6.2.32

Make

Make install

3.安装FastDHT

unzip fastdht-master.zip

cd fastdht-master

vi make.sh

增加红色字体

CFLAGS='-Wall -D_FILE_OFFSET_BITS=64 -D_GNU_SOURCE -I /opt/db-6.2.32/include/ -L /opt/db-6.2.32/lib/'

Make.sh && make.sh install

在/etc/fdht下生成文件

4.配置FastDHT

配置fdht_client.conf文件

base_path=/data/fastdht

keep_alive=1

#include /etc/fdhtd/fdht_servers.conf

配置fdht_servers.conf文件

vim

/etc/fdhtd/fdht_servers.conf

group_count =

1

group0 = 10.10.2.207:11411

group0 =

10.10.2.208:11411

配置fdhtd.conf文件

vim /etc/fdht/fdhtd.conf/ port=11411

bash_path=/data/fastdht (该目录必须是已经存在的)

cache_size = 32MB

#include /etc/fdhtd/fdht_servers.conf -> (本行前有#表示打开,如果想关闭此选项,则应该为##开头)

配置storaged.conf文件

vim /etc/fdfs/storaged.conf

#是否检测上传文件已经存在。如果已经存在,则建立一个索引链接以节省磁盘空间

check_file_duplicate=1

#当上个参数设定为1时 , 在FastDHT中的命名空间

key_namespace=FastDFS

#长连接配置选项,如果为0则为短连接 1为长连接

keep_alive=1

#此处特别需要注意配置

#include /etc/fdht/fdht_servers.conf

建立目录:make –p /data/fastdht

5.启动可能遇到问题:

fdhtd /etc/fdht/fdhtd.conf

error while loading shared libraries: libdb-6.1.so: cannot open shared object

file: No such file or directory

解决办法:

# ln -s /opt/db-6.2.32/lib/libdb-6.2.so /usr/lib64/libdb-6.2.so

6.启动fdht和storage

fdhtd /etc/fdht/fdhtd.conf 或 fdhtd /etc/fdht/fdhtd.conf restart

/etc/init.d/fdfs_storaged restart

测试:

重复上传一个文件看目录是否有软连接文件存在

Dfs 命令使用帮助:

l Tracker启动,停止,重启:/etc/init.d/fdfs_trackerd

l Storage启动,停止,重启:/etc/init.d/fdfs_storaged

注意:千万不要使用-9参数强杀,否则可能会导致binlog数据丢失的问题。

l 查看集群情况:

在任意一台storage(tracker也可以) /usr/local/bin/fdfs_monitor /etc/fdfs/storage.conf

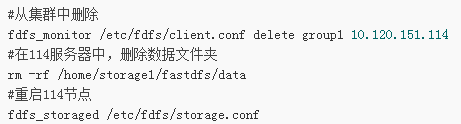

l 删除一个storage

1:首先停止要删除的storage服务

2:在任意一台storage(tracker也可以)执行:

/usr/local/bin/fdfs_monitor /etc/fdfs/storage.conf delete group1 10.10.2.213

测试后,通过查看集群情况可以发现:

l fdfs_test和fdfs_test1是做什么用的 (仅仅用于测试)

这两个是FastDFS自带的测试程序,会对一个文件上传两次,分别作为主文件和从文件。返回的文件ID也是两个。

并且会上传文件附加属性,storage

server上会生成4个文件。

/usr/local/bin/fdfs_test upload

l 下载文件

/usr/bin/fdfs_download_file [local_filename]

l 删除文件

/usr/bin/fdfs_delete_file

l 节点监控

fdfs_monitor /etc/fdfs/client.conf

l STORAGE SERVER的状态通常有七种:

当发现有以下状态的服务器

Storage 4:

ip_addr = 10.120.151.114 WAIT_SYNC

l 测试上传

fdfs_test /etc/fdfs/client.conf upload /usr/include/stdlib.h

l 上传文件

fdfs_upload_file /etc/fdfs/client.conf filename

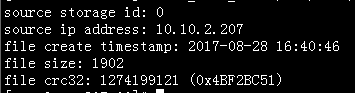

l 查询文件是否存在

fdfs_file_info /etc/fdfs/client.conf group1/M00/00/00/CgoCz1mj1w6ASc6KAAAHbkvyvFE868.cfg

输出:

######基本概念介绍##########

- 什么是主从文件

主从文件是指文件ID有关联的文件,一个主文件可以对应多个从文件。

主文件ID = 主文件名 + 主文件扩展名

从文件ID = 主文件名 + 从文件后缀名 + 从文件扩展名

使用主从文件的一个典型例子:以图片为例,主文件为原始图片,从文件为该图片的一张或多张缩略图。

FastDFS中的主从文件只是在文件ID上有联系。FastDFS server端没有记录主从文件对应关系,因此删除主文件,FastDFS不会自动删除从文件。

删除主文件后,从文件的级联删除,需要由应用端来实现。

主文件及其从文件均存放到同一个group中。

主从文件的生成顺序:

1)先上传主文件(如原文件),得到主文件ID

2)然后上传从文件(如缩略图),指定主文件ID和从文件后缀名(当然还可以同时指定从文件扩展名),得到从文件ID

#################################

安装包见文件,其中db文件和nginx 请自行上网下载即可