-

所有的问题针对的都是服务器的高可用

-

这里不会分析解决方案的底层,只会说明问题的产生和基本的解决方案

Redis缓存的使用,极大的提升了应用程序的性能和效率,特别是数据查询方面。

但同时,它带来了一些问题。

其中,最要害的问题,就是数据的一致性问题(比如:数据库的秒杀商品已经没了,缓存中还有,因为会设置缓存的过期时间,所以缓存中的数据没有过期不会更新),从某种意义上讲,这个问题是无解的。

如果对数据的一致性要求很高,那么就不能使用缓存。

缓存穿透

概念

通俗来说:缓存没有,直接去查数据库,这是没有问题的,但是高并发的情况下,会压垮数据库,导致宕机。

解决方案

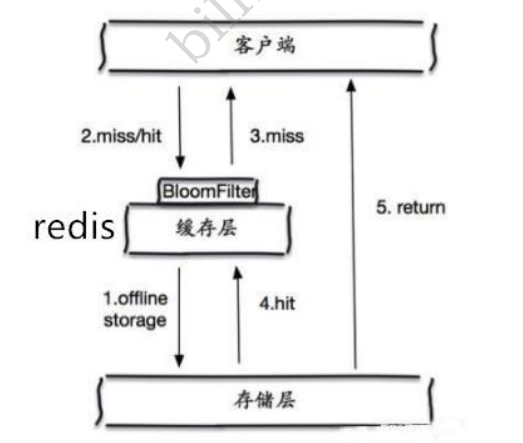

1、第一种:布隆过滤器

布隆过滤器是一种数据结构,对所有可能查询的参数以hash形式存储,在控制层先进行校验,不符合则丢弃,从而避免了对底层存储系统的查询压力;

2、第二种:缓存空对象

但是这种方法会存在两个问题:

1、如果空值能够被缓存起来,这就意味着缓存需要更多的空间存储更多的键,因为这当中可能会有很多的空值的键。

缓存击穿

概述

这里需要注意和缓存穿透的区别。

缓存的击穿,是指一个key非常的热点,在不停的扛着大并发,大并发集中对一个点进行访问,当这个key失效的瞬间,持续的大并发就穿破缓存,直接请求数据库,就像在一堵墙上凿开了一个洞。

当某个key在过期的瞬间,有大量的请求并发访问,之类数据一般都是热点数据,由于缓存过期,会同时访问数据库来查询最新的数据,并且回写缓存,会导致数据库瞬间压力过大。

通俗来说:缓存中的数据还有10s过期,现在有上百万的并发请求正在读取,当缓存失效的一瞬间,大量的并发请求直接对存储层进行访问,一瞬间服务器扛不住,就会宕机。

解决方案

1、第一种:设置热点数据永不过期

从缓存层面来看,不设置过期的时间,所以就不会出现热点key过期后产生的问题。

但是永不过期会影响到内存的空间占用,并且Redis还有一种机制,在内存满了的时候,会有几种策略随机:

1、volatile-lru:只对设置了过期时间的key进行LRU(默认值) 2、allkeys-lru : 删除lru算法的key 3、volatile-random:随机删除即将过期key 4、allkeys-random:随机删除 5、volatile-ttl : 删除即将过期的 6、noeviction : 永不过期,返回错误

这个在redis.conf配置文件中讲到了。

2、加互斥锁

分布式锁:使用分布式锁,保证对于每个key同时只有一个线程去查询后端服务,其他线程没有获取分布式锁的权限,因此只需要等待即可。这种方式将高并发的压力转移到了分布式锁,因此分布式锁的考验很大。

缓存雪崩

概念

缓存雪崩,是指在某一时间段,缓存集中过期实失效,或者服务宕机(断电,扫地大妈又把服务器插头拔了)!

产生雪崩的原因之一:比如在写文本的时候,马上就要到双十一零点,很快就会迎来一波抢购,这波商品时间比较集中的放入缓存,假如这波商品的缓存为一个小时,那么到了凌晨一点钟的时候,这波商品的缓存都过期了。而对这波商品的查询,都落到了数据库上,对于数据库而言,就会产生周期性的压力波峰。对于所有的请求都会达到存储层,存储层的调用量会暴增,造成存储层也会挂掉的情况。

解决方案

1、redis高可用

让这个思想的含义是,既然redis有可能挂掉,那我多增加几台redis,这样一台挂掉之后其他的还可以继续工作,其实就是搭建集群。(异地多活!在SpringCloud的eureka讲解中又说到)

2、限流降级(加锁和队列,在JUC中讲解过)

这个解决方案的思想是,在缓存失效之后,通过加锁或者队列来控制读数据库和写缓存的线程数量。比如对某个key只允许一个线程查询数据库和写缓存,其他线程等待。

3、数据预热

数据加热的含义就是在正式部署之前,我先把可能的数据先访问一遍,这样部分可能大量访问的数据就会加载到缓存中。在即将发生的大并发访问前,手动触发加载缓存不同的key,设置不同的过期时间,让缓存失效的时间点尽量均匀,不要一瞬间都失效了,那么又会造成缓存雪崩了。