今天看到波特率,抽根查了一下信息论的资料,也等于是复习了一下。

信息论的鼻祖的香农,当时抽象出信息量这个概念确实不简单,对今天得信息社会影响太巨大了。其实我们早已身处信息的包围之中,能够给我们感知的实体都包含信息,人们开始抽象出阿拉伯数字,英文字母,希腊字母,以及伟大的0,1,等等。都是为了传递信息。香农将这个日常生活中很抽象的信息,理论化,有了信息量这个概念。

下面是维基上面的定义,如果有一个系统S内存在多个事件S = {E1,...,En},每个事件的机率分布 P = {p1, ..., pn},则每个事件本身的讯息(信息本体)为

Ie = − log2pi(对数以2为底,单位是比特(bit))

Ie = − lnpi(对数以e为底,单位是纳特/nats)

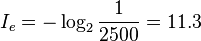

而汉字常用的有2500个,假如每个汉字在文章中出现次数平均的话,每个汉字的信息量为:

- 信息熵的概念是一个期望值,即:

- 如何将信息量转化为信号,将信号发射会涉及到调制,在信道传输,在终端接收,解调为发射端的信号,对于信息量,其中还有什么编码理论。。。。对于计算机来说,是一对0,1 的码,然后就是计算机上层的应用了,如果在物理通信的角度看计算机软件,感觉像是在看摩天大楼一样。

- 不禁感叹,前面的巨人实在太高了。。。。。平时程序可能不会关注通信这一块细节,想来还真不少。

- 有时间应该学习记录下详细的过程,会涉及到数学,物理,电子电路,信号与系统,数字信号,计算机。。。是一项很大的工程额。