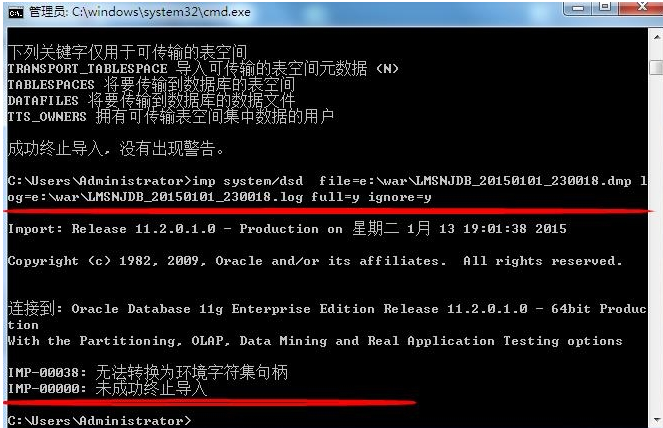

在imp 还原数据库的时候出现问题如下; 这个问题是 你用 expdp导出的 却用客户端的 imp 导入;换成impdp导入即可。

当用impdp 导入 (impdp EMMS/EMMS123 directory=expdir dumpfile=EMMS2.dmp) 却发现 【IMPDP】使用工具IMPDP导入数据时ORA-39002、ORA-39070错误排查 其中 RA-39070 错误指出 没有expdir 对象。

expdir 需要你重新再创建一次如下:

sqlplus /nolog conn /as sysdba

SQL> create or replace directory expdir as 'E:/Kxdb';

目录已创建。

这个过程中要注意的是 Oracle expdp/impdp导出导入命令及数据库备份 2者之间的区别 如下所示:

使用EXPDP和IMPDP时应该注意的事项:

EXP和IMP是客户端工具程序,它们既可以在客户端使用,也可以在服务端使用。

EXPDP和IMPDP是服务端的工具程序,他们只能在ORACLE服务端使用,不能在客户端使用。

IMP只适用于EXP导出的文件,不适用于EXPDP导出文件;IMPDP只适用于EXPDP导出的文件,而不适用于EXP导出文件。

expdp或impdp命令时,可暂不指出用户名/密码@实例名 as 身份,然后根据提示再输入,如:

expdp schemas=scott dumpfile=expdp.dmp DIRECTORY=dpdata1;

一、创建逻辑目录,该命令不会在操作系统创建真正的目录,最好以system等管理员创建。

create directory dpdata1 as 'd: estdump';

二、查看管理理员目录(同时查看操作系统是否存在,因为Oracle并不关心该目录是否存在,如果不存在,则出错)

select * from dba_directories;

三、给scott用户赋予在指定目录的操作权限,最好以system等管理员赋予。

grant read,write on directory dpdata1 to scott;

四、导出数据

1)按用户导

expdp scott/tiger@orcl schemas=scott dumpfile=expdp.dmp DIRECTORY=dpdata1;

2)并行进程parallel

expdp scott/tiger@orcl directory=dpdata1 dumpfile=scott3.dmp parallel=40 job_name=scott3

3)按表名导

expdp scott/tiger@orcl TABLES=emp,dept dumpfile=expdp.dmp DIRECTORY=dpdata1;

4)按查询条件导

expdp scott/tiger@orcl directory=dpdata1 dumpfile=expdp.dmp Tables=emp query='WHERE deptno=20';

5)按表空间导

expdp system/manager DIRECTORY=dpdata1 DUMPFILE=tablespace.dmp TABLESPACES=temp,example;

6)导整个数据库

expdp system/manager DIRECTORY=dpdata1 DUMPFILE=full.dmp FULL=y;

五、还原数据

1)导到指定用户下

impdp scott/tiger DIRECTORY=dpdata1 DUMPFILE=expdp.dmp SCHEMAS=scott;

2)改变表的owner

impdp system/manager DIRECTORY=dpdata1 DUMPFILE=expdp.dmp TABLES=scott.dept REMAP_SCHEMA=scott:system;

3)导入表空间

impdp system/manager DIRECTORY=dpdata1 DUMPFILE=tablespace.dmp TABLESPACES=example;

4)导入数据库

impdb system/manager DIRECTORY=dump_dir DUMPFILE=full.dmp FULL=y;

5)追加数据

impdp system/manager DIRECTORY=dpdata1 DUMPFILE=expdp.dmp SCHEMAS=system TABLE_EXISTS_ACTION

相对于的参数如下所示:

ATTACH 连接到现有作业, 例如 ATTACH [=作业名]。

CONTENT 指定要加载的数据, 其中有效关键字为:

(ALL), DATA_ONLY 和 METADATA_ONLY。

DATA_OPTIONS 数据层标记, 其中唯一有效的值为:

SKIP_CONSTRAINT_ERRORS - 约束条件错误不严重。

DIRECTORY 供转储文件, 日志文件和 sql 文件使用的目录对象。

DUMPFILE 要从 (expdat.dmp) 中导入的转储文件的列表,

例如 DUMPFILE=scott1.dmp, scott2.dmp, dmpdir:scott3.dmp。

ENCRYPTION_PASSWORD 用于访问加密列数据的口令关键字。

此参数对网络导入作业无效。

ESTIMATE 计算作业估计值, 其中有效关键字为:

(BLOCKS) 和 STATISTICS。

EXCLUDE 排除特定的对象类型, 例如 EXCLUDE=TABLE:EMP。

FLASHBACK_SCN 用于将会话快照设置回以前状态的 SCN。

FLASHBACK_TIME 用于获取最接近指定时间的 SCN 的时间。

FULL 从源导入全部对象 (Y)。

HELP 显示帮助消息 (N)。

INCLUDE 包括特定的对象类型, 例如 INCLUDE=TABLE_DATA。

JOB_NAME 要创建的导入作业的名称。

LOGFILE 日志文件名 (import.log)。

NETWORK_LINK 链接到源系统的远程数据库的名称。

NOLOGFILE 不写入日志文件。

PARALLEL 更改当前作业的活动 worker 的数目。

PARFILE 指定参数文件。

PARTITION_OPTIONS 指定应如何转换分区, 其中

有效关键字为: DEPARTITION, MERGE 和 (NONE)

QUERY 用于导入表的子集的谓词子句。

REMAP_DATA 指定数据转换函数,

例如 REMAP_DATA=EMP.EMPNO:REMAPPKG.EMPNO

REMAP_DATAFILE 在所有 DDL 语句中重新定义数据文件引用。

REMAP_SCHEMA 将一个方案中的对象加载到另一个方案。

REMAP_TABLE 表名重新映射到另一个表,

例如 REMAP_TABLE=EMP.EMPNO:REMAPPKG.EMPNO。

REMAP_TABLESPACE 将表空间对象重新映射到另一个表空间。

REUSE_DATAFILES 如果表空间已存在, 则将其初始化 (N)。

SCHEMAS 要导入的方案的列表。

SKIP_UNUSABLE_INDEXES 跳过设置为无用索引状态的索引。

SQLFILE 将所有的 SQL DDL 写入指定的文件。

STATUS 在默认值 (0) 将显示可用时的新状态的情况下,

要监视的频率 (以秒计) 作业状态。

STREAMS_CONFIGURATION 启用流元数据的加载

TABLE_EXISTS_ACTION 导入对象已存在时执行的操作。

有效关键字: (SKIP), APPEND, REPLACE 和 TRUNCATE。

TABLES 标识要导入的表的列表。

TABLESPACES 标识要导入的表空间的列表。

TRANSFORM 要应用于适用对象的元数据转换。

有效转换关键字为: SEGMENT_ATTRIBUTES, STORAGE,

OID 和 PCTSPACE。

TRANSPORTABLE 用于选择可传输数据移动的选项。

有效关键字为: ALWAYS 和 (NEVER)。

仅在 NETWORK_LINK 模式导入操作中有效。

TRANSPORT_DATAFILES 按可传输模式导入的数据文件的列表。

TRANSPORT_FULL_CHECK 验证所有表的存储段 (N)。

TRANSPORT_TABLESPACES 要从中加载元数据的表空间的列表。

仅在 NETWORK_LINK 模式导入操作中有效。

VERSION 要导出的对象的版本, 其中有效关键字为:

(COMPATIBLE), LATEST 或任何有效的数据库版本。

仅对 NETWORK_LINK 和 SQLFILE 有效。

下列命令在交互模式下有效。 注: 允许使用缩写

命令 说明 (默认)

CONTINUE_CLIENT 返回到记录模式。如果处于空闲状态, 将重新启动作业。

EXIT_CLIENT 退出客户机会话并使作业处于运行状态。

HELP 总结交互命令。

KILL_JOB 分离和删除作业。

PARALLEL 更改当前作业的活动 worker 的数目。

PARALLEL=。

START_JOB 启动/恢复当前作业。

START_JOB=SKIP_CURRENT 在开始作业之前将跳过

作业停止时执行的任意操作。

STATUS 在默认值 (0) 将显示可用时的新状态的情况下,

要监视的频率 (以秒计) 作业状态。

STATUS[=interval]

STOP_JOB 顺序关闭执行的作业并退出客户机。

STOP_JOB=IMMEDIATE 将立即关闭

数据泵作业。