(shared_ptr)的引用计数本身是安全且无锁的,但对象的读写则不是,“因为 shared_ptr 有两个数据成员,读写操作不能原子化"。使得多线程读写同一个 shared_ptr 对象需要加锁

• 一个 shared_ptr 对象实体可被多个线程同时读取;

• 两个 shared_ptr 对象实体可以被两个线程同时写入,“析构”算写操作;

• 如果要从多个线程读写同一个 shared_ptr 对象,那么需要加锁。

================================================================================

请注意,以上是 shared_ptr 对象本身的线程安全级别,不是它管理的对象的线程安全级别。

总结:书本上的一句话就是 不要对标准库抱有线程安全的幻想!!!!!!!!!需要各种分析到底安全与否!!!

shared_ptr 的数据结构:!!!!!

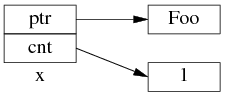

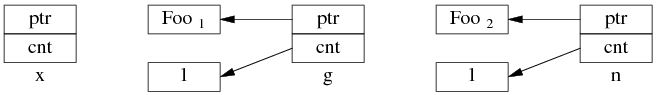

shared_ptr 是引用计数型(reference counting)智能指针,几乎所有的实现都采用在堆(heap)上放个计数值(count)的办法(除此之外理论上还有用循环链表的办法,不过没有实例)。具体来说,shared_ptr<Foo> 包含两个成员,一个是指向 Foo 的指针 ptr,另一个是 ref_count 指针(其类型不一定是原始指针,有可能是 class 类型,但不影响这里的讨论),指向堆上的 ref_count 对象。ref_count 对象有多个成员,具体的数据结构如图 1 所示,其中 deleter 和 allocator 是可选的。

为了简化并突出重点,后文只画出 use_count:

以上是 shared_ptr<Foo> x(new Foo); 对应的内存数据结构。

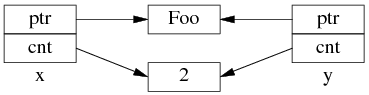

如果再执行 shared_ptr<Foo> y = x; 那么对应的数据结构如下。

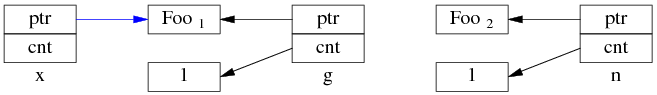

但是 y=x 涉及两个成员的复制,这两步拷贝不会同时(原子)发生。

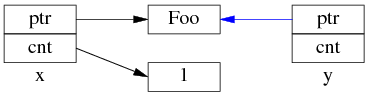

中间步骤 1,复制 ptr 指针:

中间步骤 2,复制 ref_count 指针,导致引用计数加 1:

步骤1和步骤2的先后顺序跟实现相关(因此步骤 2 里没有画出 y.ptr 的指向),我见过的都是先1后2。

既然 y=x 有两个步骤,如果没有 mutex 保护,那么在多线程里就有 race condition即资源竞争。

多线程无保护读写 shared_ptr 可能出现的 race condition:!!!!!!!!!!

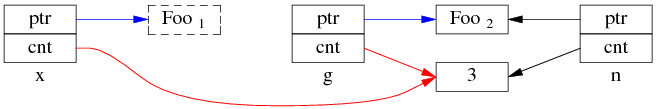

考虑一个简单的场景,有 3 个 shared_ptr<Foo> 对象 x、g、n:

- shared_ptr<Foo> g(new Foo); // 线程之间共享的 shared_ptr

- shared_ptr<Foo> x; // 线程 A 的局部变量

- shared_ptr<Foo> n(new Foo); // 线程 B 的局部变量

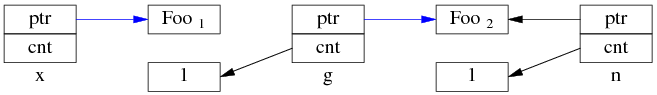

一开始,各安其事。

线程 A 执行 x = g; (即 read g),以下完成了步骤 1,还没来及执行步骤 2。这时切换到了 B 线程。

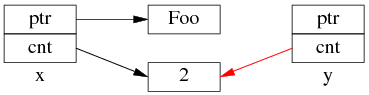

同时编程 B 执行 g = n; (即 write G),两个步骤一起完成了。

先是步骤 1:

再是步骤 2:

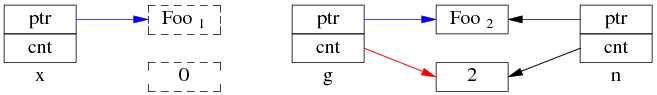

这是 Foo1 对象已经销毁,x.ptr 成了空悬指针!

最后回到线程 A,完成步骤 2:

多线程无保护地读写 g,造成了“x 是空悬指针”的后果。这正是多线程读写同一个 shared_ptr 必须加锁的原因。

当然,race condition 远不止这一种,其他线程交织(interweaving)有可能会造成其他错误。

思考,假如 shared_ptr 的 operator= 实现是先复制 ref_count(步骤 2)再复制 ptr(步骤 1),会有哪些 race condition?