1、安装环境

①、一台Linux CentOS6.7 系统

hostname ipaddress subnet mask geteway

Node1 192.168.139.150 255.255.255.0 192.168.139.2

②、hadoop 2.7 安装包

百度云下载链接:http://pan.baidu.com/s/1gfaKpA7 密码:3cl7

2、安装 JDK

教程:http://www.cnblogs.com/ysocean/p/6952166.html

3、配置本机 ssh 免密码登录

教程:http://www.cnblogs.com/ysocean/p/6959776.html

上面教程是配置多台机器 ssh 免秘钥登录的配置。那么本机配置的话。输入如下命令即可:

ssh-keygen -t rsa -P '' cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys chmod 600 ~/.ssh/authorized_keys

完成之后,以 root 用户登录,修改 ssh 配置文件

vi /etc/ssh/sshd_config

把文件中的下面几条信息的注释去掉:

RSAAuthentication yes # 启用 RSA 认证

PubkeyAuthentication yes # 启用公钥私钥配对认证方式

AuthorizedKeysFile .ssh/authorized_keys # 公钥文件路径(和上面生成的文件同)

然后重启服务

service sshd restart

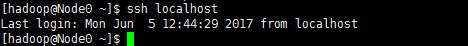

验证出现如下界面,中间不需要输入密码,即配置完成。

4、安装 hadoop-2.7.3.tar.gz

①、将下载的 hadoop-2.7.3.tar.gz 复制到 /home/hadoop 目录下(可以利用工具 WinSCP)

②、解压,进入/home/hadoop 目录下,输入下面命令

tar -zxvf hadoop-2.7.3.tar.gz

③、给 hadoop-2.7.3文件夹重命名,以便后面引用

mv hadoop-2.7.3 hadoop2.7

④、删掉压缩文件 hadoop-2.7.3.tar.gz,并在/home/hadoop 目录下新建文件夹 tmp

mv hadoop-2.7.3 hadoop2.7

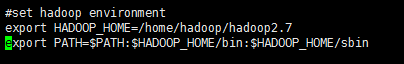

⑤、配置 hadoop 的环境变量(注意要使用 root 用户登录)

vi /etc/profile

输入如下信息:

然后输入如下命令保存生效:

source /etc/profile

⑥、验证

在任意目录下,输入 hadoop,出现如下信息即配置成功

5、修改配置文件

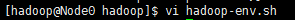

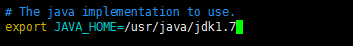

①、/home/hadoop/hadoop-2.7.0/etc/hadoop目录下hadoop-env.sh

输入命令

修改 hadoop-env.sh 的 JAVA_HOME 值

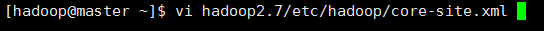

②、/home/hadoop/hadoop2.7/etc/hadoop目录下的core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.139.150:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/tmp</value>

</property>

</configuration>

③、/home/hadoop/hadoop-2.7.0/etc/hadoop目录下的hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

到此我们便配置完成一个 hdfs 伪分布式环境

启动 hdfs Single Node

①、初始化 hdfs 文件系统

bin/hdfs namenode -format

②、启动 hdfs

sbin/start-dfs.sh

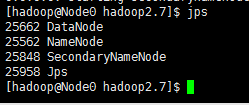

③、输入 jps 应该会有如下信息显示,则启动成功

那么我们就可以 通过 http://192.168.139.150:50070 来访问 NameNode

我们点开 Datanodes ,发现就一个 datanode ,而且 IP 是 NameNode 的

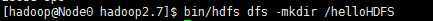

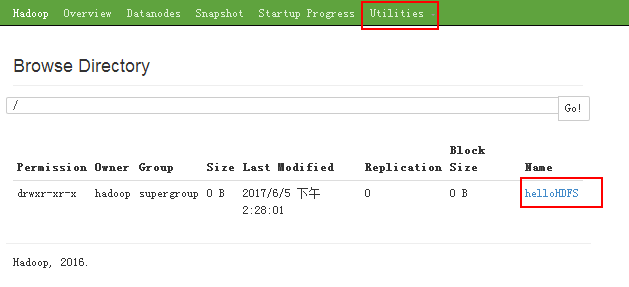

我们使用命令创建一个文件

那么在网页上我们就能看到这个文件

④、关闭 hdfs

sbin/stop-dfs.sh