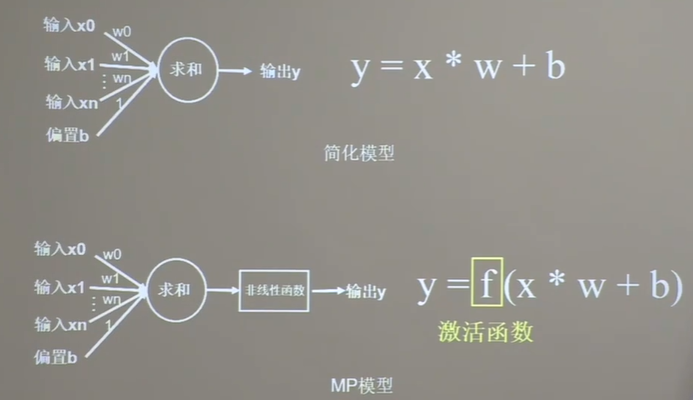

其中MP模型中的非线性函数极为激活函数(激活函数是用来加入非线性因素的,提高神经网络对模型的表达能力,解决线性模型所不能解决的问题。)

优秀的激活函数:

1.非线性:激活函数非线性时,多层神经网络可逼近所有函数

2.可微性: 优化器大多用梯度下降更新参数

3..单调性:当激活函数是单调的,能保证单层网络的损失函数是凸函数

4..近似恒等性: f(x}≈x 当参数初始化为随机小值时,神经网络更稳定

激活函数的输出值范围:

1.激活函数输出为有限值时,基于梯度的优化方法更稳定

2.激活函数输出为无限值时,建议调小学习率

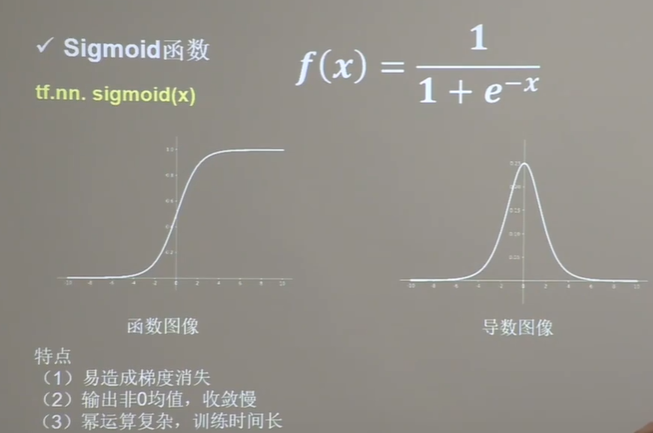

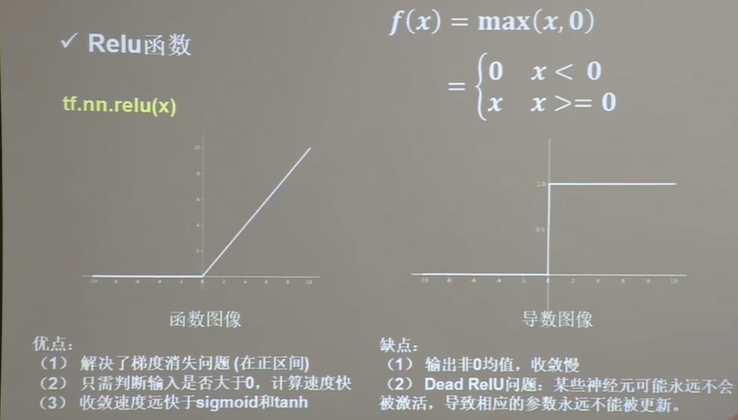

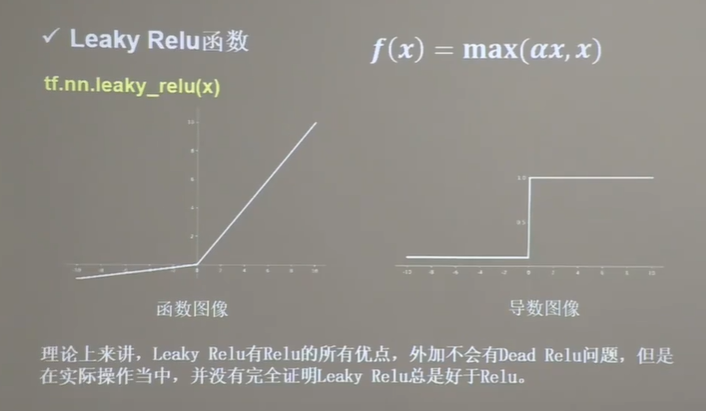

常用激活函数:

对于初学者建议:

1、首选relu激活函 数;

2、学习率设置较小值;

3、输入特征标准化,即让输入特征满足以0为均值,1为标准差的正态分布;

4、初始参数中心化,即让随机生成的参数满足以0为均值,![]() 为标准差的正态分布。

为标准差的正态分布。