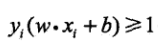

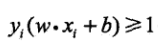

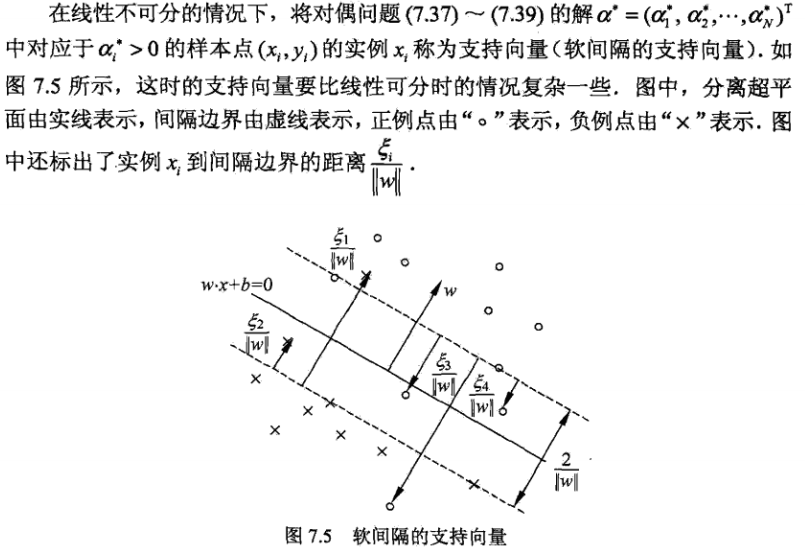

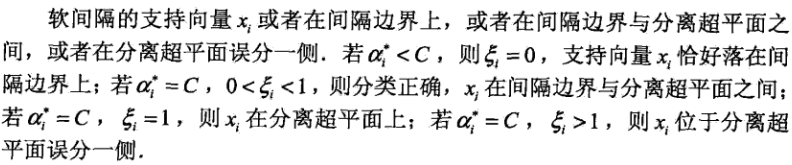

上一节所讲的支持向量机是在数据线性可分的情况下的,当数据线性不可分时,也就是并不是所有数据都满足:

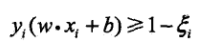

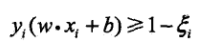

可以为每个样本点引入一个松弛变量ξ,使得函数间隔加上松弛变量大于等于1,这样约束条件就变为:

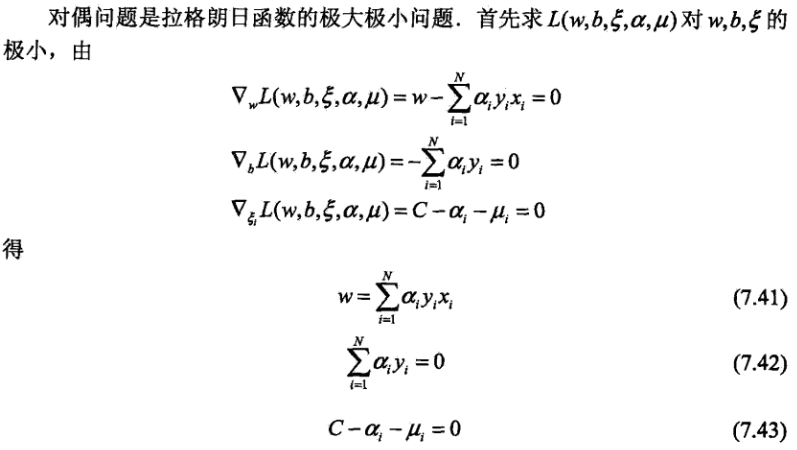

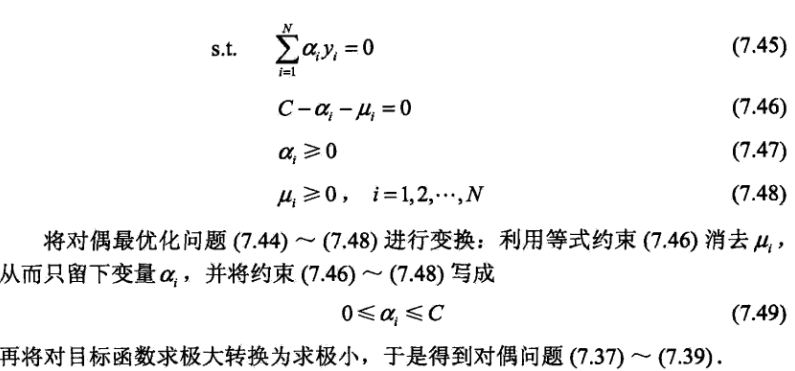

同时对于每一个松弛变量ξ1,支付一个代价ξ1,因此目标函数变为:

C>0称为惩罚系数,一般由应用问题所决定,C值越大时对误分类的惩罚增大,反之减小。

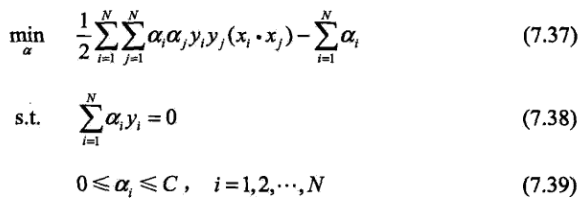

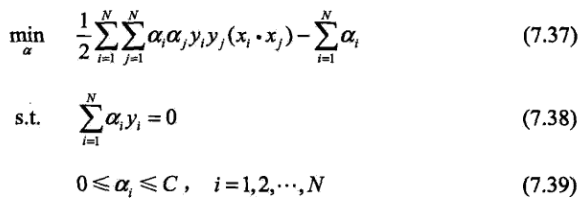

此时,支持向量机就转换为以下问题:

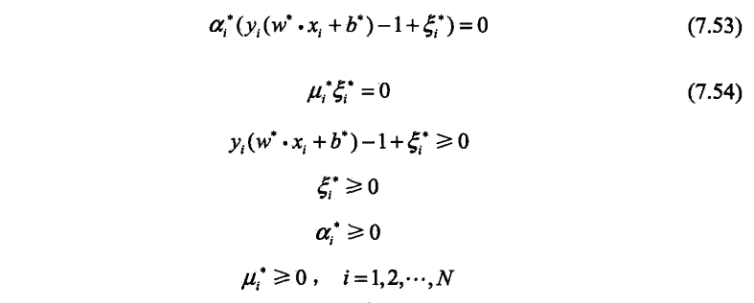

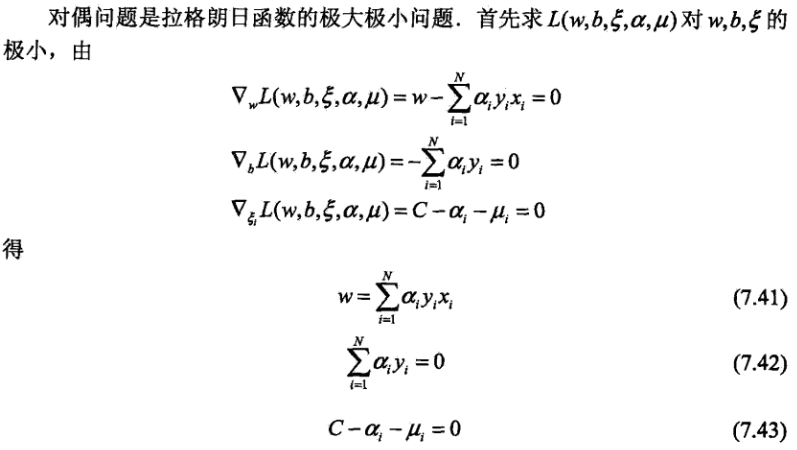

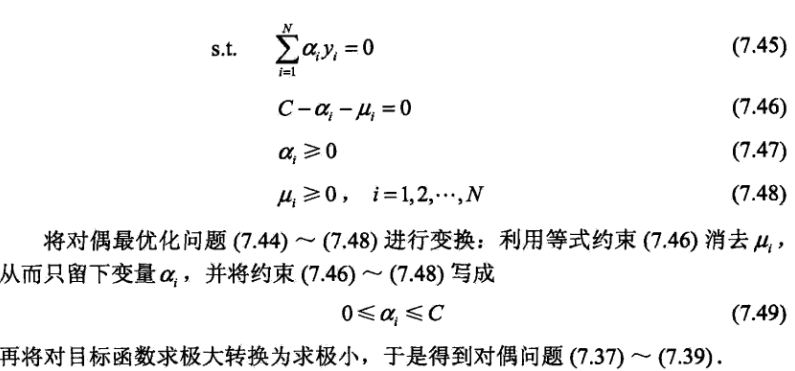

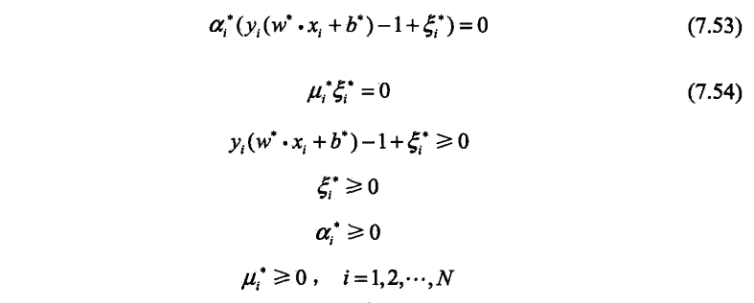

该优化问题的拉格朗日函数是:

摘自统计学习方法,仅供自己复习所用。

上一节所讲的支持向量机是在数据线性可分的情况下的,当数据线性不可分时,也就是并不是所有数据都满足:

可以为每个样本点引入一个松弛变量ξ,使得函数间隔加上松弛变量大于等于1,这样约束条件就变为:

同时对于每一个松弛变量ξ1,支付一个代价ξ1,因此目标函数变为:

C>0称为惩罚系数,一般由应用问题所决定,C值越大时对误分类的惩罚增大,反之减小。

此时,支持向量机就转换为以下问题:

该优化问题的拉格朗日函数是:

摘自统计学习方法,仅供自己复习所用。