一.背景简要说明

利用KNN想做的就是训练出一个分类器,能根据对方的一些特征判断他(她)对你的吸引程度,是不喜欢,还是一般喜欢,还是很喜欢。以此改进约会配对效果。

二.模块代码及注释

1 from numpy import * 2 import operator 3 4 #样本数据集创建函数 5 def creatDataSet(): 6 dataSet = array([[1.0,1.1],[1.0,1.0],[0,0],[0,0.1]]) 7 labels = ['A','A','B','B'] 8 return dataSet,labels 9 10 11 #k-NN简单实现函数 12 def classify0(inX,dataSet,labels,k): 13 14 #求出样本集的行数,也就是labels标签的数目 15 dataSetSize = dataSet.shape[0] 16 17 #构造输入值和样本集的差值矩阵 18 diffMat = tile(inX,(dataSetSize,1)) - dataSet 19 20 #计算欧式距离 21 sqDiffMat = diffMat**2 22 sqDistances = sqDiffMat.sum(axis=1) 23 distances = sqDistances**0.5 24 25 #求距离从小到大排序的序号 26 sortedDistIndicies = distances.argsort() 27 28 #对距离最小的k个点统计对应的样本标签 29 classCount = {} 30 for i in range(k): 31 #取第i+1近邻的样本对应的类别标签 32 voteIlabel = labels[sortedDistIndicies[i]] 33 #以标签为key,标签出现的次数为value将统计到的标签及出现次数写进字典 34 classCount[voteIlabel] = classCount.get(voteIlabel,0) + 1 35 36 #对字典按value从大到小排序 37 sortedClassCount = sorted(classCount.items(),key=operator.itemgetter(1),reverse=True) 38 39 #返回排序后字典中最大value对应的key 40 return sortedClassCount[0][0] 41 42 #从文本文件中解析数据 43 def file2matrix(filename): 44 fr = open(filename) 45 46 #按行读取整个文件的内容 47 arrayOfLines = fr.readlines() 48 49 #求文件行数,即样本总数 50 numberOfLines = len(arrayOfLines) 51 52 #初始化返回数组及列表 53 returnMat = zeros((numberOfLines,3)) 54 classLabelVector = [] 55 56 index = 0 57 for line in arrayOfLines: 58 #截取掉每一行的回车符 59 line = line.strip() 60 #将一行数据根据制表符分割成包含多个元素(特征)的列表 61 listFromLine = line.split(' ') 62 #分割后的特征数据列表存入待返回的numpy数组 63 returnMat[index,:] = listFromLine[0:3] 64 #将文件每一行最后一列的数据存入待返回的分类标签列表 65 classLabelVector.append(int(listFromLine[-1])) 66 #控制待返回的numpy数组进入下一行 67 index+=1 68 return returnMat,classLabelVector 69 70 #特征变量归一化 71 def autoNorm(dataSet): 72 73 #取出每一列的最小值,即每一个特征的最小值 74 minVals = dataSet.min(0) 75 76 #取出每一列的最大值,即每一个特征的最大值 77 maxVals = dataSet.max(0) 78 79 #每一个特征变量的变化范围 80 ranges = maxVals - minVals 81 82 #初始化待返回的归一化特征数据集 83 normDataSet = zeros(shape(dataSet)) 84 85 #特征数据集行数,即样本个数 86 m = dataSet.shape[0] 87 88 #利用tile()函数构造与原特征数据集同大小的矩阵,并进行归一化计算 89 normDataSet = dataSet - tile(minVals,(m,1)) 90 normDataSet = normDataSet/tile(ranges,(m,1)) 91 92 return normDataSet,ranges,minVals 93 94 #分类器测试 95 def datingClassTest(): 96 97 #给定用于测试分类器的样本比例 98 hoRatio = 0.10 99 100 #调用文本数据解析函数 101 datingDataMat,datingLabels = file2matrix('F:/programming tools/datingTestSet2.txt') 102 103 #调用特征变量归一化函数 104 normMat,ranges,minVals = autoNorm(datingDataMat) 105 106 #归一化的特征数据集行数,即样本个数 107 m = normMat.shape[0] 108 109 #用于测试分类器的测试样本个数 110 numTestVecs = int(m*hoRatio) 111 112 #初始化分类器犯错样本个数 113 errorCount = 0.0 114 115 for i in range(numTestVecs): 116 #以测试样本作为输入,测试样本之后的样本作为训练样本,对测试样本进行分类 117 classifierResult = classify0(normMat[i,:],normMat[numTestVecs:m,:],datingLabels[numTestVecs:m],3) 118 119 #对比分类器对测试样本预测的类别和其真实类别 120 print("the classifier came back with: %d,the real answer is: %d" % (classifierResult,datingLabels[i])) 121 122 #统计分类出错的测试样本数 123 if (classifierResult != datingLabels[i]): 124 errorCount+=1.0 125 126 #输出分类器错误率 127 print("the total error rate is: %f" % (errorCount/float(numTestVecs))) 128 129 #约会网站对新输入分类 130 def classifyPerson(): 131 132 #定义一个存储了三个字符串的列表,分别对应不喜欢,一般喜欢,很喜欢 133 resultList = ['not at all','in small dose','in large dose'] 134 135 #用户输入三个特征变量,并将输入的字符串类型转化为浮点型 136 ffMiles = float(input("frequent flier miles earned per year:")) 137 percentats = float(input("percentage of time spent playing video games:")) 138 iceCream = float(input("liters of ice cream consumed per year:")) 139 140 #调用文本数据解析函数 141 datingDataMat,datingLabels = file2matrix('F:programming toolsdatingTestSet2.txt') 142 143 #调用特征变量归一化函数 144 normMat,ranges,minVals = autoNorm(datingDataMat) 145 146 #将输入的特征变量构造成特征数组(矩阵)形式 147 inArr = array([ffMiles,percentats,iceCream]) 148 149 #调用kNN简单实现函数 150 classifierResult = classify0((inArr-minVals)/ranges,normMat,datingLabels,3) 151 152 #将分类结果由数字转换为字符串 153 print("You will probably like this person",resultList[classifierResult - 1])

三.详细解读

新增了4个函数或方法,分别是文本文件解析函数file2matrix,特征变量归一化函数autoNorm,分类器测试方法datingClassTest以及分类器最终对新输入进行分类的方法classifyPerson。

1.文本文件解析函数file2matrix

接受一个参数,即待解析的文件名,注意传入的时候要带上后缀名,如:xxx.txt,否则会说该目录下没有指定文件。

★arrayOfLines = fr.readlines()

按行读取整个文件的内容,返回一个列表,文件的每一行数据以字符串的形式作为列表的一个元素,故numberOfLines = len(arrayOfLines)求出列表元素的数目,也就是文本一共有多少行数据。

python中需要注意.read(),.readline()和.readlines()的区别,以如下test.txt为例

①.read()是一次读取整个文件的内容,并把文件内容放到一个字符串变量中。如下:

②.readline()每次读取文件的一行,将读取到的一行内容放到一个字符串变量中,再次调用时会继续读下一行。如下:

③.readlines()每次按行读取整个文件内容,将读取到的内容放到一个列表中,文件每一行内容以字符串的形式作为列表的一个元素。如下:

注意:hello world下方有三行空行的原因是文件每行结尾都有一个换行符(除了最后一行),再加上print()本身输出一个元素后会自动换行。

★line = line.strip()

按行读取文本内容时,截取掉每一行的回车符。如下:

★listFromLine = line.split(' ')

将一行数据根据制表符分割成包含一个或多个元素(特征)的列表,例如如下的test文件中第三行python与3.4之间存在制表符,则这一行返回的列表包含两个元素,每个元素都是一个字符串,其几行因为没有制表符,故返回的是只含有一个元素的列表。对列表直接print的结果和对列表按元素print的结果也是不同的。应用这条语句的目的是把文件中每行以制表符分隔开的多个特征数据分别作为一个元素提取到列表中。

★returnMat[index,:] = listFromLine[0:3]

将分割后的特征数据列表存入待返回的numpy数组。这里只存前3列的数据,因为前3列代表特征变量,最后一列是分类标签。

★classLabelVector.append(int(listFromLine[-1]))

将文件每一行最后一列的数据存入待返回的分类标签列表,我们提取到的是字符串形式的标签,要转换为整型后再存入代表分类标签的列表。

2.特征变量归一化函数autoNorm

使用特征变量归一化的目的是在计算欧式距离时防止那些数字差值很大的特征变量对计算结果的影响太大,尽量维持特征的等权重,不让某一个特征对分类结果的影响明显大于其他特征。利用下面的公式将任意取值范围的特征值转换为0到1区间内的值:

newValue = (oldValue-min) / (max-min) (☆)

★minVals = dataSet.min(0)

取出每一列的最小值,即每一个特征的最小值。

★maxVals = dataSet.max(0)

取出每一列的最大值,即每一个特征的最大值。.min(0)和.max(0)里的0代表按列取最小值和最大值,若要取出每一行的最小或最大值则要使用.min(1)或.max(1)。★normDataSet = zeros(shape(dataSet))

初始化待返回的归一化特征数据集,shape以一个元组的形式返回dataSet的行数m和列数3。zero((m,3))将其初始化为一个m行3列的全0矩阵。

★normDataSet = dataSet - tile(minVals,(m,1))

★normDataSet = normDataSet/tile(ranges,(m,1))

★normDataSet = normDataSet/tile(ranges,(m,1))

利用tile()函数构造与原特征数据集同大小的矩阵,并利用(☆)式进行归一化计算。

关于tile()的用法,前面已经提到,这里再给出链接,numpy库tile用法。

3.分类器测试函数datingClassTest

将一些分类标签已知的测试样本输入分类器,比较分类器的输出结果和样本的实际分类标签,以测试分类器的错误率。错误率=对测试样本分类出错的个数/测试样本总数。

★hoRatio = 0.10

给定用于测试分类器的样本比例为0.1,另外90%的样本作为训练样本。

★datingDataMat,datingLabels = file2matrix('F:/programming tools/datingTestSet2.txt')

调用文本数据解析函数,得到特征变量和分类标签。★normMat,ranges,minVals = autoNorm(datingDataMat)

调用特征变量归一化函数,得到归一化的特征变量,每一个特征的范围,每一个特征的最小值。

★numTestVecs = int(m*hoRatio)

求出用于测试分类器的测试样本个数,因为样本个数必须为整数,故使用int取整。

★classifierResult = classify0(normMat[i,:],normMat[numTestVecs:m,:],datingLabels[numTestVecs:m],3)

以测试样本作为输入,测试样本之后的样本作为训练样本,对测试样本进行分类。这里调用了kNN简单实现函数classify0。

normMat[i,:]为当前的测试样本归一化的输入特征,normMat[numTestVecs:m,:]为训练样本归一化的特征矩阵,datingLabels[numTestVecs:m]为与之对应的训练样本的分类标签向量,3代表k的取值,实际操作时可以自行更改。

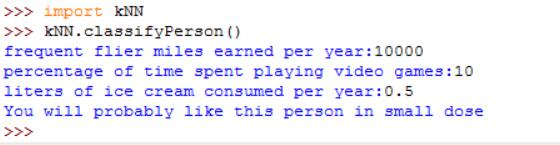

定义一个存储了三个字符串的列表,分别对应不喜欢,一般喜欢,很喜欢

★ffMiles = float(input("frequent flier miles earned per year:"))

percentats = float(input("percentage of time spent playing video games:"))

iceCream = float(input("liters of ice cream consumed per year:"))

percentats = float(input("percentage of time spent playing video games:"))

iceCream = float(input("liters of ice cream consumed per year:"))

注意这里用户输入的东西会被当成是字符串,所以一定要转换为我们需要的类型。

★inArr = array([ffMiles,percentats,iceCream])

将输入的特征变量构造成特征数组(矩阵)形式。

★classifierResult = classify0((inArr-minVals)/ranges,normMat,datingLabels,3)

调用kNN简单实现函数对新的输入进行分类,注意要将输入特征归一化。

★print("You will probably like this person",resultList[classifierResult - 1])

将分类结果由数字转换为字符串。