人工神经网络概述:

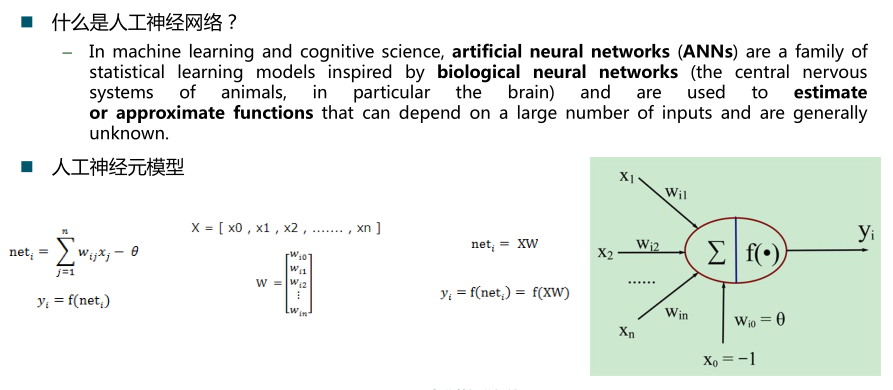

人工神经元模型:

神经网络的分类:

按照连接方式,可以分为:前向神经网络 vs. 反馈(递归)神经网络;

按照学习方式,可以分为:有导师学习神经网络 vs. 无导师学习神经网络;

按照实现功能,可以分为:拟合(回归)神经网络 vs. 分类神经网络。

数据归一化:将数据映射到[0, 1]或[-1, 1]区间或其他的区间。

数据归一化的原因:

1.输入数据的单位不一样,有些数据的范围可能特别大,导致的结果是神经网络收敛慢、训练时间长。

2.数据范围大的输入在模式分类中的作用可能会偏大,而数据范围小的输入作用就可能会偏小。

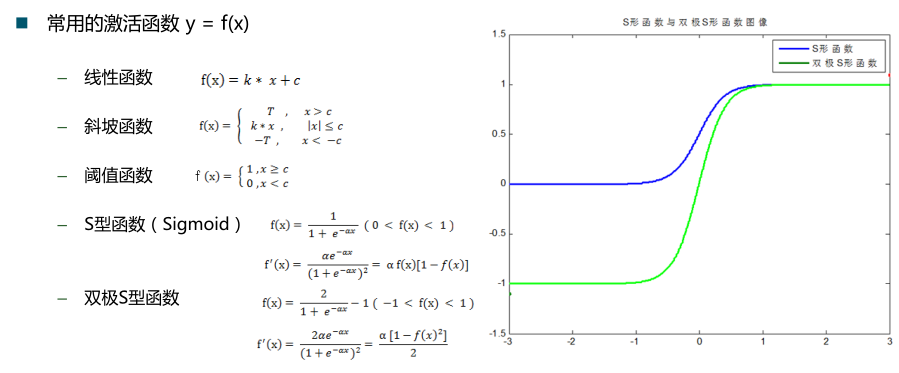

3.由于神经网络输出层的激活函数的值域是有限制的,因此需要将网络训练的目标数据映射到激活函数的值域。例如神经网络的输出层若采用S形激活

函数,由于S形函数的值域限制在(0,1),也就是说神经网络的输出只能限制在(0,1),所以训练数据的输出就要归一化到[0,1]区间。

4.S形激活函数在(0,1)区间以外区域很平缓,区分度太小。例如S形函数f(X)在参数a=1时,f(100)与f(5)只相差0.0067。

归一化算法:

1.y = ( x - min )/( max - min );

2.y = 2 * ( x - min ) / ( max - min ) - 1。

部分函数:

参数对BP神经网络性能的影响:

隐含层神经元节点个数

激活函数类型的选择

学习率

初始权值与阈值

交叉验证

训练集

测试集

验证集

留一法

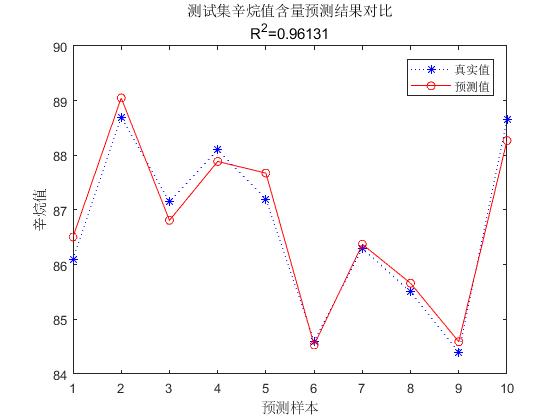

MATLAB实现程序:

1 %% I. 清空环境变量 2 clear all 3 clc 4 5 %% II. 训练集/测试集产生 6 %% 7 % 1. 导入数据 8 load spectra_data.mat 9 10 %% 11 % 2. 随机产生训练集和测试集 12 temp = randperm(size(NIR,1)); 13 % 训练集——50个样本 14 P_train = NIR(temp(1:50),:)'; 15 T_train = octane(temp(1:50),:)'; 16 % 测试集——10个样本 17 P_test = NIR(temp(51:end),:)'; 18 T_test = octane(temp(51:end),:)'; 19 N = size(P_test,2); 20 21 %% III. 数据归一化 22 [p_train, ps_input] = mapminmax(P_train,0,1); 23 p_test = mapminmax('apply',P_test,ps_input); 24 25 [t_train, ps_output] = mapminmax(T_train,0,1); 26 27 %% IV. BP神经网络创建、训练及仿真测试 28 %% 29 % 1. 创建网络 30 net = newff(p_train,t_train,9); 31 32 %% 33 % 2. 设置训练参数 34 net.trainParam.epochs = 1000; 35 net.trainParam.goal = 1e-3; 36 net.trainParam.lr = 0.01; 37 38 %% 39 % 3. 训练网络 40 net = train(net,p_train,t_train); 41 42 %% 43 % 4. 仿真测试 44 t_sim = sim(net,p_test); 45 46 %% 47 % 5. 数据反归一化 48 T_sim = mapminmax('reverse',t_sim,ps_output); 49 50 %% V. 性能评价 51 %% 52 % 1. 相对误差error 53 error = abs(T_sim - T_test)./T_test; 54 55 %% 56 % 2. 决定系数R^2 57 R2 = (N * sum(T_sim .* T_test) - sum(T_sim) * sum(T_test))^2 / ((N * sum((T_sim).^2) - (sum(T_sim))^2) * (N * sum((T_test).^2) - (sum(T_test))^2)); 58 59 %% 60 % 3. 结果对比 61 result = [T_test' T_sim' error'] 62 63 %% VI. 绘图 64 figure 65 plot(1:N,T_test,'b:*',1:N,T_sim,'r-o') 66 legend('真实值','预测值') 67 xlabel('预测样本') 68 ylabel('辛烷值') 69 string = {'测试集辛烷值含量预测结果对比';['R^2=' num2str(R2)]}; 70 title(string)

运行效果截图:

附测试代码及数据:https://github.com/shixinzei/Learn-about-Back-Propagation-Neural-Network