1.下载安装包

下载hadoop安装包

官网地址:https://hadoop.apache.org/releases.html

版本:建议使用hadoop-2.7.3.tar.gz

系统环境:CentOS 7

注:需要装有JDK支持,版本1.8或者更高

2.解压安装包

- 默认软件安装路径为 /usr/soft,因此先传输安装包到该路径下

cd /usr/soft

tar -zxvf hadoop-2.7.3.tar.gz

3.环境变量配置

vi /ect/profile

文件末尾换行追加以下内容

export HADOOP_HOME=/usr/soft/hadoop-2.7.3

export HADOOP_MAPRED_HOME=HADOOP_HOME

export HADOOP_COMMON_HOME=HADOOP_HOME

export HADOOP_HDFS_HOME=HADOOP_HOME

export YARN_HOME=HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=HADOOP_HOME/lib/native

export PATH=PATH:HADOOP_HOME/sbin:HADOOP_HOME/bin

export HADOOP_INSTALL=$HADOOP_HOME

修改完配置后,更新文件

source /etc/profile

4.伪分布式配置

文件目录:/usr/soft/hadoop-2.7.3/etc/hadoop/

需要修改的文件:core-site.xml、hdfs-site.xml、mapred-site.xml 、yarn-site.xml

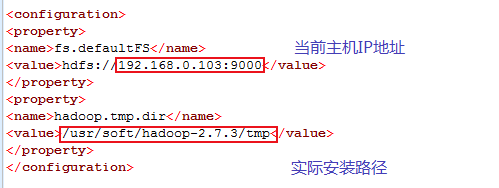

a) core-site.xml

先在hadoop文件夹内touch一个目录名为tmp

cd /usr/soft/hadoop-2.7.3

mkdir tmp

向文件中的configuration标签内添加以下内容:

1)fs.defaultFS = hdfs://192.168.0.103:9000 默认文件系统(本地默认 file:/位置)此处端口与HBASE端口设成一样

2)hadoop.tmp.dir=/usr/soft/hadoop-2.7.3/tmp

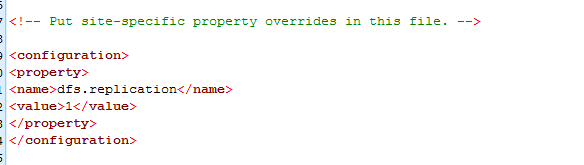

b) hdfs.site.xml

dfs.replication = 1 (副本个数,最少3个伪分布只写1个),进程于主机关系

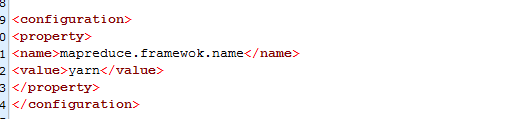

c) mapred-site.xml

目录内并没有全名为mapred-site.xml的文件,但是有一个名为:mapred-site.xml.template

复制该文件重新命名为mapred-site.xml;

cd /usr/soft/hadoop-2.7.3/etc/hadoop/

cp mapred-site.xml.template mapred-site.xml

修改配置文件:Mapreduce.framewok.name=yarn ,设置映射化简模型框架为yarn

<property>

<name>mapreduce.framewok.name</name>

<value>yarn</value>

</property>

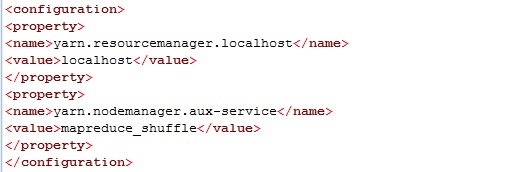

d) yarn-site.xml

Yarn.resourcemanager.localhost=localhost //yarn站点名称

Yarn.nodemanager.aux-service=mapreduce_shuffle //辅助节点管理

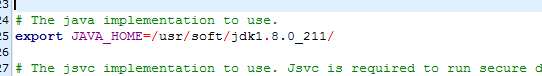

e) hadoop-env.sh (可选)

最好将jdk配置的相对路径更改为绝对路径

文件修改完成!

5.配置SSH(安全套接字处理)

目的是使用脚步启动远程服务器的启动,必须使用shell登陆远程服务,但每个登陆都需要输入密码就非常麻烦,所有需要配置无密配置,需要在NameNode上生成私钥,把公钥发给DataNode

a) 生成秘钥对

ssh-keygen -t rsa

b)把公钥拷贝到秘钥库中

伪分布式时,复制到自己

cd ~/.ssh/

cat id_rsa.pub >> authorized_keys

完全分布式时,复制到DataNode(另一个计算机节点)

scp root@主机名:~/.ssh/id_rsa.pub ~/.ssh/id_rsa.pub

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

c) 把authorized_key权限设置为600

chmod 600 ~/.ssh/authorized_keys

注:想在宿主机中访问hadoop站点步骤

修改虚拟机中/etc/hosts文件删除127.0.0.1信息

增加信息

本机IP master

本机IP slave

本机IP localhost

6.格式化NameNode

hdfs namenode -format

如果提示没找到命令,重新检查第三步环境变量配置

7.启动Hadoop

启动命令(都存放在sbin 文件夹下)

cd /usr/soft/hadoop-2.7.3/sbin/

start-all.sh

或

start-dfs.sh

start-yarn.sh

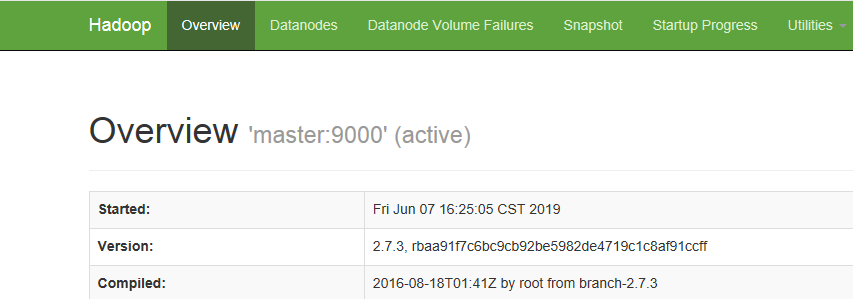

8 检查启动状态

浏览器访问地址,出现页面即成功

本机地址:50070