吴恩达机器学习全套笔记博客地址

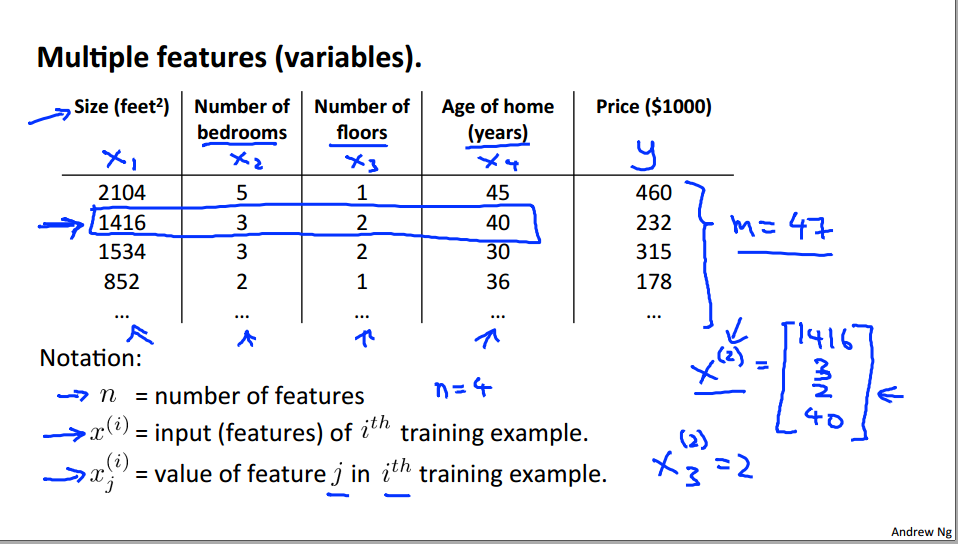

一、多元线性回归的模型表示

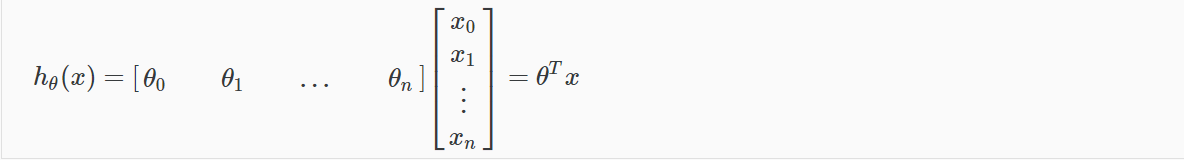

输入变量x中包含n个特征变量:

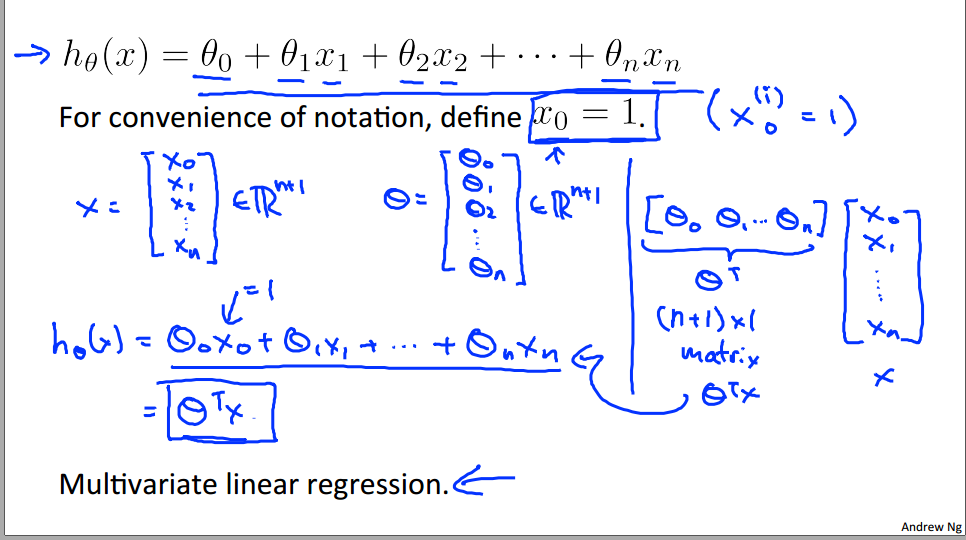

假设函数的参数随着特征变量的增多而增多:

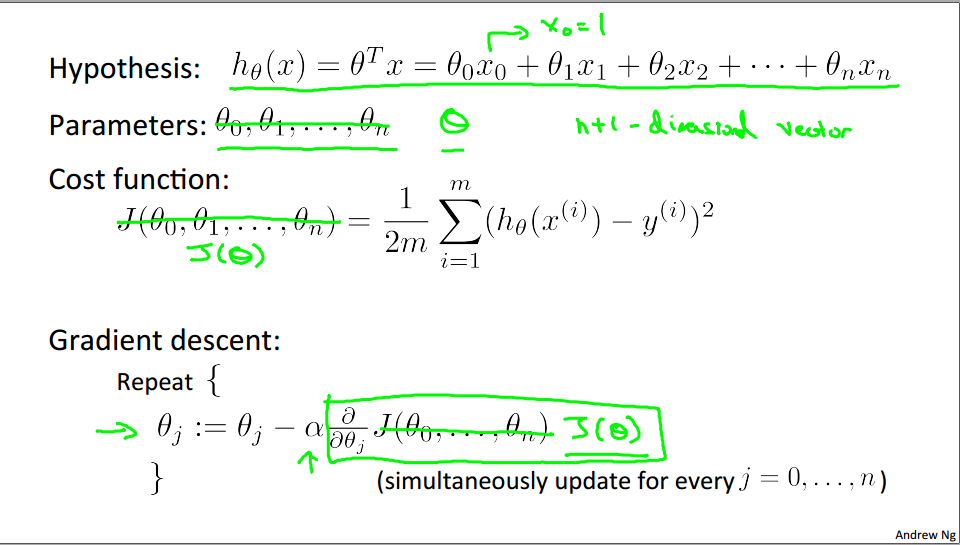

代价函数的变化:

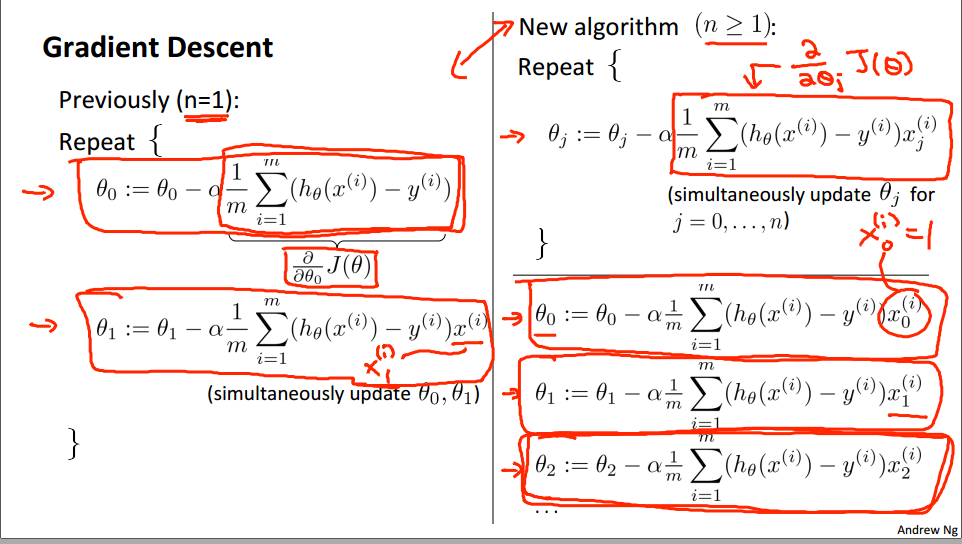

梯度下降算法的变化:

简单来说:

二、特征缩放 feature scaling

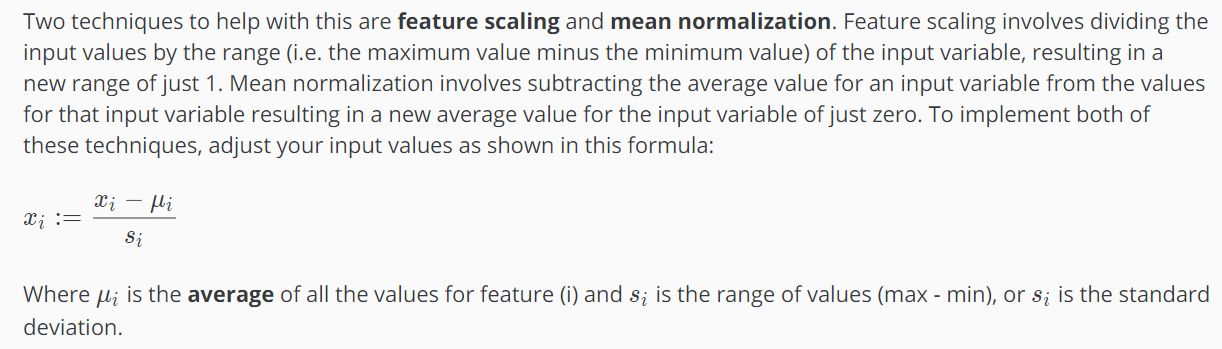

特征变量的单位不同意,所以进行归一化:

特征缩放:除以最大值和最小值的差,控制结果在0-1之间

均值归一标准化:减去平均值后除以标准差或者最大最小差

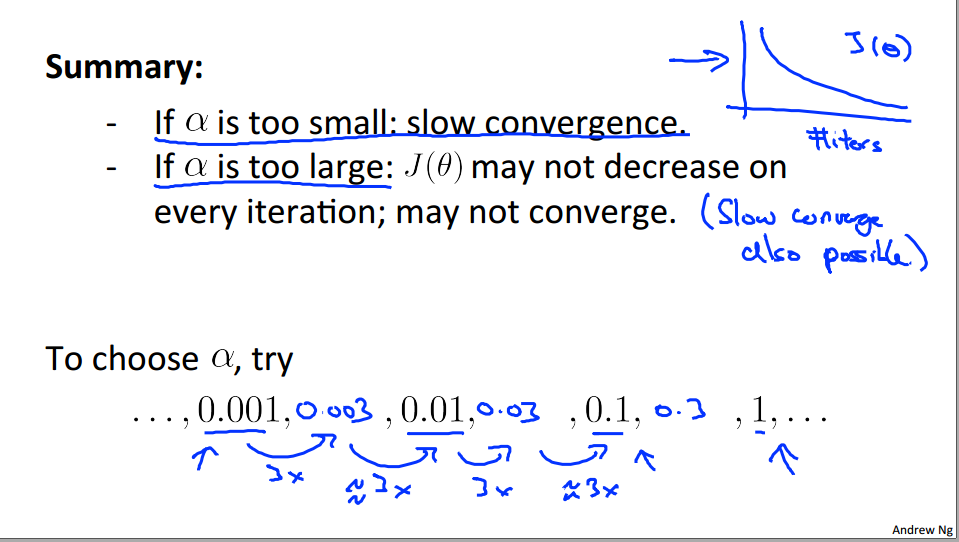

三、学习速率的选择

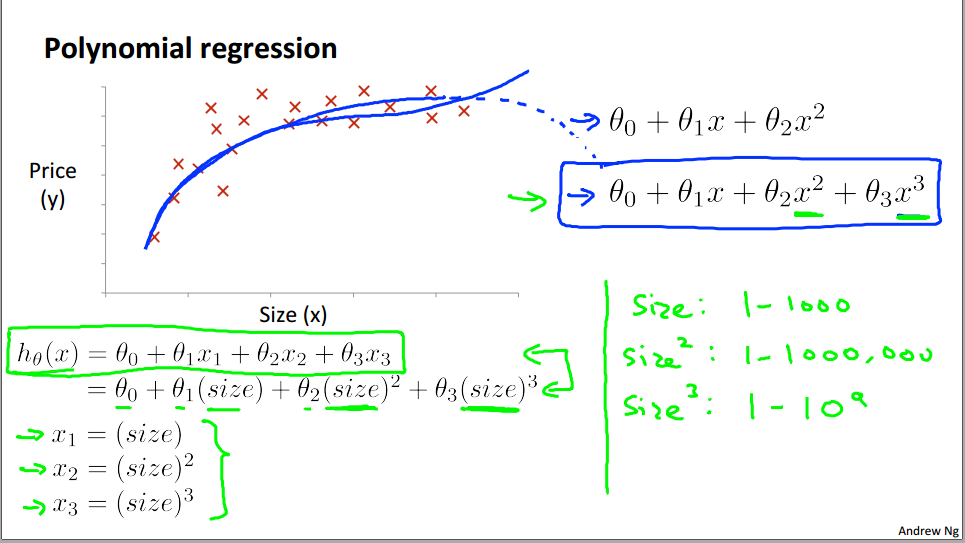

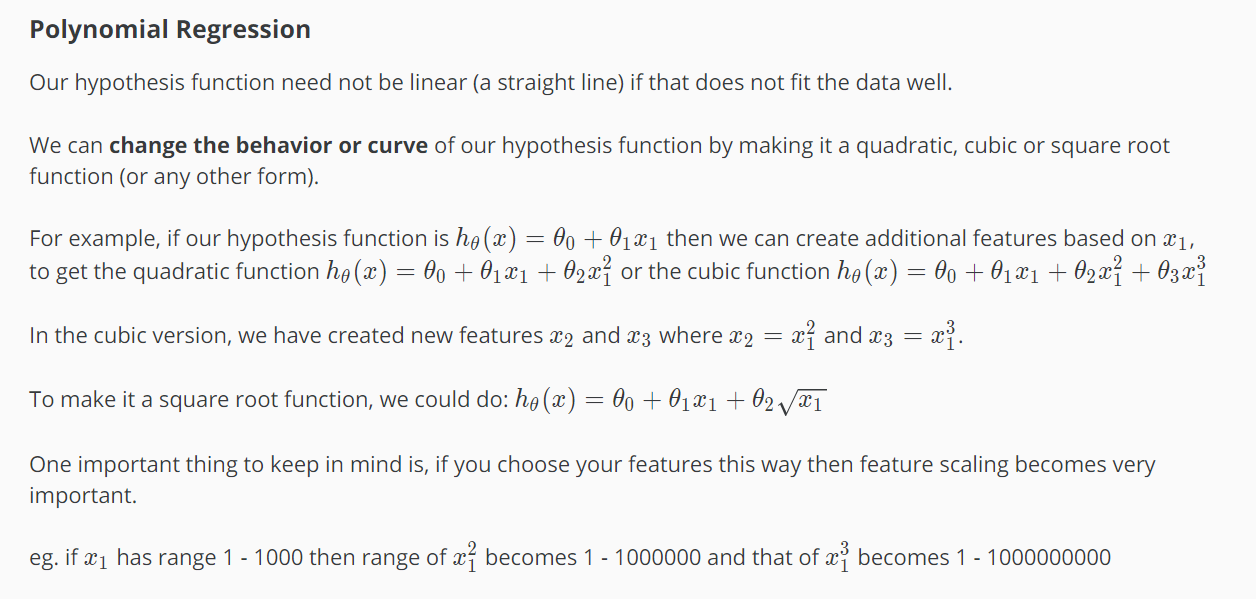

四、多项式回归

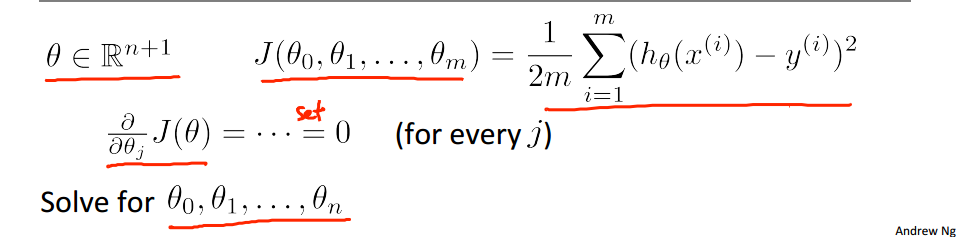

五、正规方程normal equation(基础的最小二乘法,通过代数推导的方式)

设梯度值为0,进行参数的求解:

最终结果:

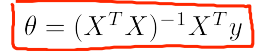

数据的表示形式:

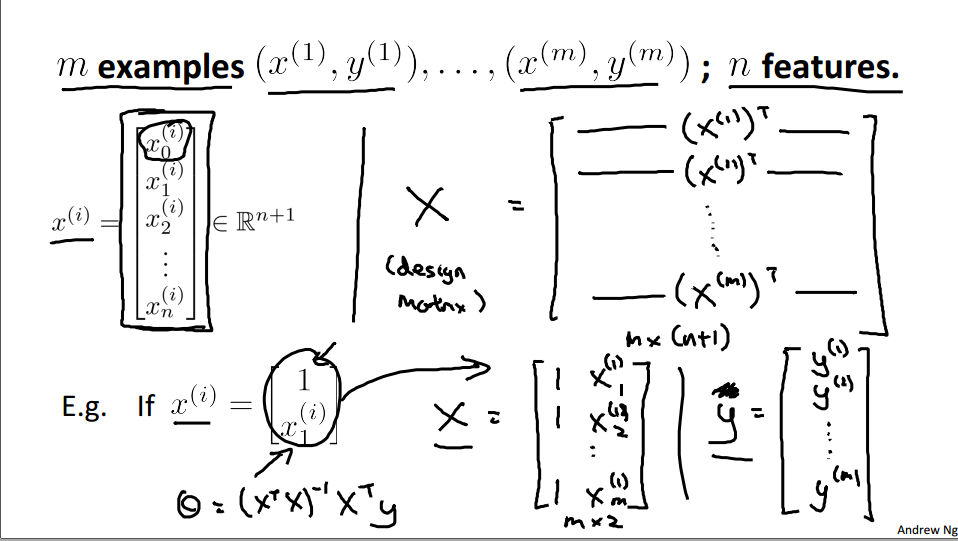

正规方程和梯度下降法的区别:

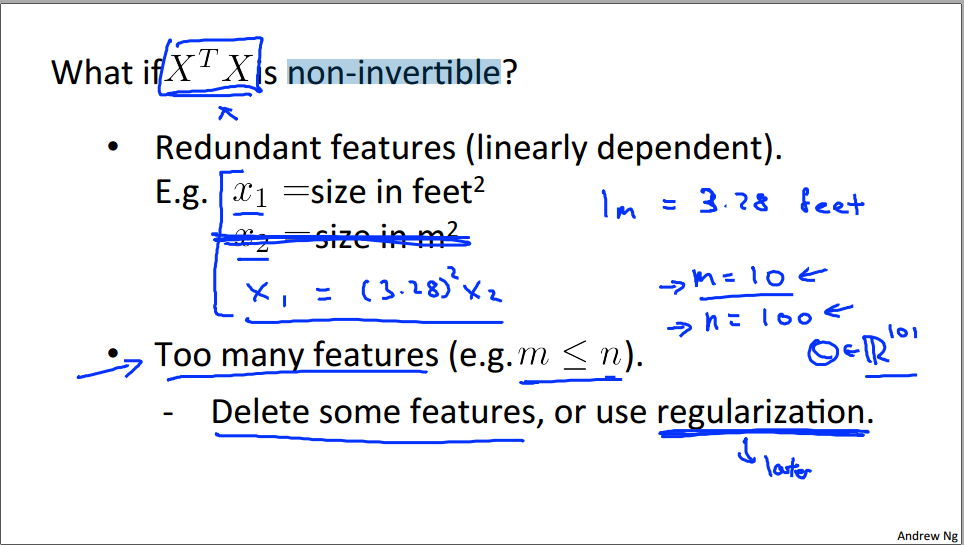

如果 不可逆怎么办?——删除某些特征变量

不可逆怎么办?——删除某些特征变量