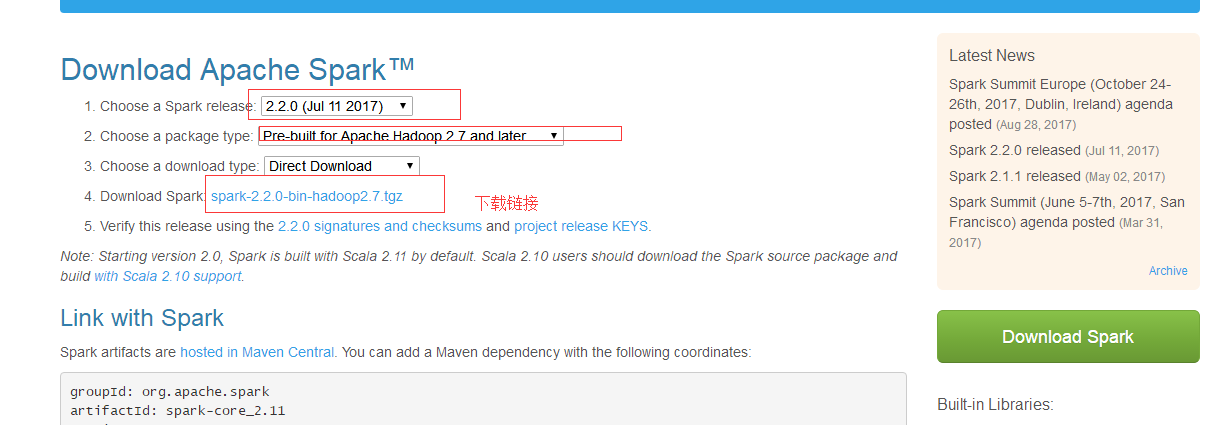

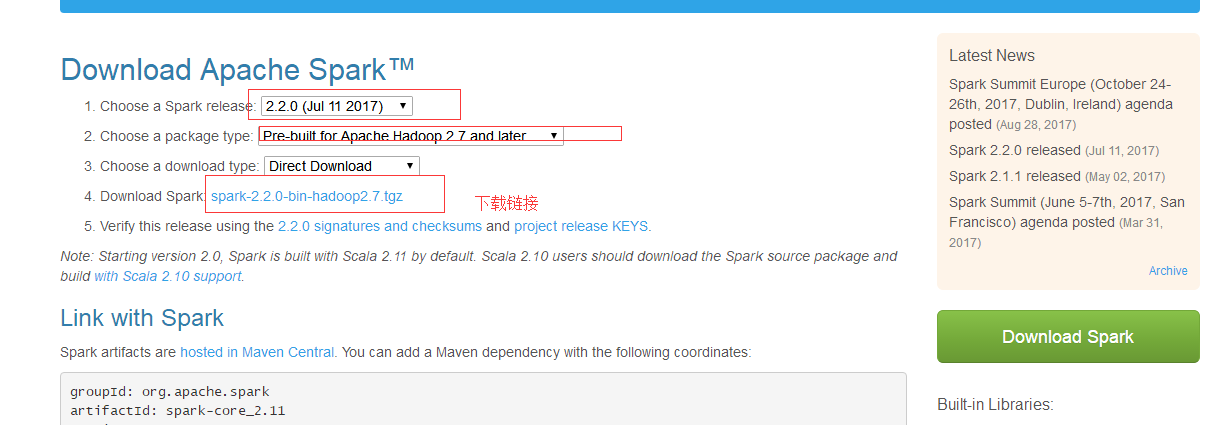

1.spark编译版安装 首先去官网下载 http://spark.apache.org/downloads.html

页面上有下载按键点击 之后选择对应的编译的Hadoop版本

2 下载完成之后解压

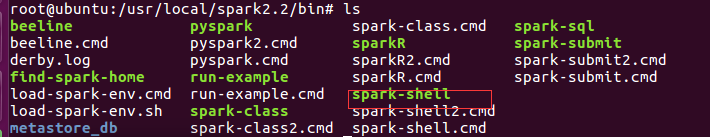

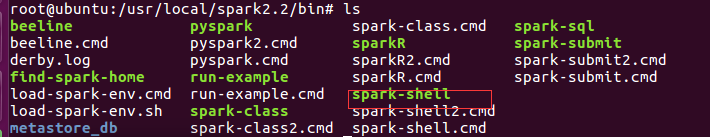

进入解压文件夹的bin目录

其中 spark-shell 是运行scale语言的命令窗口,pyspark 是运行Python的命令窗口

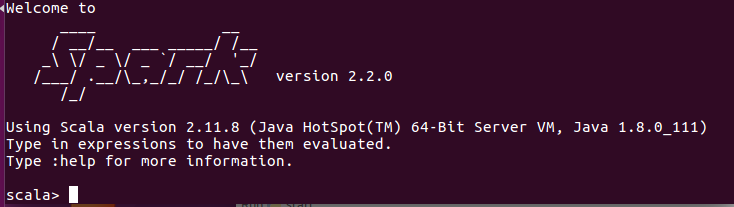

我们运行./spar-shell

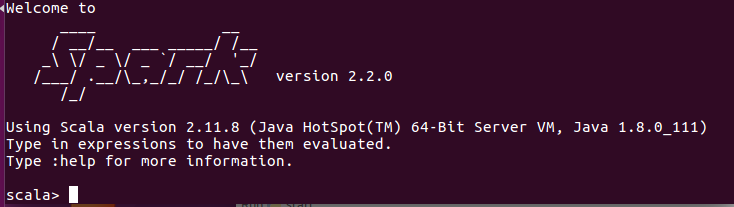

经过一大串日志之后出现下面的就成功了

1.spark编译版安装 首先去官网下载 http://spark.apache.org/downloads.html

页面上有下载按键点击 之后选择对应的编译的Hadoop版本

2 下载完成之后解压

进入解压文件夹的bin目录

其中 spark-shell 是运行scale语言的命令窗口,pyspark 是运行Python的命令窗口

我们运行./spar-shell

经过一大串日志之后出现下面的就成功了