用Idea搭建我们的Spark环境

用IDEA搭建我们的环境有很多好处,其中最大的好处,就是我们甚至可以在工程当中直接运行、调试我们的代码,在控制台输出我们的结果。或者可以逐行跟踪代码,了解spark运行的机制。因此我们选择了idea,当然Idea不是首选,当然也可以用其他工具。因为我们的Spark程序用scala和java写,需要有java环境来作为支撑。因此任何能够支撑java程序的开发工具,应该都能够搭建我们的Spark程序。我这里是MAC环境下,当然如果你是windows不用担心,这里只涉及到idea的操作,不涉及操作系统环境的更改,所以你无须担心,因为Idea在Mac下和windows下并无多大差别

第一步,下载插件,如果你只想用Java而不想用Scala,则可以跳过这一步

在preference中找到plugins,搜索scala,然后下载该插件

第二步,创建maven项目

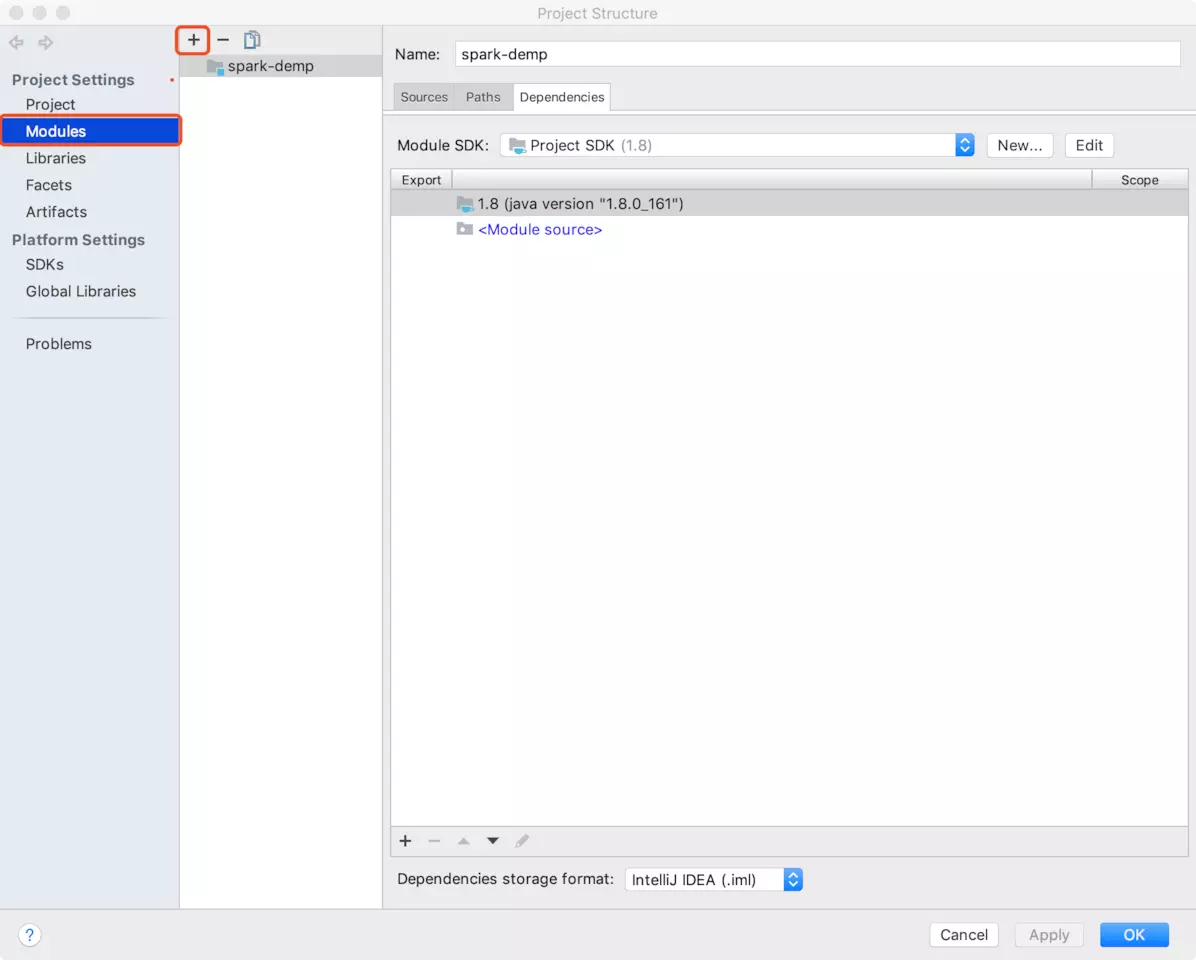

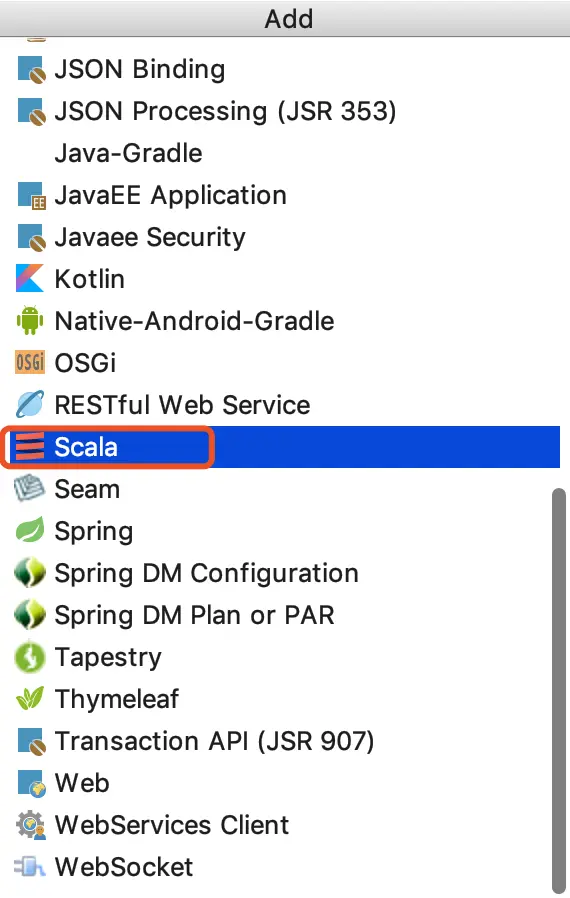

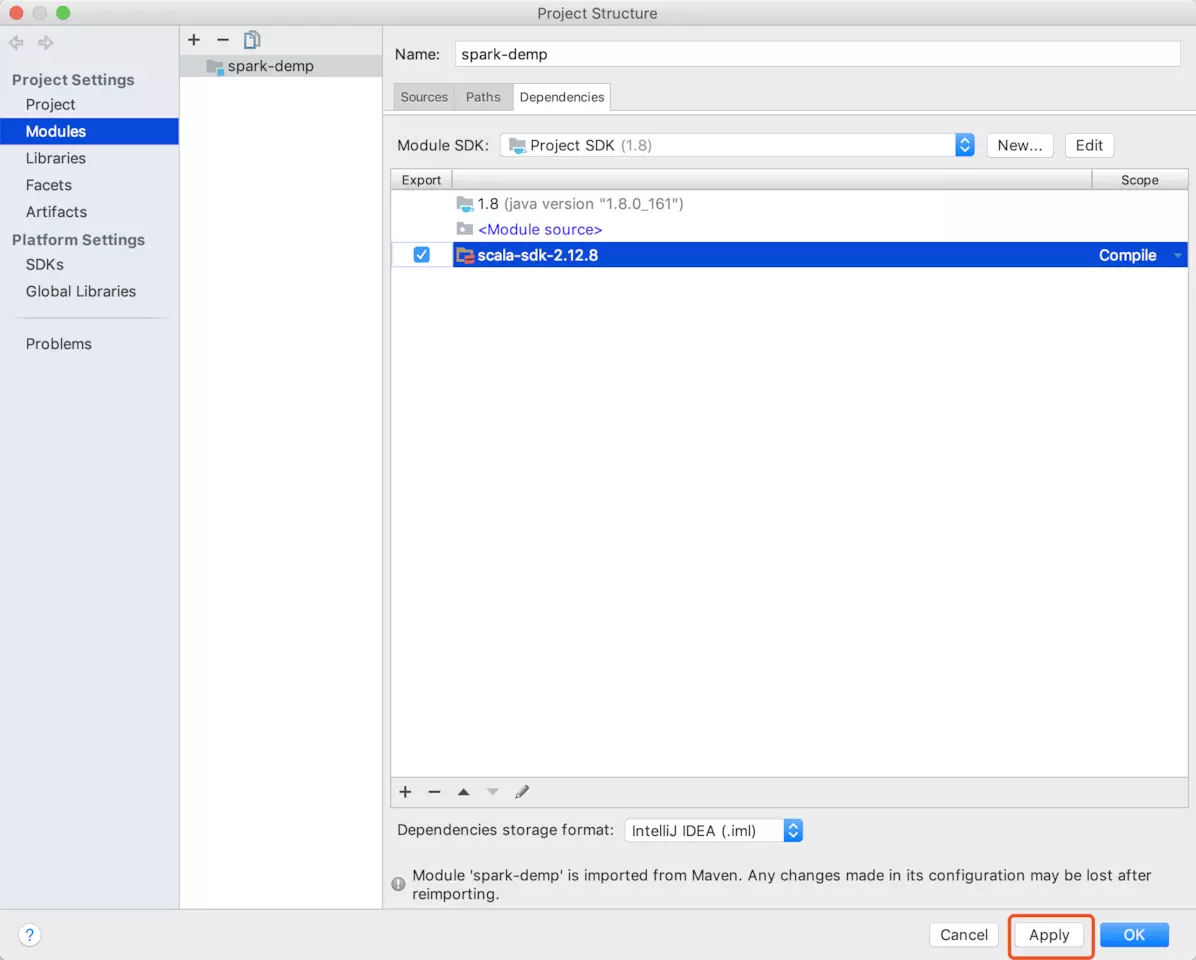

第三步,导入scala的SDK,如果你只想用Java而不想用Scala,则可以跳过这一步

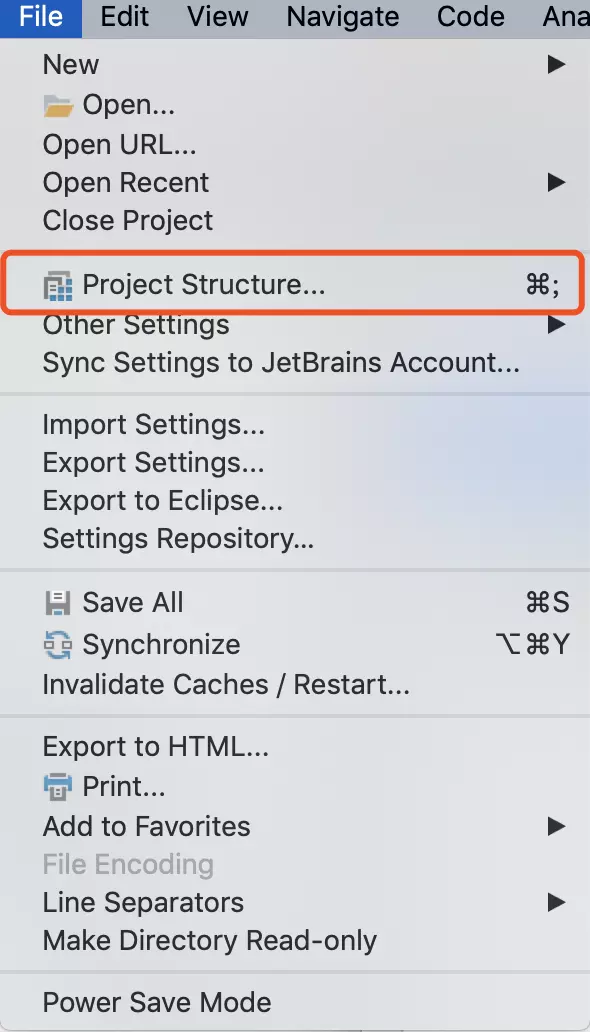

打开project structure

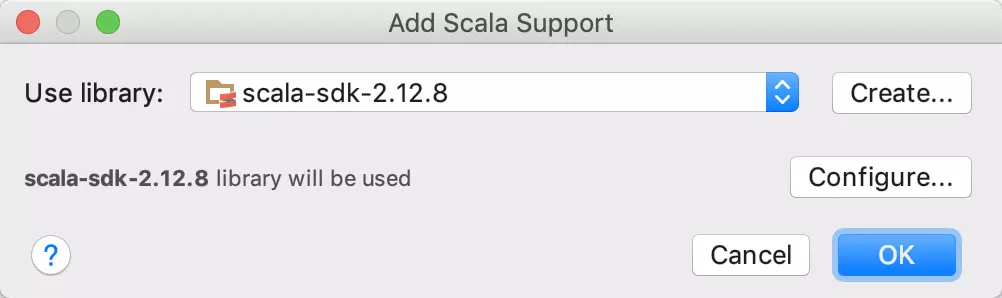

导入SDK

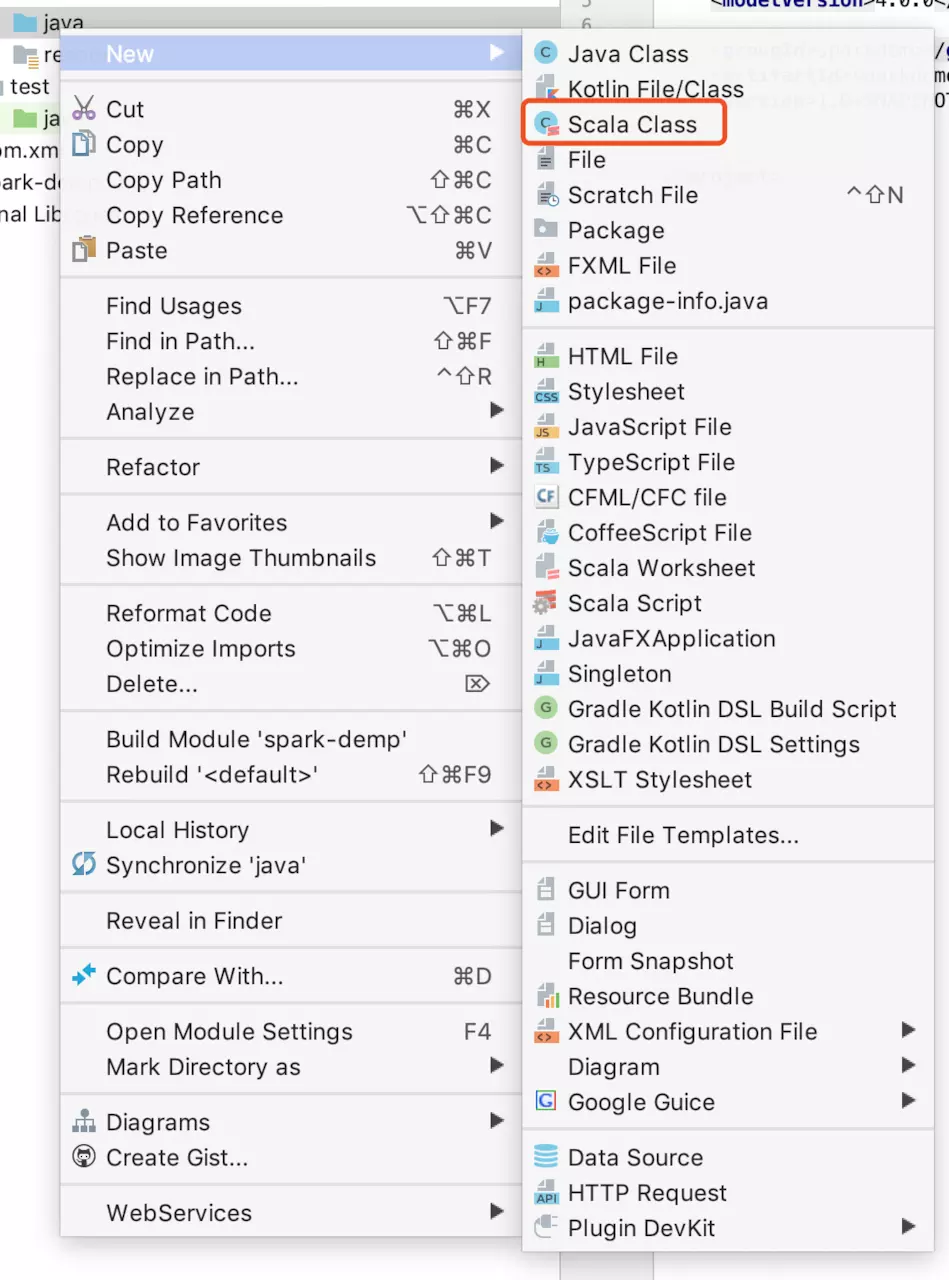

此时可以创建Scala的class文件了

第四步,在pom中导入插件和依赖

插件主要是帮助打包scala包,方便再spark平台上发布我们的程序。当然仅仅最开始我们尽可能将项目运行在idea中,而不需要发布。依赖是spark运行所必须的jar,其中spark的核心spark-core主要是用scala编写的,当然你也能够用java去使用。

在pom文件中导入

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>sparkdemo</groupId>

<artifactId>sparkdemo</artifactId>

<version>1.0-SNAPSHOT</version>

<build>

<finalName>HiveTest</finalName>

<plugins>

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-compiler-plugin</artifactId>

<configuration>

<source>1.8</source>

<target>1.8</target>

</configuration>

</plugin>

<plugin>

<groupId>org.scala-tools</groupId>

<artifactId>maven-scala-plugin</artifactId>

<version>2.15.2</version>

<executions>

<execution>

<goals>

<goal>compile</goal>

<goal>testCompile</goal>

</goals>

</execution>

</executions>

</plugin>

</plugins>

</build>

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>2.8.4</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.11</artifactId>

<version>2.1.3</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-hive_2.11</artifactId>

<version>2.1.3</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-sql_2.11</artifactId>

<version>2.1.3</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-streaming_2.11</artifactId>

<version>2.1.3</version>

</dependency>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-mllib_2.11</artifactId>

<version>2.1.3</version>

</dependency>

<dependency>

<groupId>mysql</groupId>

<artifactId>mysql-connector-java</artifactId>

<version>5.1.20</version>

</dependency>

</dependencies>

</project>

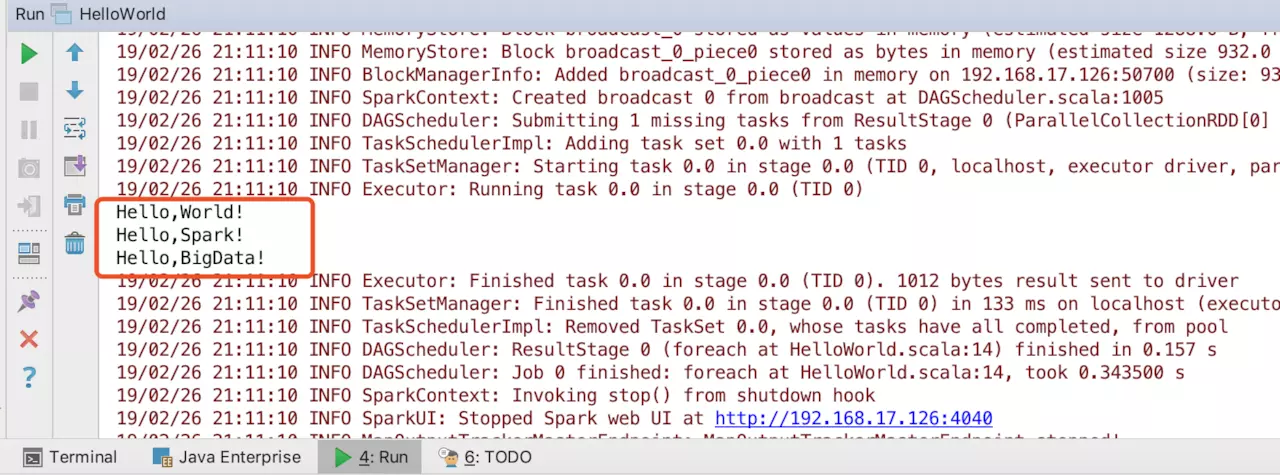

第五步,运行我们的第一个程序

当我们学习任何一项技术的时候,我们都有一个爱好,喜欢先输出Hello,World!在Spark中亦是如此,我们第一个项目也是Hello,World!当然很多人说,spark的Hello,World!应该是字数统计(即统计一本书的或者一个文件的单词数)。当然这也没错,毕竟spark的最核心的功能是大数据和机器学习,但是对一个初学者来说,我认为,不妨再简单些。

创建Scala文件

接下来可以开始写我们的第一个第一个程序。

首先创建一个SparkConf(),即spark的基础配置,主要设置了master为“local”即运行在本机而非集群,第二个是AppName。而后创建SparkContext,这里取名为sc和我们在spark-shell中默认的一致。最后为sc设置内容,即一个list,其中包含三句话。依次输出三句话

scala实现

package spark import org.apache.spark.{SparkConf, SparkContext} object HelloWorld { def main(args: Array[String]): Unit = { val conf = new SparkConf().setMaster("local").setAppName("HelloWorld") val sc = new SparkContext(conf) val helloWorld = sc.parallelize(List("Hello,World!","Hello,Spark!","Hello,BigData!")) helloWorld.foreach(line => println(line)) } }

运行得到:

Hello,World!

Hello,Spark!

Hello,BigData!

java实现

import org.apache.spark.SparkConf; import org.apache.spark.api.java.JavaRDD; import org.apache.spark.api.java.JavaSparkContext; import java.util.Arrays; public class HelloWorldJava { public static void main(String[] args){ SparkConf conf = new SparkConf().setMaster("local").setAppName("HelloWorldJava"); JavaSparkContext sc = new JavaSparkContext(conf); JavaRDD<String> helloWorld = sc.parallelize(Arrays.asList("Hello,World","Hello,Spark","Hello,BigData")); System.out.println(helloWorld.collect()); } }

运行得到:

[Hello,World, Hello,Spark, Hello,BigData]

python实现

from pyspark import SparkConf,SparkContext conf = SparkConf().setMaster("local").setAppName("HelloWorld") sc = SparkContext(conf=conf) helloWorld = sc.parallelize(["Hello,World","Hello,Spark","Hello,BigData"]).collect() print(helloWorld)

运行得到:

['Hello,World', 'Hello,Spark', 'Hello,BigData']

至此我们就在scala、java、python中运行了我们的第一个spark程序。当然,我们可以选择自己最上手的语言去写spark程序,spark本身也非常良好地支持了这三种语言。因此不要让语言成为障碍,反而因此获得更多的选择。无论是java、scala还是python都能写出良好运行的spark程序