全连接层的输入是固定大小的,如果输入向量的维数不固定,那么全连接的权值参数的量也是不固定的,就会造成网络的动态变化,无法实现参数训练目的。

全连接层的计算其实相当于输入的特征图数据矩阵和全连接层权值矩阵进行内积,在配置一个网络时,全连接层的参数维度是固定的,所以两个矩阵要能够进行内积,则输入的特征图的数据矩阵维数也需要定。

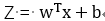

大家都知道,  ,全连接神经网络结构一旦固定,需要学习的参数w是固定的,例如 输入图像是 28*28 = 784,w 的转置= (500,784),===> 输出矩阵的shape:(500,1),如果输入图像的大小改变,但是w的大小并不会改变,因此,无法计算。

,全连接神经网络结构一旦固定,需要学习的参数w是固定的,例如 输入图像是 28*28 = 784,w 的转置= (500,784),===> 输出矩阵的shape:(500,1),如果输入图像的大小改变,但是w的大小并不会改变,因此,无法计算。

而对于卷积神经网络,卷积核的每个元素表示参数w,不论输入图像大小怎么改变,卷积核大小是不变的,并且通过卷积操作,每次都能训练到卷积核中的元素,所以卷积神经网络的输入图像的大小是任意的。

综上,固定大小这个限制只是发生在了网络的深层(高层)处。