晚上闲下来对这个问题又研究了下。插句闲话,windows程序设计应该算是当初学习计算机的初心,所以在个人的理解中

都上升到信仰的高度了:)-。所以一年又一年,年复一年,只要有时间就静下来学一下,虽然在实际项目从来都用不上,但是并不影响情怀。

下面进入主题。

逻辑坐标和设备坐标,我记得在好几年前写了两篇,这一篇从另一个角度直接验证结论,这篇我们从实证中再次理解这个问题。

----

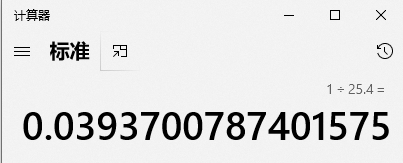

知识点一:一英寸等于25.4mm

这个知识点没有特别需要说明的,但是对于一些程序员来说,可能很少用到这种换算所以提下。

知识点二:分辨率

分辨率是对屏幕来说的,比如1920*1080,意指一个屏幕x方向有1920个像素,纵向有1080个像素,一个像素就是一个四方块的点。

这个概念程序员一般比较了解。

有了这两个知识,下面开始实验

逻辑坐标

有很多问题,我们不理解,是因为没有一个明确的数字验证它。书本是这么说的,GDI函数是用的逻辑坐标。如果我们能用数据实证这个说法,

那么很多不解就解开了。

根据《windows程序设计》的说法,我们在作图时,还有映射模式的概念,这一段一般比较好理解,就是把映射模式修改下。比如:

SetMapMode(hdc,MM_LOMETRIC); //设置映射模式

如果不修改就是MM_TEXT,也就是以象素为单位。然而一旦映射模式改变,逻辑坐标就随之改变

比如:LineTo(hdc,254,0);

这句代码,请问这个254是多少?这就是书本提到的逻辑坐标,它是多少取决于映射模式是什么,两者是绑定的,我们一查书可知,MM_LOMETRIC模式下是以

0.1mm为单位的,那么254的结果就是25.4mm,也就是一英寸

现在的问题转化为,一英寸在屏幕中有多少象素?

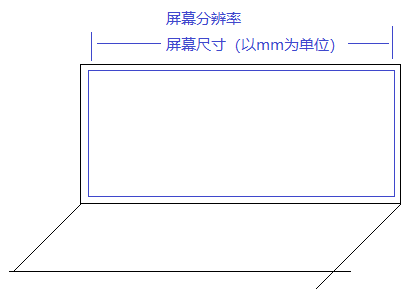

下面解决这个问题,为了更形象,这里画个笔记本图示:

我们看到,对于笔记本屏幕的X方向来说,屏幕尺寸是固定的,就好比你买了一个15寸的本子,宽不会变。但是分辨率是可变的,比如

有时会将1920*1080调整为1600*900.

我们回到问题,计算一英寸在屏幕中的像素数。由于屏幕尺寸是mm为单位的,如果得到这个尺寸就可以计算得到屏幕是多少英寸的。

如图所示,1mm=0.0393700787英寸

得到英寸数之后,我们又可以通过系统函数得到分辨率,然后用分辨率/英寸数就可以得到一英寸占用多少像素

代码如下:

int pixelX=GetDeviceCaps(hdc,HORZRES); //水平分辨率

int phsX=GetDeviceCaps(hdc,HORZSIZE); //水平尺寸,单位MM

float dpiX=pixelX / (phsX*0.0393700..)

其中dpiX就是结果,有了这个我们就可以验证。

MoveToEx(hdc,0,0,NULL);

LineTo(hdc,254,0);

这句代码中的254由于是逻辑单位,而当前又是MM_LOMETRIC,所以它实际是25.4MM,也即是一英寸。

那么画出来的线被转化为设备坐标时,所占的像素数就是我们上面的dpiX的值。

如图所示,118.139...即是计算的DPIX值,下面是实际的线长,

我们把它截图并用尺量一下,发现确实是118像素左右。

从计算公式可以看出,屏幕的分辨率越大,DPIX的值就越大,也即线段(像素)就越长。

将分辨率从1600*900调整为1920*1080,结果如下:

依然拿尺测量一下,确实是141像素左右

这一步证明了书本的大部分说明,真正从数据出发说明了什么是逻辑坐标,设备坐标以及映射模式

2022-4-21 夜