1 standalone模式

1.1 安装

解压缩 flink-1.7.0-bin-hadoop27-scala_2.11.tgz

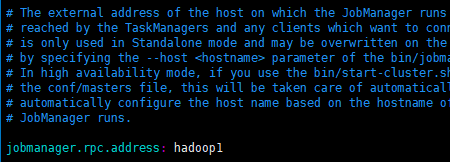

修改 flink/conf/flink-conf.yaml 文件

修改 /conf/slave文件

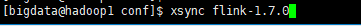

分发给 另外两台机子

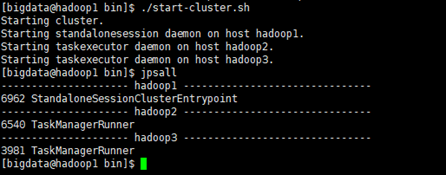

启动

1.2 提交任务

1) 准备数据文件

2) 把含数据文件的文件夹,分发到taskmanage 机器中

由于读取数据是从本地磁盘读取,实际任务会被分发到taskmanage的机器中,所以要把目标文件分发。

3) 执行程序

./flink run -c com.atguigu.flink.app.BatchWcApp /ext/flink0503-1.0-SNAPSHOT.jar --input /applog/flink/input.txt --output /applog/flink/output.csv

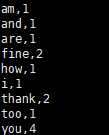

4) 到目标文件夹中查看计算结果

注意:计算结果根据会保存到taskmanage的机器下,不会再jobmanage下。

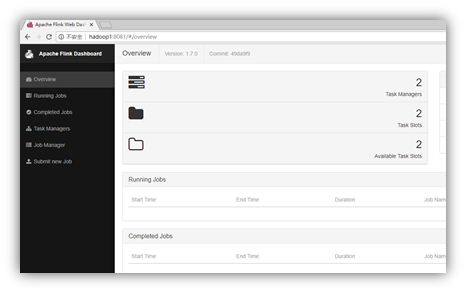

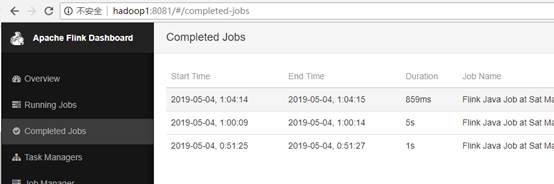

5) 在webui控制台查看计算过程

2 yarn模式

1) 启动hadoop集群

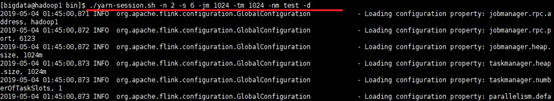

2) 启动yarn-session

./yarn-session.sh -n 2 -s 2 -jm 1024 -tm 1024 -nm test -d

其中:

-n(--container):TaskManager的数量。

-s(--slots): 每个TaskManager的slot数量,默认一个slot一个core,默认每个taskmanager的slot的个数为1,有时可以多一些taskmanager,做冗余。

-jm:JobManager的内存(单位MB)。

-tm:每个taskmanager的内存(单位MB)。

-nm:yarn 的appName(现在yarn的ui上的名字)。

-d:后台执行。

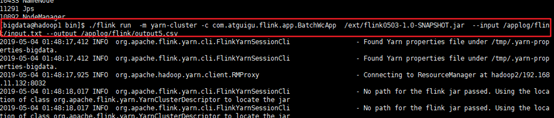

3) 执行任务

./flink run -m yarn-cluster -c com.atguigu.flink.app.BatchWcApp /ext/flink0503-1.0-SNAPSHOT.jar --input /applog/flink/input.txt --output /applog/flink/output5.csv

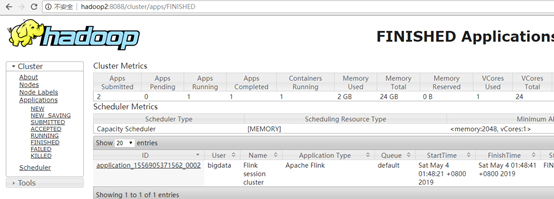

4) 去yarn控制台查看任务状态