《Spark快速大数据分析》笔记

from pyspark import SparkConf, SparkContext

conf = SparkConf().setMaster("local").setAppName("My App")

sc = SparkContext(conf = conf)

pyspark的初始化,也就是入口,setMaster是指定连接的集群,setAppName是指应用名

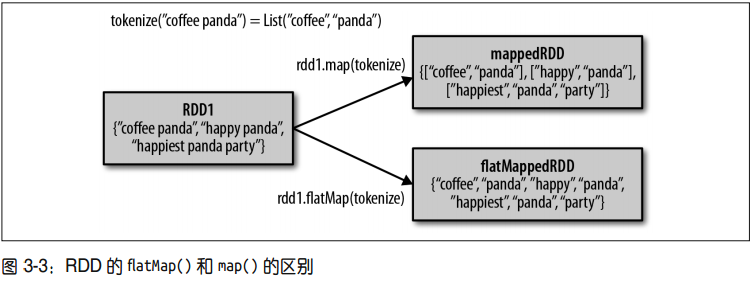

有时候,我们希望对每个输入元素生成多个输出元素。实现该功能的操作叫作 flatMap()。

和 map() 类似,我们提供给 flatMap() 的函数被分别应用到了输入 RDD 的每个元素上。不

过返回的不是一个元素, 而是一个返回值序列的迭代器。

我们在图 3-3 中阐释了 flatMap() 和 map() 的区别。你可以把 flatMap() 看作将返回的迭代器

“拍扁”,这样就得到了一个由各列表中的元素组成的 RDD,而不是一个由列表组成的 RDD。

图 3-3: RDD 的 flatMap() 和 map() 的区别

这一段没看懂: