前言

以下内容是个人学习之后的感悟,转载请注明出处~

softmax回归

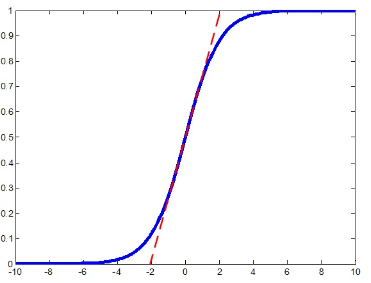

首先,我们看一下sigmod激活函数,如下图,它经常用于逻辑回归,将一个real value映射到(0,1)的区间(当然也可以是

(-1,1)),这样可以用来做二分类。

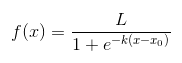

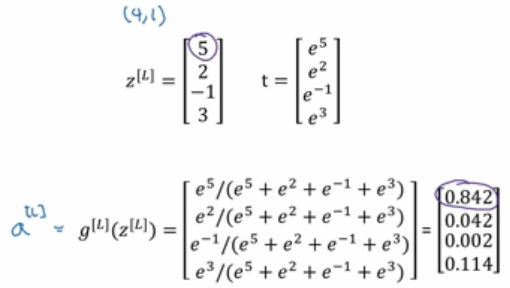

接下来,我们再看一下softmax函数,其函数类型如下:

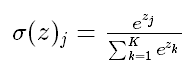

那么,softmax又是怎么实现的呢?softmax把一个k维的real value向量(a1,a2,a3,a4….)映射成一个(b1,b2,b3,b4….)

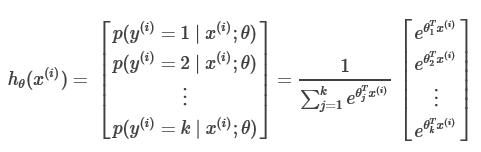

其中bi是一个0-1的常数,然后可以根据bi的大小来进行多分类的任务,如取概率最大的一维。具体实现如下图:

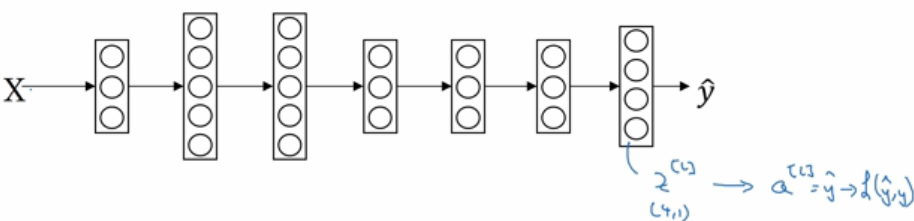

无非是把神经网络最后一层的激活函数替换为softmax函数,算出概率值最大的那一类即正确类。

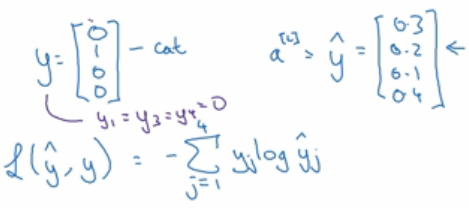

其代价函数为L(ý,y)= - ∑ yj * log( ýj ) 。

实例如下图所示,当代价函数最小时,那一个正确分类的概率输出值最大。

以上是全部内容,如果有什么地方不对,请在下面留言,谢谢~