Environment:{

三台服务器均安装 kafka zookeeper

filebeat

logstash

kibana

}

一、首先安装zookeeper,kafka,让机器有 leader 和 follower

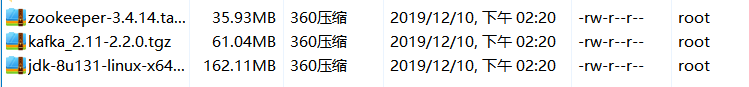

1、首先准备环境(jdk)(三台机器均执行此步骤)

rpm -ivh jdk-8u131-linux-x64_.rpm

移动压缩包

mv kafka_2.11-2.2.0.tgz /usr/local/src/ mv zookeeper-3.4.14.tar.gz /usr/local/src/

进入src目录解压压缩包并移动到/usr/local

cd /usr/local/src/ tar -zxvf kafka_2.11-2.2.0.tgz tar -zxvf zookeeper-3.4.14.tar.gz

将kafka包和zookeeper包移动到/usr/local/目录下

mv kafka_2.11-2.2.0 /usr/local/kafka mv zookeeper-3.4.14 /usr/local/zookeeper cd /usr/local/zookeeper/

创建两个文件夹,用以放置zookeeper的日志或数据 mkdir {zkdata,zkdatalog}

此步骤不为关键:用md5查看kafka和zookeeper是否安装

md5sum /usr/local/src/kafka_2.11-2.2.0.tgz md5sum /usr/local/src/zookeeper-3.4.14.tar.gz

进入配置文件,并拷贝新文件夹,编辑配置文件

cd conf/ cp zoo_sample.cfg zoo.cfg 编辑zoo.cfg文件 vim zoo.cfg

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/usr/local/zookeeper/zkdata #修改此文件路径,上一步创建的zkdata文件夹

dataLogDir=/usr/local/zookeeper/zkdatalog #添加数据日志的文件夹

clientPort=2181

server.1=192.168.189.172:2888:3888 #此步骤为三台虚拟机的ip以及端口

server.2=192.168.189.139:2888:3888

server.3=192.168.189.128:2888:3888

三台机器桉步骤依次填入序号

echo '1' > /usr/local/zookeeper/zkdata/myid echo '2' > /usr/local/zookeeper/zkdata/myid echo '3' > /usr/local/zookeeper/zkdata/myid cat /usr/local/zookeeperzkdata/myid 查看各个机器的id值

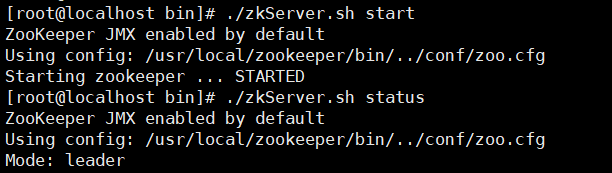

三台机器配置文件操作完成,下面进入启动程序

cd /usr/local/zookeeper/bin/ ./zkServer.sh start

启动完成后可以查看本机的身份(关闭防火墙)

./zkServer.sh status

注意,机器连通需要关闭相关防火墙

效果如下: 此处有一个leader 和 两个 follower

启动kafka

cd /usr/local/kafka/bin/config vim server.properties

eg:三台机器各自安配id ,kafka01、2、3:9092

broker.id=3 advertised.listeners=PLAINTEXT://kafka03:9092 zookeeper.connect=192.168.189.172:2181,192.168.189.139:2181,192.168.189.128:2181

vim /etc/hosts #尾部添加主机三台机器均执行此步骤 192.168.189.172 kafka01 192.168.189.139 kafka02 192.168.189.128 kafka03

进入目录开启kafka服务

cd /usr/local/kafka/bin/

./kafka-server-start.sh -daemon ../config/server.properties

查看是否有9092端口,有代表服务开启

创建主题端口

cd /usr/local/kafka/bin/ ./kafka-server-start.sh ./kafka-server-start.sh -daemon ../config/server.properties ./kafka-topics.sh --create --zookeeper 192.168.189.128:2181 --replication-factor 2 --partitions 3 --topic wg007 ./kafka-topics.sh --list --zookeeper 192.168.189.128:2181 #查看创建的主题名称

创建虚拟用户下单以及接单(简明来说:一台机器输入,另一台机器可显示其输入的内容)

./kafka-console-producer.sh --broker-list 192.168.189.128:9092 --topic wg007

第二台机器连接第一台机器,用以查看第一台机器输入的内容

/usr/local/kafka/bin/kafka-console-consumer.sh --bootstrap-server 192.168.189.172:9092 --topic logstash --from-beginning

二、filebeat端 web界面显示的服务(filebeat)

1、编辑filebeat的yum源

vim /etc/yum.repos.d/filebeat.repo yum -y install filebeat

yum源配置文件如下

[filebeat-6.x] name=Elasticsearch repository for 6.x packages baseurl=https://artifacts.elastic.co/packages/6.x/yum gpgcheck=1 gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch enabled=1 autorefresh=1 type=rpm-md

下载完配置此filebeat的配置文件

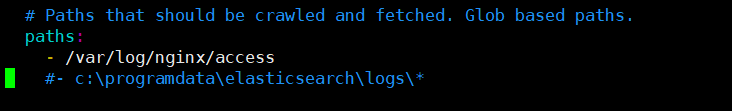

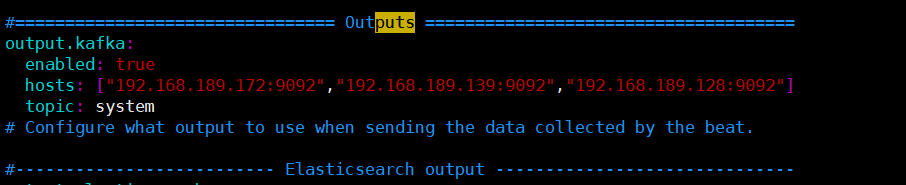

vim /etc/filebeat/filebeat.yml

此步骤为要监控的服务的日志,本机器监控nginx