回到随机变量传输问题,假设传输中我们不知道具体

分布情况(unknown),我们用一个已知的分布

,来模拟它,那么在这种情况下如果我们利用

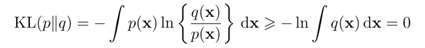

尽可能高效的编码,那么我们平均需要多少额外的信息量来描述x呢。这称为相对熵,或者kl divergence。

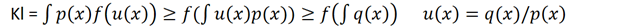

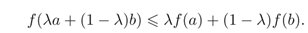

利用凸函数的不等式性质(也利用了离散求和推广到连续积分)可以证明

因此KL表征了两个分布之间的关系,a measure of dissimilariy of p and q表示两个分布不相同的程度

来自 <http://www.cnblogs.com/rocketfan/archive/2010/09/24/1833839.html>

如何证明 >= 0

f(x) = x^2

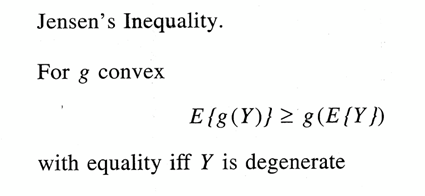

概率论的版本 [编辑]

以概率论的名词,

是个概率测度。函数

换作实值随机变量

(就纯数学而言,两者没有分别)。在

空间上,任何函数相对于概率测度

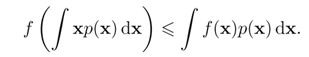

的积分就成了期望值。这不等式就说,若

是任一凸函数,则

。

来自 <http://zh.wikipedia.org/zh-cn/%E5%BB%B6%E6%A3%AE%E4%B8%8D%E7%AD%89%E5%BC%8F>

Prml f1.31

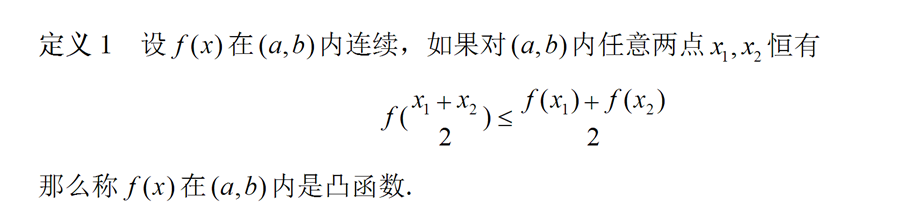

Convex 也就是说二阶导数全为正

相反的情况是 Concave

f(x) convext -f(x) concave

kl的证明如下

Ln 是一个concave函数 -ln 是一个convex函数

对于convex函数

f(E(u(x)) <= E(f(u(x)) ?