大家好 我是阿喵

今天教大家用如何用爬虫爬取可爱小姐姐的美照

第一步:现将python环境搭建好,工欲利其事必先利其器!

第二步:寻找目标网站,我选择的网站是http://www.win4000.com,里面有一个美女板块,里面有各种小姐姐的照片(你懂的)

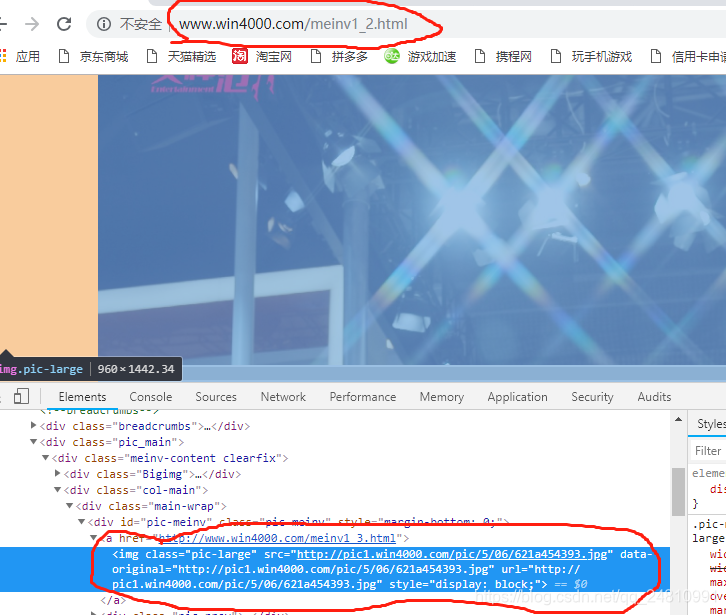

第三步:分析目标网站的html源码及网页规则

通过分析我发现,该网页每个人物的每个图片都是

http://www.win4000.com/meinv1_2.html

http://www.win4000.com/meinv1_3.html

http://www.win4000.com/meinv2_1.html

http://www.win4000.com/meinv2_2.html

并且所有图片地址都存放在一个中

哈哈哈哈大功告成,以下是成果展示

总结:

1、该方式爬取为单进程爬取,只能一张一张爬取

2、进行图片请求时一定要注意不要使用之前使用过的变量

3、细心、认真、不浮躁

看完文章如果大家觉得有帮助,记得一键三连哦,非常感谢,在这里还是要推荐下我自己建的Python学习群:609616831,群里都是学Python的,如果你想学或者正在学习Python ,欢迎你加入,大家都是软件开发党,不定期分享干货(只有Python软件开发相关的),包括我自己整理的一份2020最新的Python进阶资料和零基础教学,欢迎进阶中和对Python感兴趣的小伙伴加入!