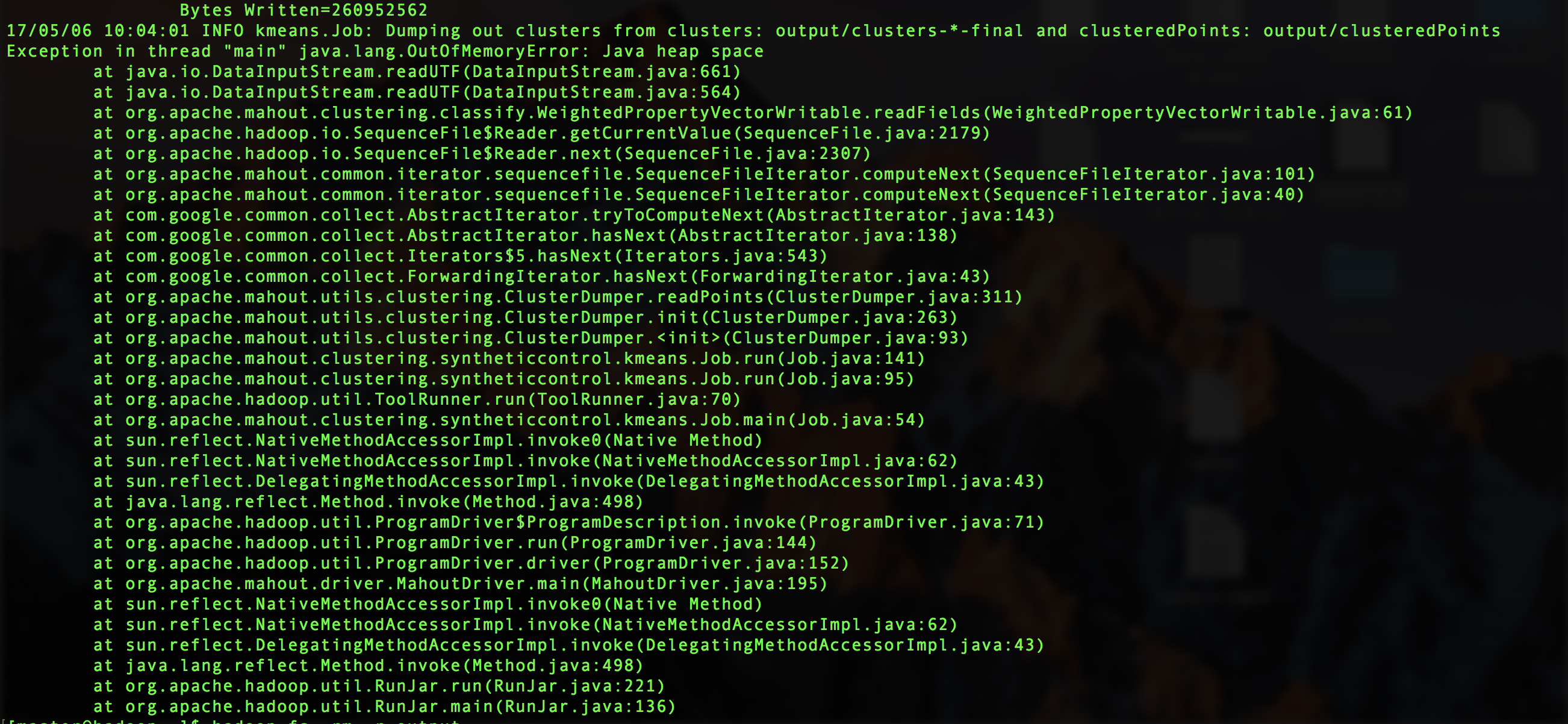

最近在做hadoop上面的东西,今天跑一个kmeans算法,数据量是200W,运行到最后报错了,

最后在网上找到了答案,原来是hadoop配置的堆的空间太小,解决方法是在haoop-env.sh中加以修改

原本的配置是:

export HADOOP_CLIENT_OPTS="-Xmx128m $HADOOP_CLIENT_OPTS"

修改128为2048即可

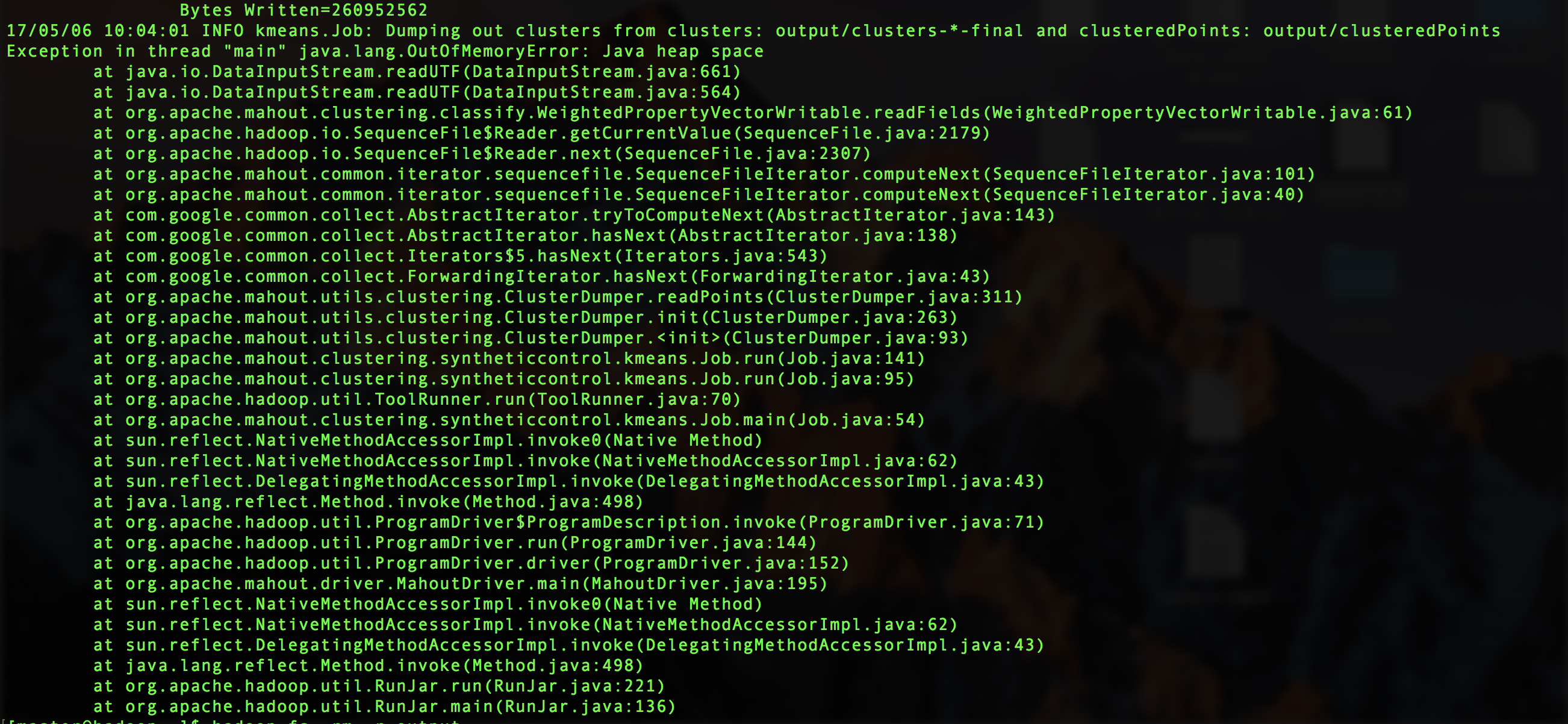

最近在做hadoop上面的东西,今天跑一个kmeans算法,数据量是200W,运行到最后报错了,

最后在网上找到了答案,原来是hadoop配置的堆的空间太小,解决方法是在haoop-env.sh中加以修改

原本的配置是:

export HADOOP_CLIENT_OPTS="-Xmx128m $HADOOP_CLIENT_OPTS"

修改128为2048即可