本文讲述在CentOS 6.5中提交作业到hadoop 1.2.1于reduce阶段遇到Error: java heap space错误导致作业重新计算的解决过程。解决办法适用Linux、Mac OS X 和Windows操作系统。

环境:Mac OS X 10.9.5, IntelliJ IDEA 13.1.4, Hadoop 1.2.1

Hadoop放在虚拟机中,宿主机通过SSH连接,IDE和数据文件在宿主机。IDEA自身运行于JDK 1.8,IDEA工程及Hadoop使用JDK 1.6。

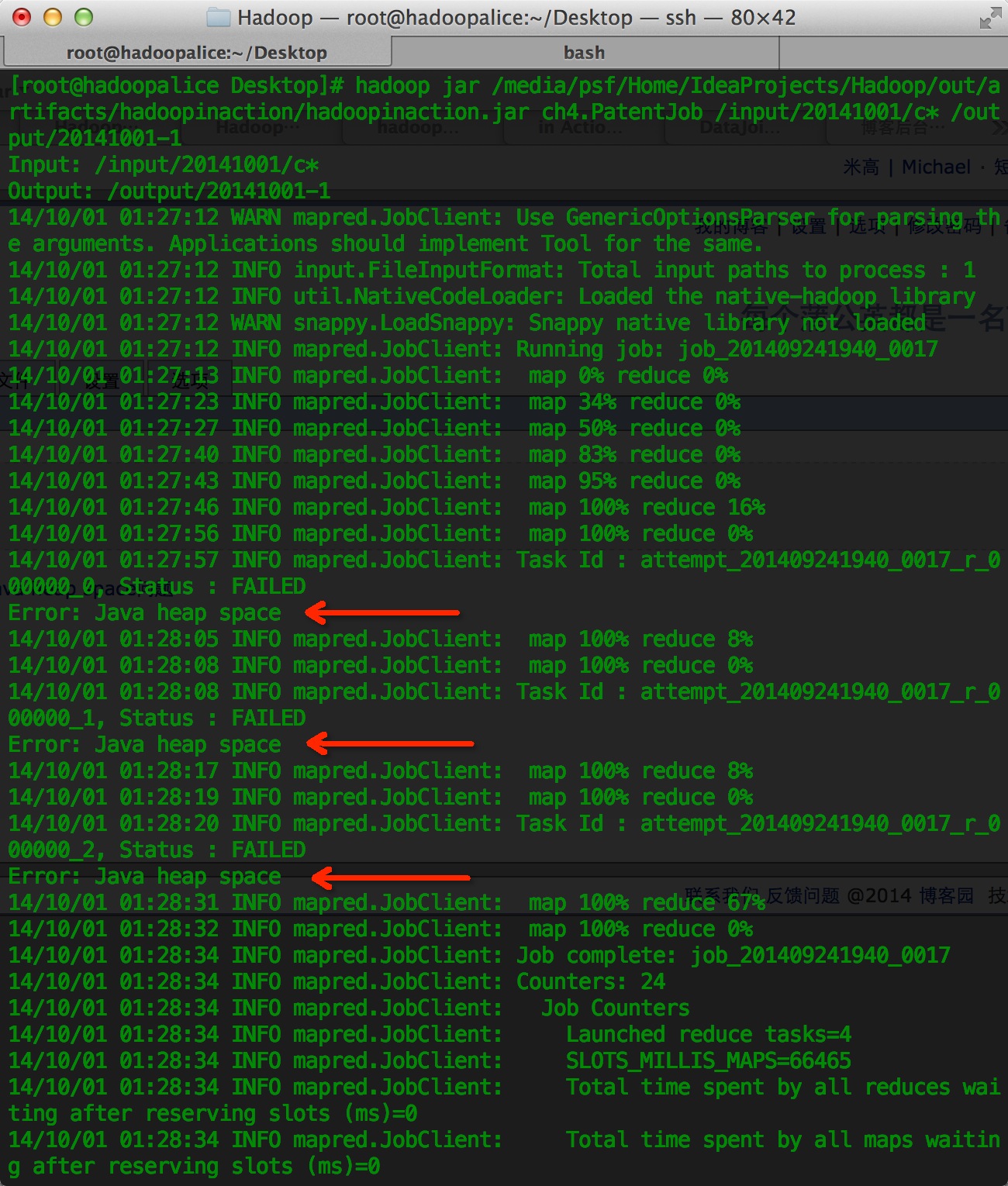

在处理Hadoop In Action第4章所引用的专利数据时,遇到了jvm堆空间不足问题,如下图所示。

看来是java虚拟机堆内存过小导致的。按如下方式设置即可解决[1]。

方式一,临时处理,每次提交任务前,执行语句 export HADOOP_OPTS=[大小],如将JVM堆大小设置成4G大小,export HADOOP_OPTS= "-Xmx4096m" 再执行hadoop命令。

方式二,永久处理,配置hadoop目录下conf目录中的mapred-site.xml文件,加上如下内容,并重启hadoop以生效。

1 <property> 2 <name>mapred.child.java.opts</name> 3 <value>-Xmx4096m</value> 4 </property>

说明,堆的设置一般从较小值尝试,逐步增大,当不再出现java heap space提示时即可。32位系统,一般限制在1.5G~2G;64位操作系统对内存无限制。

有关JVM调优信息,可参考JVM调优总结 -Xms -Xmx -Xmn -Xss。

参考

[1]http://stackoverflow.com/questions/15609909/error-java-heap-space