Docker网络

理解Docker网络-Docker0

问题:docker 是如何处理容器网路访问的?例如tomcat容器是怎么访问mysql容器的

测试

# 跑一个tomcat

[root@VM-0-13-centos ~]# docker run -d -P --name tomcat01 tomcat

# 查看容器的内部网络地址 ip addr,发现容器启动的时候会得到一个 eth0@if7 ip地址,docker分配的

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

6: eth0@if7: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default

link/ether 02:42:ac:12:00:02 brd ff:ff:ff:ff:ff:ff link-netnsid 0

inet 172.18.0.2/16 brd 172.18.255.255 scope global eth0

valid_lft forever preferred_lft forever

# 思考,Linux 能不能 ping 通容器内部,可以看到Linux可以ping通docker容器内部

[root@VM-0-13-centos ~]# ping 172.18.0.2

PING 172.18.0.2 (172.18.0.2) 56(84) bytes of data.

64 bytes from 172.18.0.2: icmp_seq=1 ttl=64 time=0.062 ms

原理

- 我们启动一个docker容器,docker服务就会给docker容器分配一个ip,我们只要安装了docker,就会有一个网卡 docker0,使用的桥接模式,使用的技术是

evth-pair

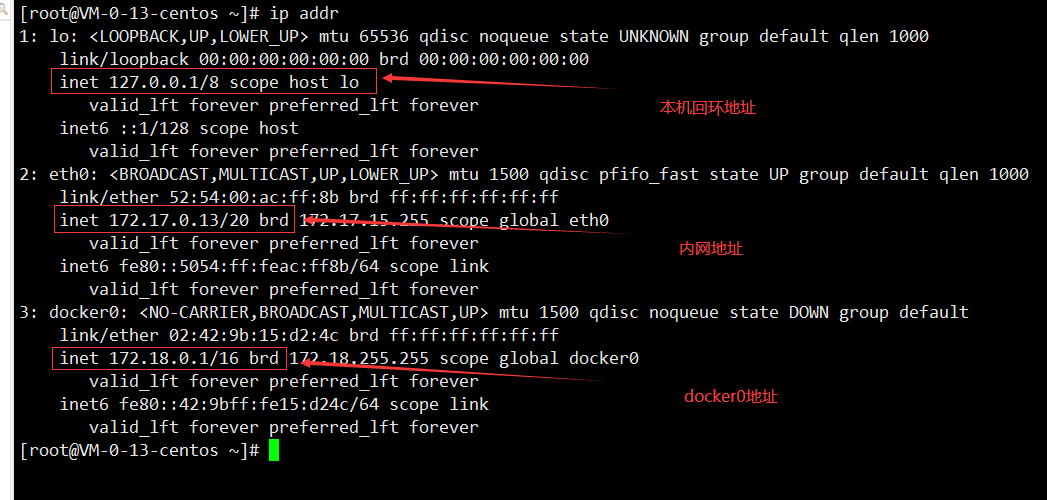

再次测试 ip addr,又多了一个网卡

[root@VM-0-13-centos ~]# ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: eth0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000

link/ether 52:54:00:ac:ff:8b brd ff:ff:ff:ff:ff:ff

inet 172.17.0.13/20 brd 172.17.15.255 scope global eth0

valid_lft forever preferred_lft forever

inet6 fe80::5054:ff:feac:ff8b/64 scope link

valid_lft forever preferred_lft forever

3: docker0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default

link/ether 02:42:9b:15:d2:4c brd ff:ff:ff:ff:ff:ff

inet 172.18.0.1/16 brd 172.18.255.255 scope global docker0

valid_lft forever preferred_lft forever

inet6 fe80::42:9bff:fe15:d24c/64 scope link

valid_lft forever preferred_lft forever

7: vethd5cb04e@if6: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue master docker0 state UP group default

link/ether 86:da:2a:3e:d8:63 brd ff:ff:ff:ff:ff:ff link-netnsid 0

inet6 fe80::84da:2aff:fe3e:d863/64 scope link

valid_lft forever preferred_lft forever

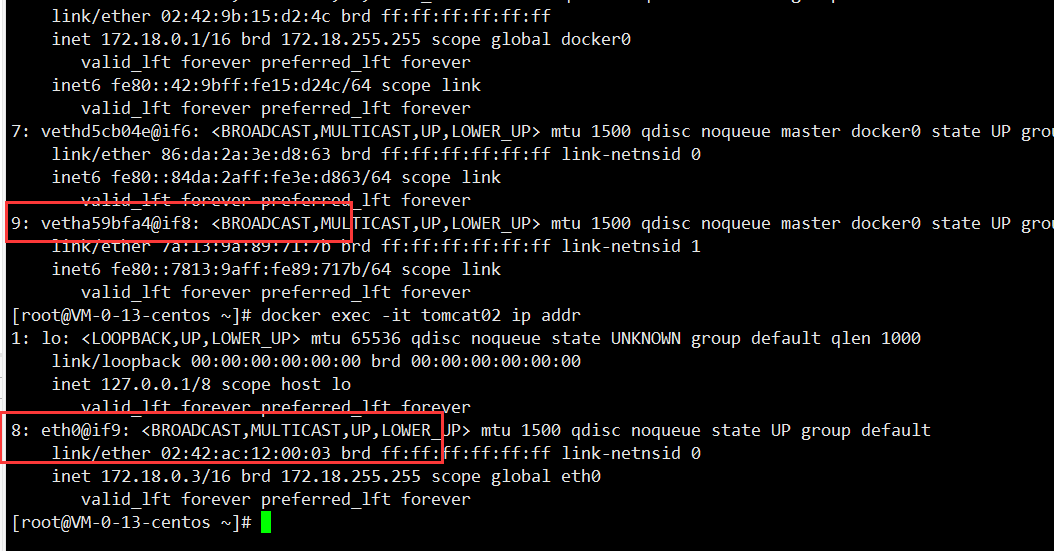

- 再启动一个容器测试,发现又多了一对网卡

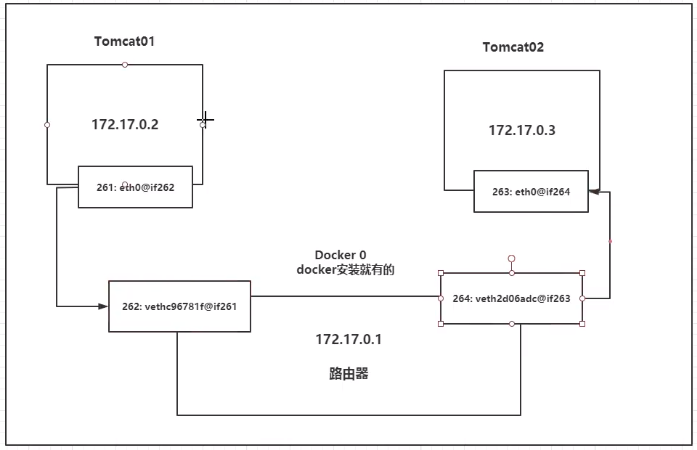

我们发现这个容器带来的网卡,都是一对出现的,这是evth-pair带来的,evth-pair就是一对的虚拟设备接口,他们都是成对出现的,一段练市协议,一段彼此相连。正因为这个特性,evth-pair充当一个桥梁,连接各种虚拟网络设备。 OpenStack,Docker容器之间的连接,OVS的连接,都是使用evth-pair

- 测试两个tomcat容器之间的网络连通,可以发现ping通了。因此容器和容器之间是可以互相ping通的

[root@VM-0-13-centos ~]# docker exec -it tomcat01 ping 172.18.0.3

PING 172.18.0.3 (172.18.0.3) 56(84) bytes of data.

64 bytes from 172.18.0.3: icmp_seq=1 ttl=64 time=0.090 ms

容器互通的原理

结论:tomcat01和tomcat02是共用一个路由器 docker0。

所有的容器不指定网络的情况下都是docker02路由的,docker会给我们的容器分配一个默认的可用IP

小结

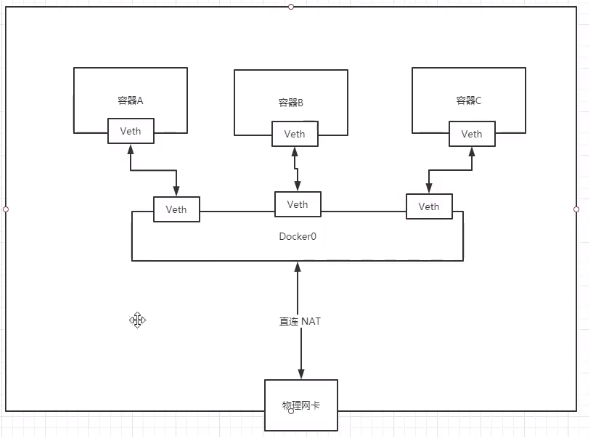

Docker使用的是Linux桥接技术,宿主机中的一个Docker容器的网桥 docker0

Docker中的所有的网络接口都是虚拟的,虚拟的转发效率高

容器删除,对应的网桥就没了

容器互联 --link

思考:我们编写的微服务,database url = ip:,项目不重启,数据库ip换掉了,我们希望可以处理这个问题,可以名字来进行访问容器?

[root@VM-0-13-centos ~]# docker exec -it tomcat01 ping tomcat02

ping: tomcat02: Name or service not known

我们直接使用名字是无法ping通的。如何解决这个问题呢

使用 --link 可以解决这个问题

[root@VM-0-13-centos ~]# docker run -d -P --name tomcat03 --link tomcat02 tomcat

f6204926a2f53927d5f34e1149385faa5f166afa336cd7e63022c9675d2beaa5

[root@VM-0-13-centos ~]# docker exec -it tomcat03 ping tomcat02

PING tomcat02 (172.18.0.3) 56(84) bytes of data.

64 bytes from tomcat02 (172.18.0.3): icmp_seq=1 ttl=64 time=0.080 ms

本质:使用--link相当于在本机的hosts文件下做了ip和主机名的映射,但是目前并不推荐使用这种方式

自定义网络

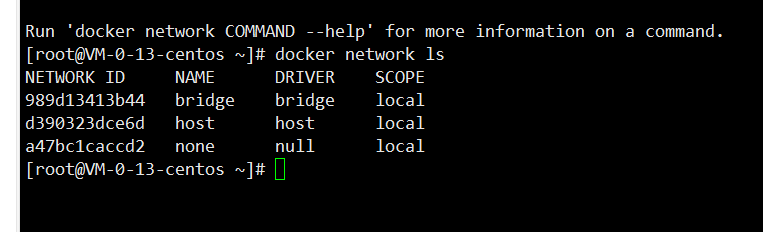

查看所有的docker网络

网络模式:

- bridge:桥接 docker(默认)

- none:不配置网络

- host:和宿主机共享网络

- container:网络内网络连通(用得少)

测试

# 我们直接启动的命令会默认带 --net bridge这个参数的,而这个就是我们的docker0

docker run -d -P --name tomcat01 --net bridge tomcat

# docker0特点:默认网络,主机名不能访问 --link可以打通

# 自定义网络

# --driver bridge

# --subnet 192.168.0.0/16

# --gateway 192.168.0.1

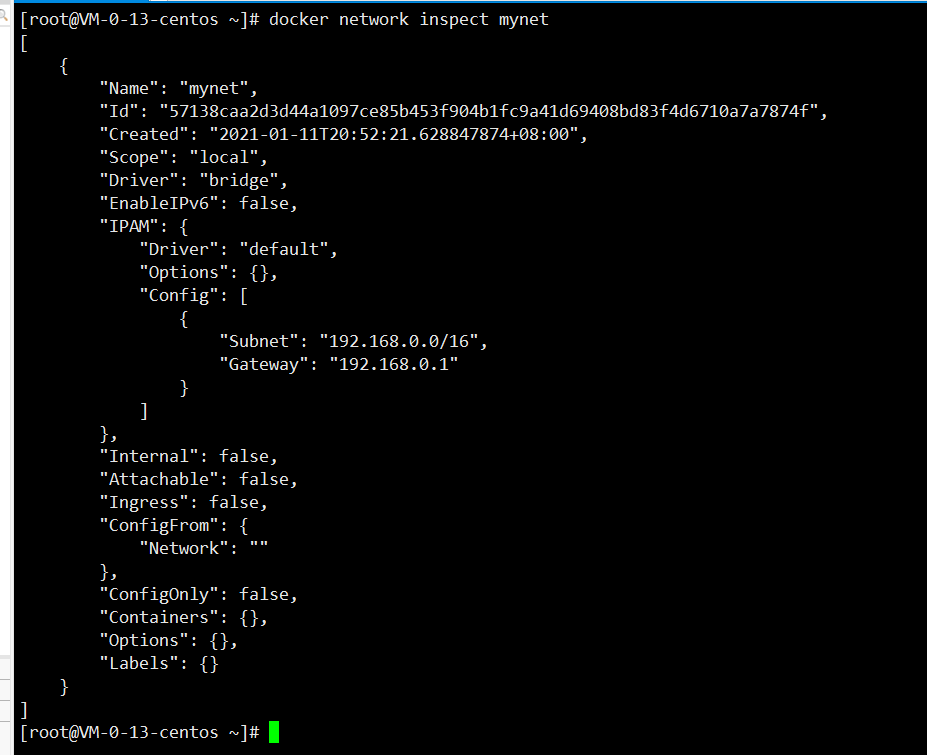

[root@VM-0-13-centos ~]# docker network create --driver bridge --subnet 192.168.0.0/16 --gateway 192.168.0.1 mynet

57138caa2d3d44a1097ce85b453f904b1fc9a41d69408bd83f4d6710a7a7874f

[root@VM-0-13-centos ~]# docker network ls

NETWORK ID NAME DRIVER SCOPE

989d13413b44 bridge bridge local

d390323dce6d host host local

57138caa2d3d mynet bridge local

a47bc1caccd2 none null local

[root@VM-0-13-centos ~]#

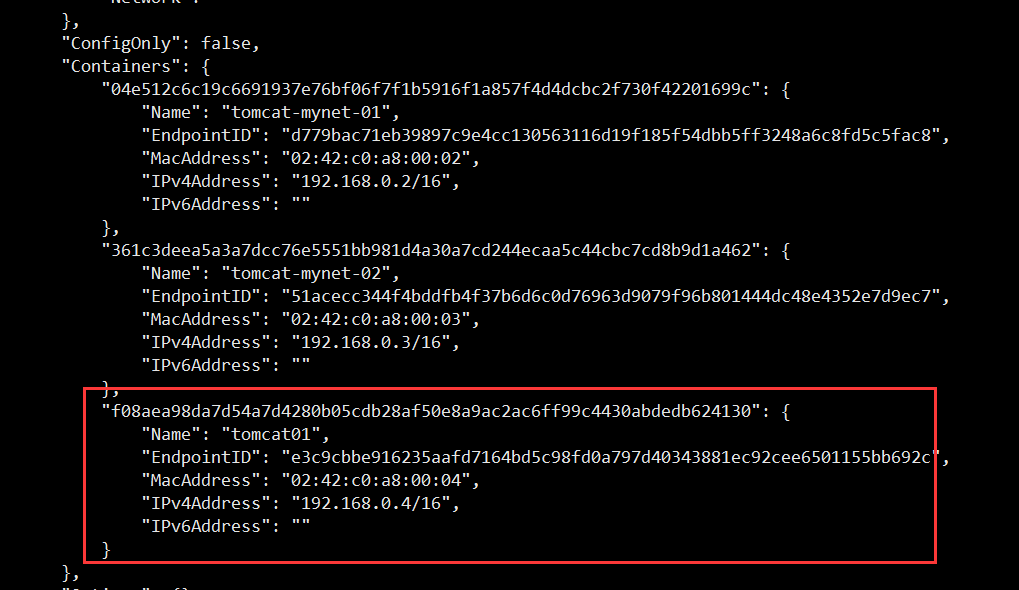

启动两个连接到自定义网络的容器

[root@VM-0-13-centos ~]# docker run -d -P --name tomcat-mynet-01 --net mynet tomcat

04e512c6c19c6691937e76bf06f7f1b5916f1a857f4d4dcbc2f730f42201699c

[root@VM-0-13-centos ~]# docker run -d -P --name tomcat-mynet-02 --net mynet tomcat

361c3deea5a3a7dcc76e5551bb981d4a30a7cd244ecaa5c44cbc7cd8b9d1a462

[root@VM-0-13-centos ~]# docker network inspect mynet

[

{

"Name": "mynet",

"Id": "57138caa2d3d44a1097ce85b453f904b1fc9a41d69408bd83f4d6710a7a7874f",

"Created": "2021-01-11T20:52:21.628847874+08:00",

"Scope": "local",

"Driver": "bridge",

"EnableIPv6": false,

"IPAM": {

"Driver": "default",

"Options": {},

"Config": [

{

"Subnet": "192.168.0.0/16",

"Gateway": "192.168.0.1"

}

]

},

"Internal": false,

"Attachable": false,

"Ingress": false,

"ConfigFrom": {

"Network": ""

},

"ConfigOnly": false,

"Containers": {

"04e512c6c19c6691937e76bf06f7f1b5916f1a857f4d4dcbc2f730f42201699c": {

"Name": "tomcat-mynet-01",

"EndpointID": "d779bac71eb39897c9e4cc130563116d19f185f54dbb5ff3248a6c8fd5c5fac8",

"MacAddress": "02:42:c0:a8:00:02",

"IPv4Address": "192.168.0.2/16",

"IPv6Address": ""

},

"361c3deea5a3a7dcc76e5551bb981d4a30a7cd244ecaa5c44cbc7cd8b9d1a462": {

"Name": "tomcat-mynet-02",

"EndpointID": "51acecc344f4bddfb4f37b6d6c0d76963d9079f96b801444dc48e4352e7d9ec7",

"MacAddress": "02:42:c0:a8:00:03",

"IPv4Address": "192.168.0.3/16",

"IPv6Address": ""

}

},

"Options": {},

"Labels": {}

}

]

测试两个容器互联,发现可以直接使用容器名字ping通

[root@VM-0-13-centos ~]# docker exec -it tomcat-mynet-01 ping tomcat-mynet-02

PING tomcat-mynet-02 (192.168.0.3) 56(84) bytes of data.

64 bytes from tomcat-mynet-02.mynet (192.168.0.3): icmp_seq=1 ttl=64 time=0.069 ms

64 bytes from tomcat-mynet-02.mynet (192.168.0.3): icmp_seq=2 ttl=64 time=0.058 ms

自定义的网络docker都已经维护好了对应的关系,推荐使用这样的自定义网络。

自定义网络的好处:

不同的集群使用不同的网络,保证集群是安全和健康的

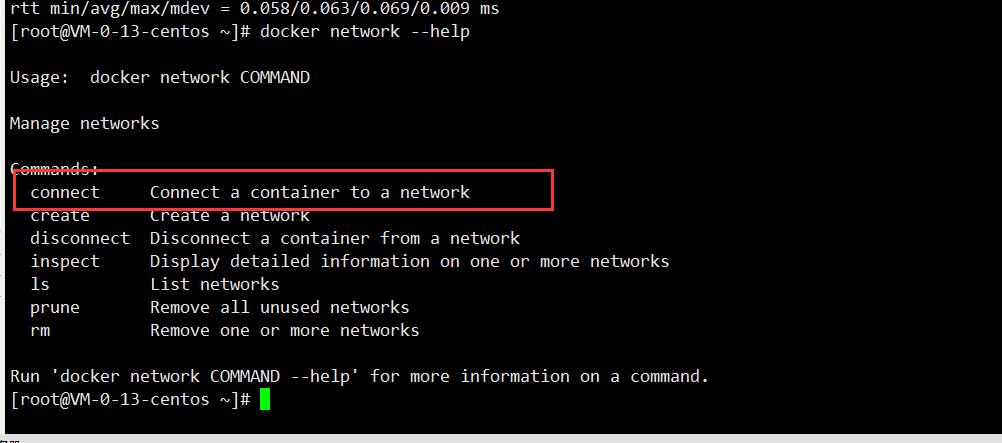

网络连通

测试打通不同网段的容器互通

[root@VM-0-13-centos ~]# docker network connect mynet tomcat01

连通之后,就是将容器加入到mynet,实现一个容器两个ip地址

结论:跨网络操作别人,就需要使用docker network connect 连通

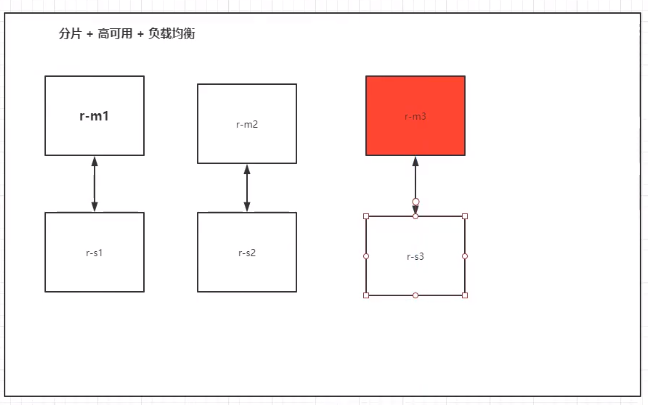

Redis集群部署实战

shell脚本

# 创建网卡

docker network create redis --subnet 172.38.0.0/16

# 通过脚本创建留个redis配置

for port in $(seq 1 6);

do

mkdir -p /mydata/redis/node-${port}/conf

touch /mydata/redis/node-${port}/conf/redis.conf

cat << EOF >>/mydata/redis/node-${port}/conf/redis.conf

port 6379

bind 0.0.0.0

cluster-enabled yes

cluster-config-file nodes.conf

cluster-node-timeout 5000

cluster-announce-ip 172.38.0.1${port}

cluster-announce-port 6379

cluster-announce-bus-port 16379

appendonly yes

EOF

done

docker run -p 637${port}:6379 -p 1637${port}:16379 --name redis-${port}

-v /mydata/redis/node-${port}/data:/data

-v /mydata/redis/node-${port}/conf/redis.conf:/etc/redis/redis.conf

-d --net redis --ip 172.38.0.1${port} redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf;

docker run -p 6371:6379 -p 16371:16379 --name redis-1

-v /mydata/redis/node-1/data:/data

-v /mydata/redis/node-1/conf/redis.conf:/etc/redis/redis.conf

-d --net redis --ip 172.38.0.11 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

docker run -p 6376:6379 -p 16376:16379 --name redis-6

-v /mydata/redis/node-6/data:/data

-v /mydata/redis/node-6/conf/redis.conf:/etc/redis/redis.conf

-d --net redis --ip 172.38.0.16 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

# 创建集群

redis-cli --cluster create 172.38.0.11:6379 172.38.0.12:6379 172.38.0.13:6379 172.38.0.14:6379 172.38.0.15:6379 172.38.0.16:6379 --cluster-replicas 1

# 测试

# 在一个redis中添加一个值,然后停掉这个容器,看集群能不能在或者这个值

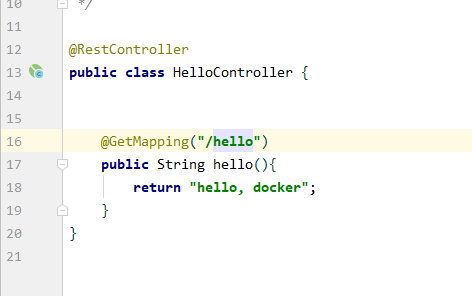

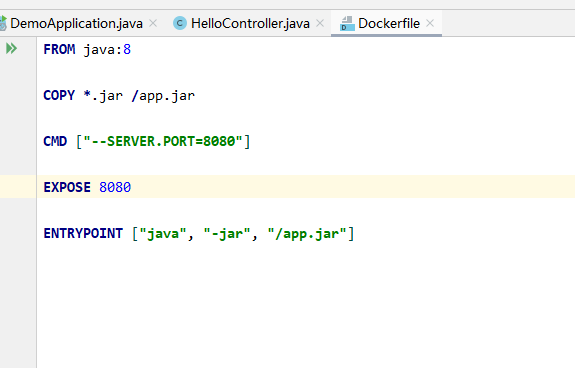

Springboot微服务打包Docker镜像

- 构建springboot项目

- 打包项目

- 编写dockerfile

- 构建镜像

- 发布项目

然后build构建镜像,跑起来就OK了