RL-Adventure: Policy Gradients

开源代码:https://github.com/higgsfield/RL-Adventure-2

自身实现:https://github.com/lucifer2859/Policy-Gradients

1、Advantage Actor Critic(A2C)& A3C

2、Soft Actor-Critic(SAC)(旧版),(新版)

- off-policy

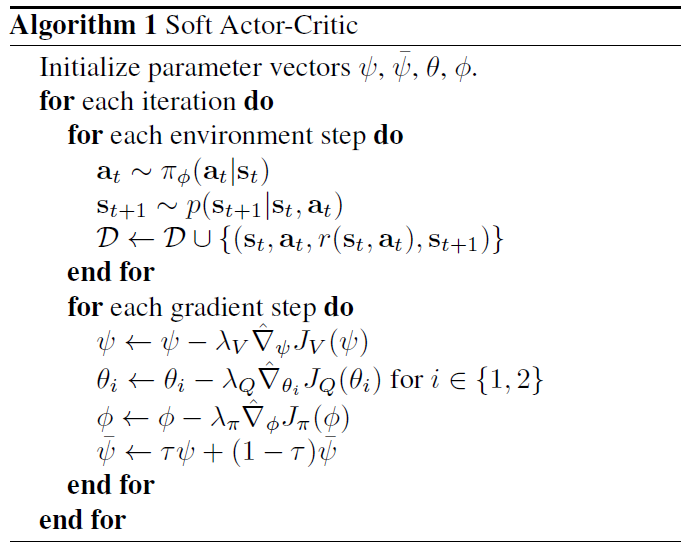

原始论文中伪代码有状态价值函数V:

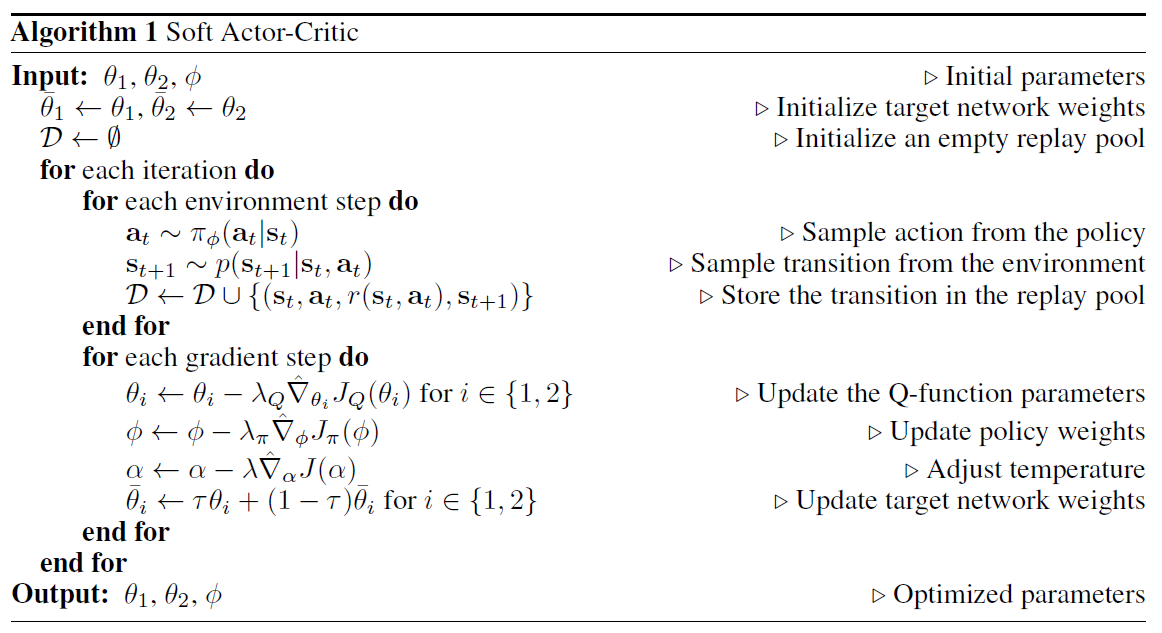

后续为什么没有了 函数?在初版的SAC中,作者表示同时维持两个值函数,可以使训练更加稳定,不过在第二版中,作者引入了自动调整温度系数

的方法,使得SAC更加稳定,于是就只保留了

函数。

3、Deep Deterministic Policy Gradient(DDPG)

- off-policy

4、Proximal Policy Optimization Algorithms(PPO)

- on-policy