某天突然ceph发出警告提示daemons have recently crashed,而且数目在不断增加,然并没有找到相关的错误目志。官方文挡有提示:一个或多个Ceph守护进程最近崩溃可能是软件或硬件(例如,磁盘故障)导致

解决办法

1、进入tool box容器

kubectl -n rook-ceph exec -it $(kubectl -n rook-ceph get pod -l "app=rook-ceph-tools" -o jsonpath='{.items[0].metadata.name}') bash

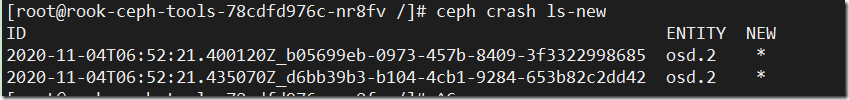

2、查询最新crashed信息

ceph crash ls-new

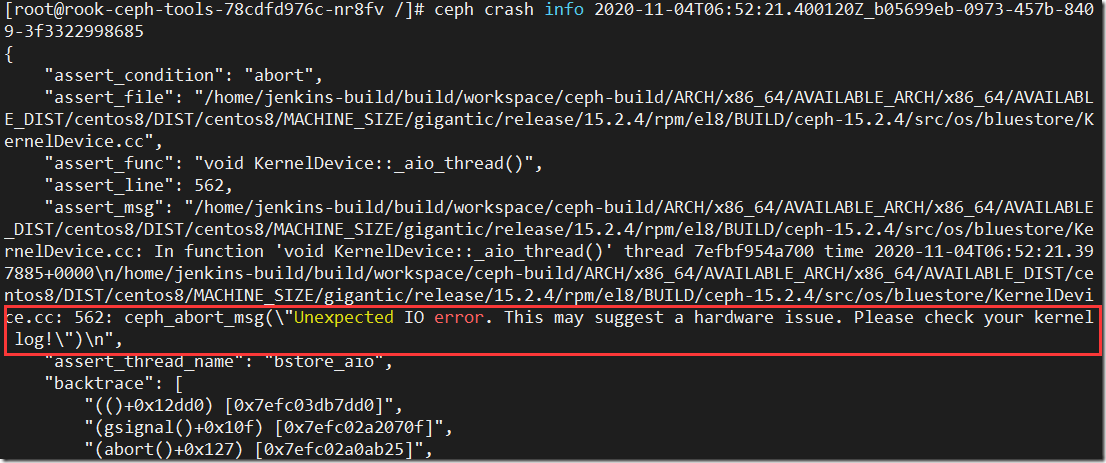

3、根据crash id查询异常详细

ceph crash info 2020-11-04T06:52:21.400120Z_b05699eb-0973-457b-8409-3f3322998685

已经可以看到错误信息了,但是只能通过kernel log查询问题了。

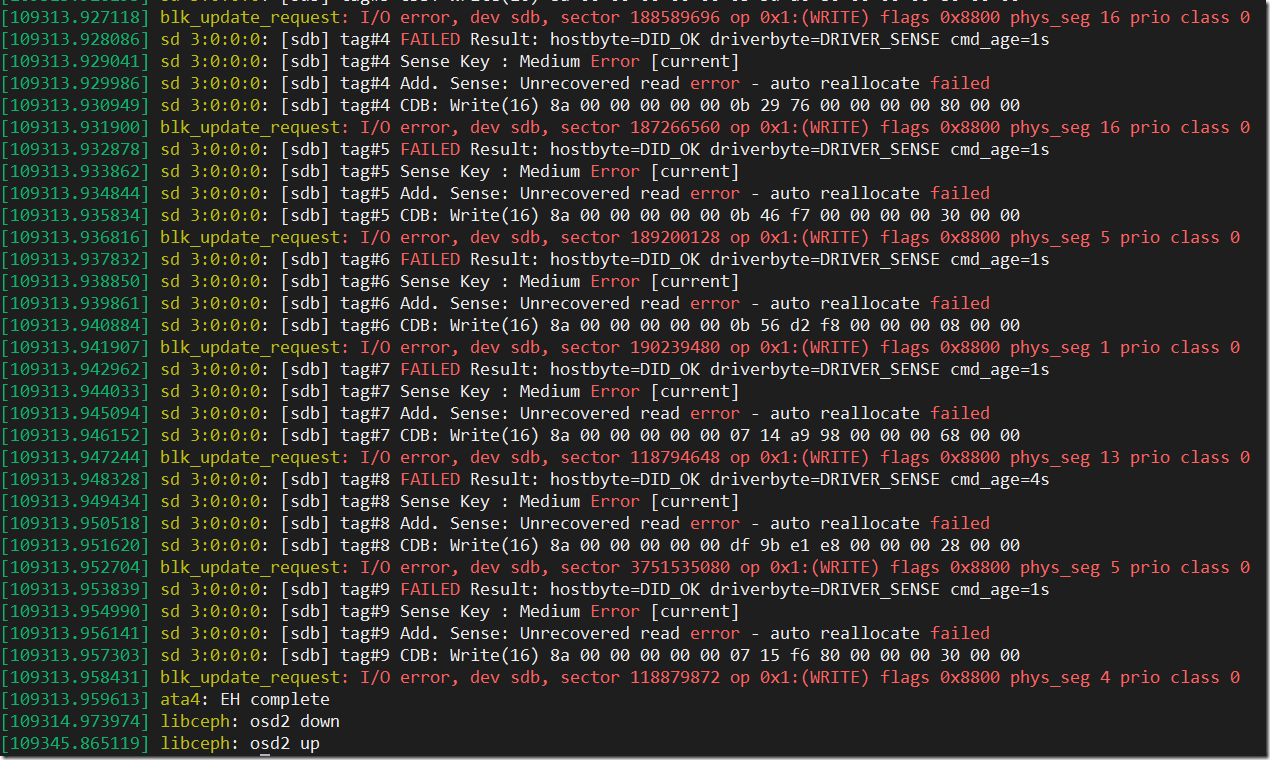

4、登录osd.2节点服务器,查询kernel log

dmesg

好吧,一堆飘红,基本上可以确认是硬盘问题了,做磁盘扫描坏道处理或换硬盘吧。

5、将crash清空,恢复ceph群集状态

#批量清除crash

ceph crash archive-all

#也可以根据id清除单个crash

ceph crash archive <crash-id>