(零)注意力模型(Attention Model)

1)本质:【选择重要的部分】,注意力权重的大小体现选择概率值,以非均匀的方式重点关注感兴趣的部分。

2)注意力机制已成为人工智能的一个重要概念,其在计算机视觉、自然语言处理等众多领域得到了广泛的研究和应用。

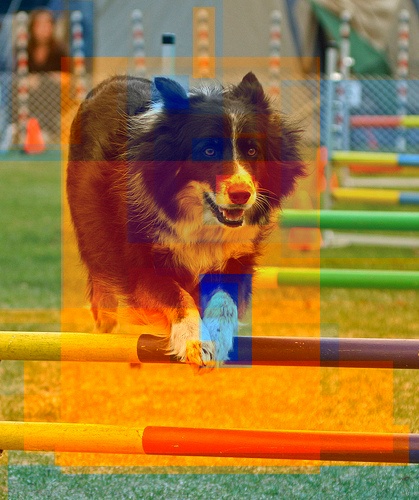

3)注意力机制模仿了生物观察行为的内部过程。例如,我们的视觉处理系统倾向于有选择地关注图像的某些部分,而忽略其他无关的信息,以一种有助于感知的方式(our visual processing system tends to focus selectively on some parts of the image, while ignoring other irrelevant information in a manner that can assist in perception.)如下图所示。 输入的某些部分比其他部分更重要,这种性质在大多数的任务中是通用和重要的,例如,在机器翻译和摘要任务(machine translation and summarization)中,只有输入序列中的特定单词可能与预测下一个单词有关。同样的,在视觉字幕(image captioning)中,输入图像中某些区域可能对于生成字幕中的下一个单词更重要。

4)注意力机制就是以上直觉的具体实现:整合相关的部分,从而允许模型动态地只关注输入的某些部分,从而有效地实现具体任务(allowing the model to dynamically pay attention to only certain parts of the input )。

5)了解了注意力的起因和作用后,下面分别介绍:(一)通用注意力模型,(二)不同类型的注意力模型分类,(三)不同架构的注意力模型。

(一)通用注意力模型(Generalized Attention Model)

通用的注意力模型包括两个输入:查询Query ($q$) 和内容Keys(表示为: $\bf{k}$$=k_1,$ $k_2,$ $\ldots,$ $k_n$),而注意力模型可以看做:相对于查询 $q$,将 $q$与一系列内容Keys 的相关性 $\bf{s}=\{s_i\}_{i=1}^{n}$(也称为对齐),映射为注意力分布 $\bf{\alpha}$$=\{ \alpha_i\}_{i=1}^{n}$ 的过程。注意力分布$\alpha_i$强调的是:相对于查询$q$,每个内容$k_i$与其的相关程度。

因此,关于两个输入 $q$ 和 $\bf{k}$,通用注意力的计算过程涉及到两个计算步骤:1)确定Query和Keys的相关性,即$s_i = s(q, k_i)$,其中$s(\cdot)$为对齐函数(Alignment function);2)将一系列相关程度映射为注意力分布$\bf{\alpha}=p(\bf{s})$,其中$p(\cdot)$为分布函数(Distribution function)。因此,注意力模型可以表示为:

s_1, s_2, \ldots,s_i

$k_1,$ $ k_2,$ $ \ldots,$ $ k_n$)

$s_i = s(q, k_i)$,

($\bf{\alpha}=p(\bf{s})$)