ABT日志入库记录

1.确认文件内容格式

文件内容有两种记录格式

格式一:(分流结果)

2018-07-03 06:50:00,142 [XNIO-2 task-28] INFO com.leeyk99.bi.abt.rest.CoreApiController - 1A42F7C6_B904_A334_AB87_5A69A7034DA0 PcRealClass 66 158

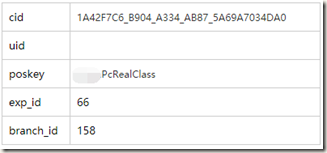

数据结构:

数据之间空格分隔,,cid、uid都可能为空。

格式二:(接口信息)

2018-07-03 20:39:46,043 [XNIO-2 task-211] INFO com.leeyk99.bi.abt.filter.LogFilter - GET /api/v1/bi/abt?cid=973EA838_E20E_74E4_41AB_E218DA91D73E&uid=&site=mtw&terminal=Leeyk99-M&lan=zh-tw took 1ms and returned 200

这个暂时不需要,故不入库。

2.入库建表语句及正则表达式

需要创建表记录分流结果。

表一:ABT-分流结果表(日)

--不能删表,否则日志文件就没了。 create table ods.ods_abt_exp_results_di( log_time string, abt_class string, client_id string, user_id string, poskey_id string, exp_id string, branch_id string ) partitioned by (dt string) row format serde 'org.apache.hadoop.hive.contrib.serde2.RegexSerDe' with serdeproperties ('input.regex'='([0-9\-\s:,]+)s*\[XNIO\-[0-9]+ task\-[0-9]+\]\sINFO\s*(.*) \- ([\w]*)\s([\w]*)\s([\w\-]*)\s([0-9]+) ([0-9]+)') stored as textfile;

(为什么不能删表,因为我们是通过指定文件位置来添加数据的,删表就删除文件了;如果是从本地文件系统Load进去的,可以直接删除重建;如果源文件是在HDFS或S3文件系统上,也不能轻易删表,因为load是移动文件。)

如果正则表达式不对,可以修改:

alter table ods.ods_abt_exp_results_di set serdeproperties ('input.regex'='([0-9\-\s:,]+)s*\[XNIO\-[0-9]+ task\-[0-9]+\]\sINFO\s*(.*) \- ([\w]*)\s([\w]*)\s([\w\-]*)\s([0-9]+) ([0-9]+)');

一般不会因为正则不表达式建表失败,如果失败,先执行:

add jar s3://dsdata01/bi/etl/udf/hive-contrib.jar;

3.日志文件入库

如果日志文件在集群存储系统外部,则需要Load进表或者使用创建外部表的方式。

ABT日志在AWS S3存储上,可以直接增加分区,指定到相应的位置。

该方法会导致表中有很多无用记录。(不符合正则的为NULL)

alter table ods.ods_abt_exp_results_di add partition (dt='20180702') location 's3://dsdata01/flume/abtcore/20180702';

如果这样操作后,就不能轻易drop表了,会导致数据丢失。

查看有效的数据:

add jar s3://dsdata01/bi_wh/etl/udf/hive-contrib.jar; select * from ods.ods_abt_exp_results_di a where dt='20180702' abt_class='com.leeyk99.bi.abt.rest.CoreApiController' limit 1;

该方法会导致表中有很多无用记录,不符合正则的为NULL。这是什么原因呢?

因为我们添加的目录位置中,文件中的内容包含两种,一个是分流结果,一个是接口请求信息,而我们配置的正则是分流结果的,因此接口请求信息在表里的数据就是NULL. 在实际开发中,我们可以在后续加一段代码过滤掉即可。

如果源文件是单独的,就不会出现这种情况啦。