在今天的学习中了解到Spark的一些东西在这里记录一下

应用前景:

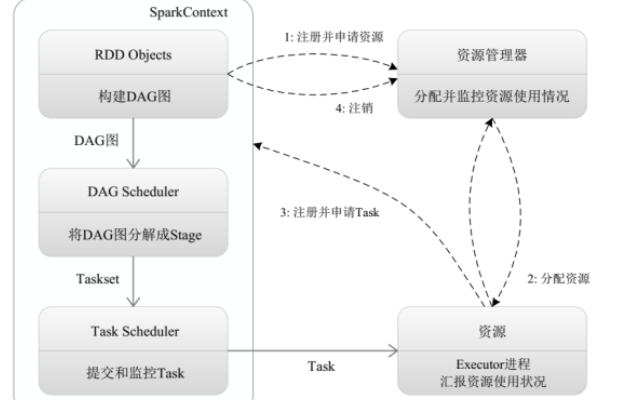

Spark流程:

还了解到一些名词:

RDD:是(Resillient Distributed Dataset)弹性分布式数据集的简称,是分布式内存的一个抽象概念,提供了一种高度受限的共享内存模式。

DAG:是Directed Acyclis Graph(有向无环图)的简称,反应RDD之间的依赖关系

Executor:是运行在工作节点(Worker Node)上的一个进程,负责运行Task

Application:用户编写的Spark应用程序

Task:运行在Executor上的工作单元

Job:一个job包含多个RDD及作用于相应RDD上的各种操作

Stage:是Job的基本调度单位,一个job会分为多组task,每组task被称为stage,或者taskstage,代表一组关联的、相互之间没有shuffle依赖关系的任务组成的任务集。

有一天过去了!很充实!