深度解读Diederik P. Kingma和Max Welling的论文 Auto-encoding variational bayes1,对中间涉及的公式进行了详尽的推导。最后给出了变分自编码器的Tensorflow示例代码。

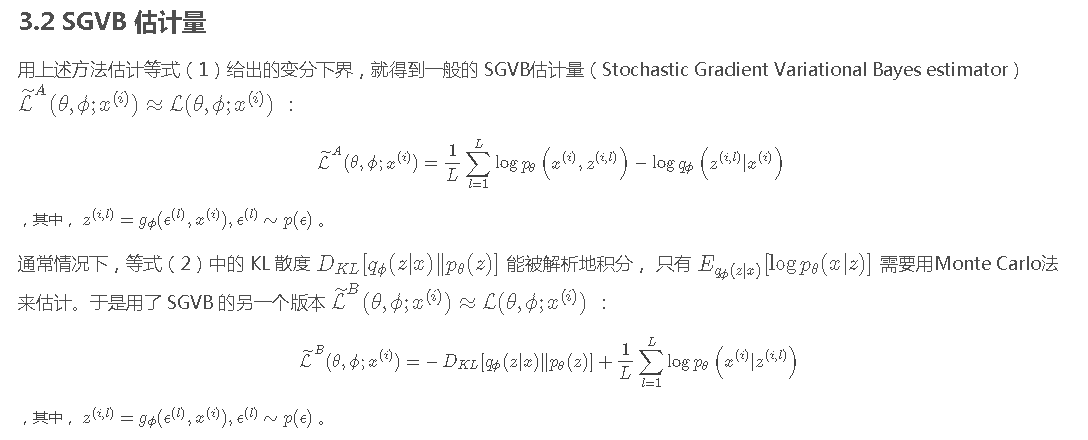

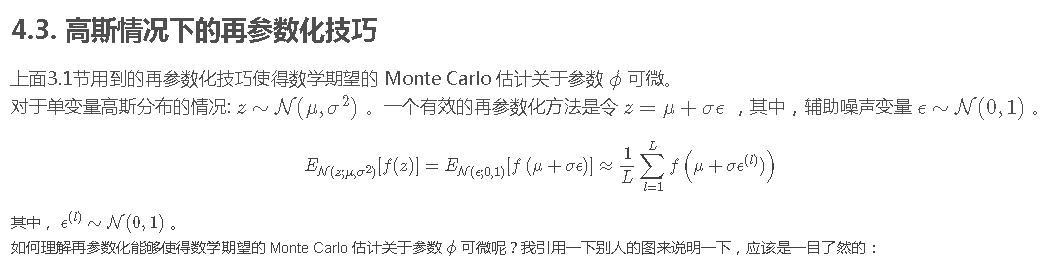

未经过再参数化2:

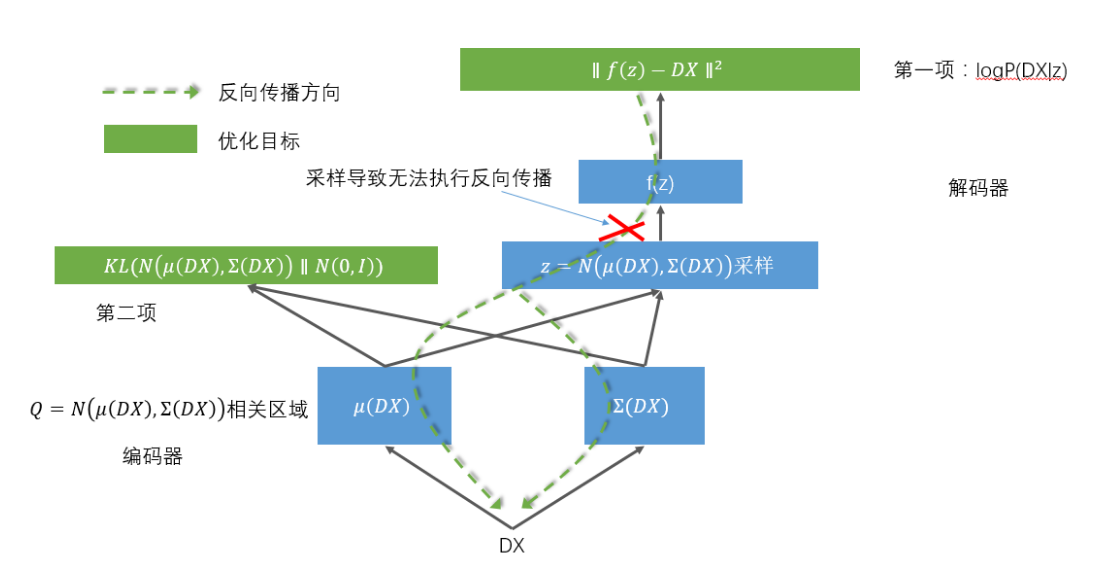

由于这个网络传递结构的一个环节是随机采样,导致无法反向传播,所以聪明的前辈又将这个结构优化成了这样:

经过再参数化后3:

即,将采样这一过程放在计算图的外部作为输入,而仅将最终计算的结果参与计算,计算的结果是可微的。

这样就可以对整个网络进行反向传播训练了。

注意:这里引用的两张图里说的“第一项”和“第二项”跟我在上面写的公式是相反的,即图里说的“第一项”实际上是上面公式里的第二项。

转自: