1:激活函数

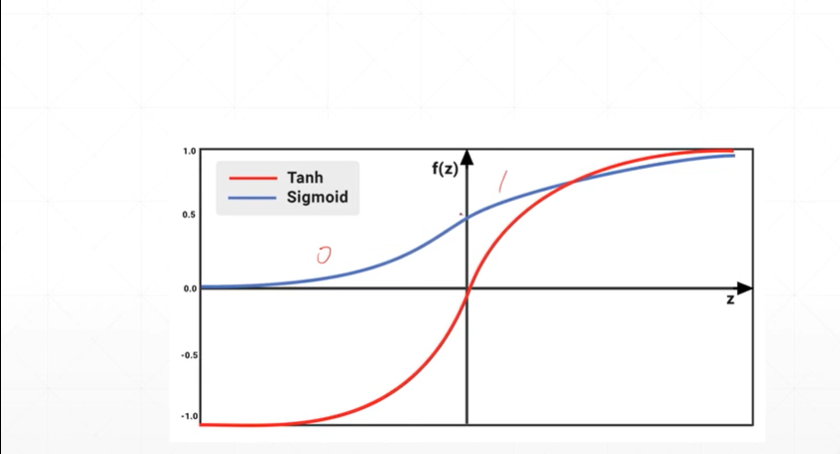

(1.1)Tanh和Sigmoid函数

[注]sigmoid函数的取值区间为[0,1],适合概率和RGB值的重建。Tanh函数的取值区间为[-1,1],多用于循环神经网络。

sigmoid和Tanh函数存在的问题:当w的取值无穷大或者无穷小的时候会出现梯度弥散的现象。

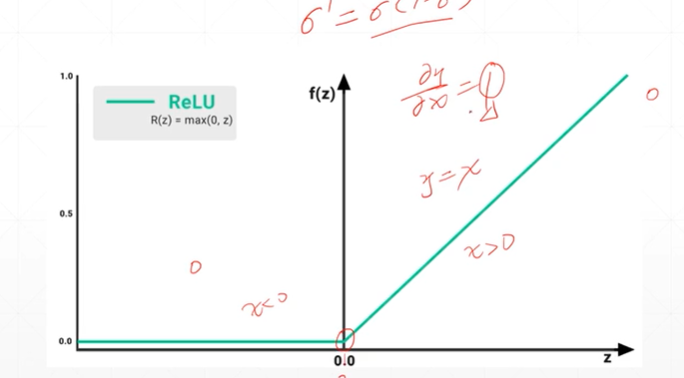

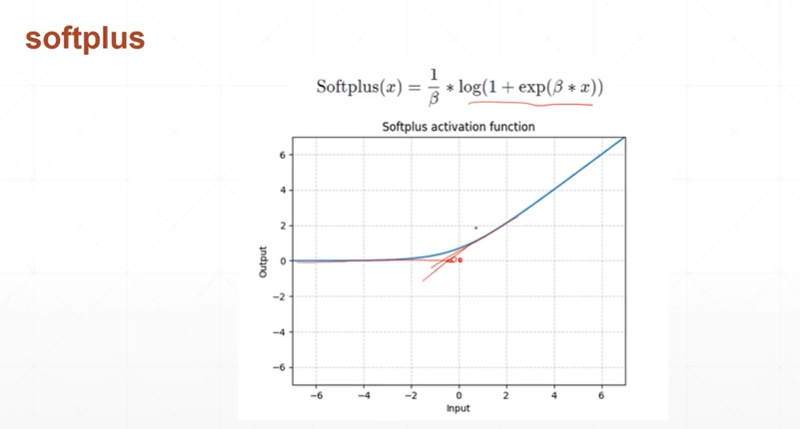

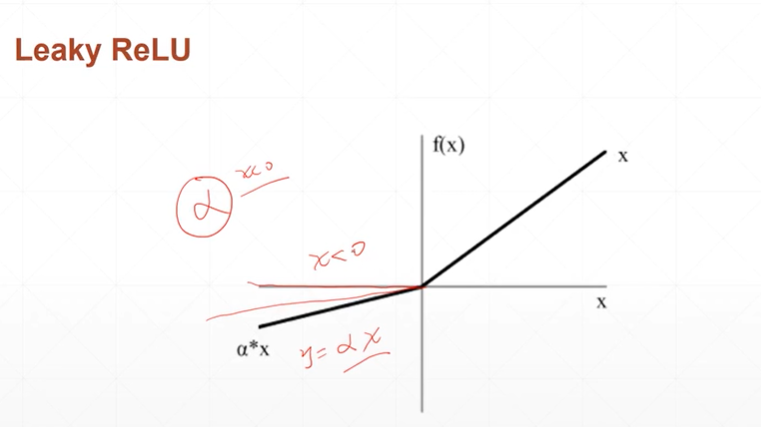

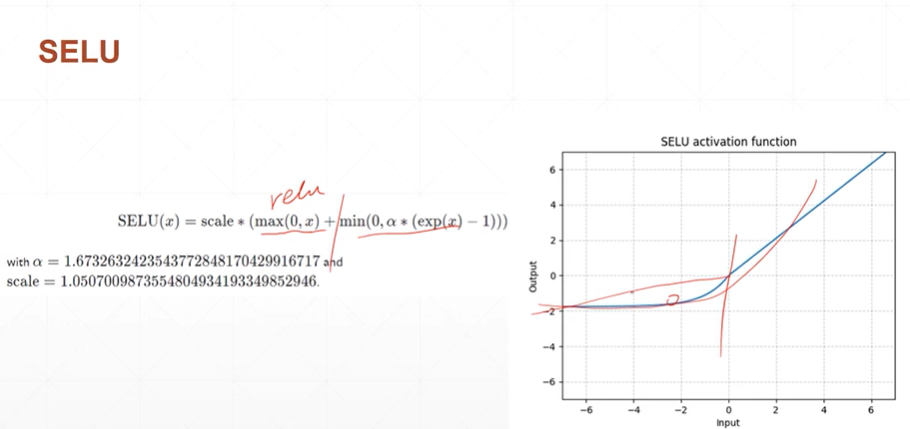

(1.2)ReLU,softplus,Leaky ReLU,SELU函数

[注]ReLU函数解决了自变量>0时梯度消失的问题,Leaky ReLU通过设置α来解决自变量<0时梯度消失的问题

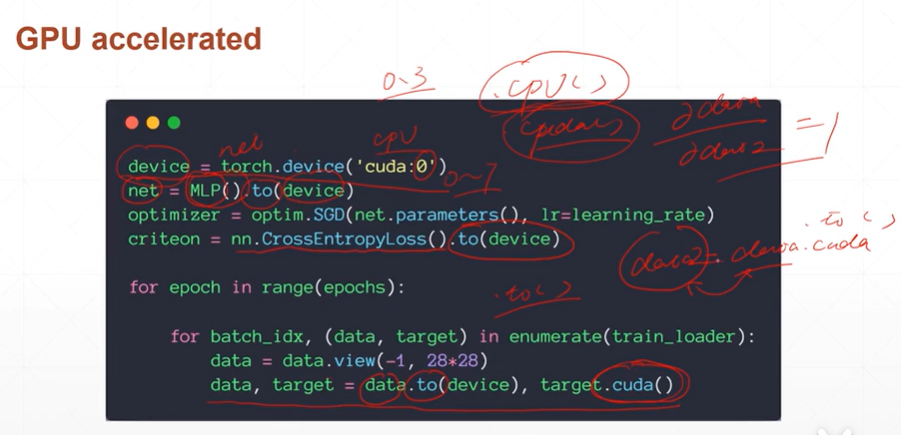

2:GPU加速

[注]0.3版本之前的GPU加速使用:.cuda()函数。0.4版本之后则使用device=torch.device('cuda:0')0为显卡的编号,这要根据自己有多少张显卡。通过to(device)将运算搬运到GPU上。