1.去github下载zip包

具体地址:https://github.com/medcl/elasticsearch-analysis-ik

因为我本地装的是7.4.2版本,我ik分词器也下载这个版本

地址:https://github.com/medcl/elasticsearch-analysis-ik/releases/tag/v7.4.2

2.下载好后上传到服务器中,然后解压

unzip elasticsearch-analysis-ik-7.4.2.zip -d /usr/local/elasticsearch-7.4.2/plugins/ik/

3.重启 elasticsearch

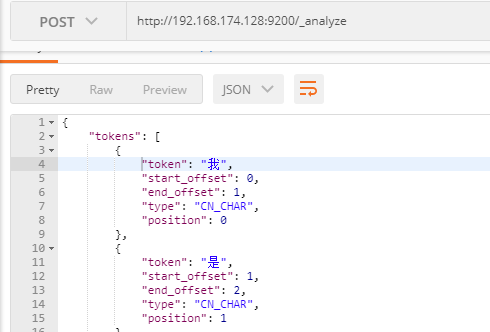

4.测试中文分词效果

POST /_analyze

{

"analyzer": "ik_max_word",

"text": "我是中华人民共和国公民"

}

注意

ik_max_word 和 ik_smart 什么区别?

ik_max_word: 会将文本做最细粒度的拆分,比如会将“中华人民共和国国歌”拆分为“中华人民共和国,中华人民,中华,华人,人民共和国,人民,人,民,共和国,共和,和,国国,国歌”,会穷尽各种可能的组合,适合 Term Query;

ik_smart: 会做最粗粒度的拆分,比如会将“中华人民共和国国歌”拆分为“中华人民共和国,国歌”,适合 Phrase 查询