介绍

在使用elasticsearch进行搜索业务的时候,发现一篇和搜索关键字完全不匹配的文章排在最前面.打开它发现原来是这篇文章含有非常多的"的"这个无意义的词.而我的搜索关键字假设为"历史上的

今天",它可能就被ik_max_word分词后,刚好就有"的"这个词.所以会造成一篇含有很多"的"的文章,即使跟搜索关键字无关,也可能得分很高,排在前面.

那么我们需要做的就是如何对这些无意义的词——停用词进行屏蔽.

操作

其实这个问题很好解决,如果你使用ik分词器,其实都为你解决了.但是它默认设置的停用词都是英文的,比如AND,OR等等

那么在哪里配置呢?找到你的es安装插件的文件夹,进入ik分词器的配置文件中,比如我的是

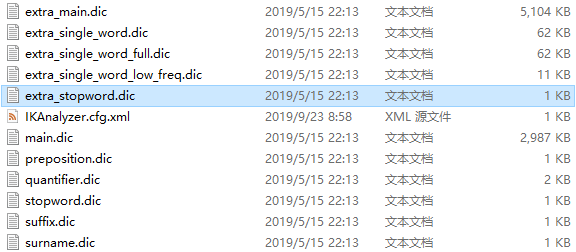

D:elasticsearch-7.0.0pluginsikconfig

打开它发现会有stopword.dic和extra_stopword.dic

打开会发现stopword.dic里面的都为配置的英文停用词,而extra_stopword.dic里面的都为配置的中文停用词

但是我发现在extra_stopword.dic中是有"的"啊.怎么没有效果呢?

原来我们还需要在IKAnalyzer.cfg.xml中进行配置

<?xml version="1.0" encoding="UTF-8"?> <!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd"> <properties> <comment>IK Analyzer 扩展配置</comment> <!--用户可以在这里配置自己的扩展字典 --> <entry key="ext_dict"></entry> <!--用户可以在这里配置自己的扩展停止词字典--> <entry key="ext_stopwords">extra_stopword.dic</entry> <!--用户可以在这里配置远程扩展字典 --> <!-- <entry key="remote_ext_dict">words_location</entry> --> <!--用户可以在这里配置远程扩展停止词字典--> <!-- <entry key="remote_ext_stopwords">words_location</entry> --> </properties>

如此便配置好了

我们再次搜索就会惊喜的发现,那篇含有无意义的词的文章便搜索不到了.