一、Controller选举机制

Kafka核心总控制器Controller在Kafka集群中会有一个或者多个broker,其中有一个broker会被选举为控制器(Kafka Controller),它负责管理整个集群中所有分区和副本的状态。

-

当某个分区的leader副本出现故障时,由控制器负责为该分区选举新的leader副本。

-

当检测到某个分区的ISR集合发生变化时,由控制器负责通知所有broker更新其元数据信息。

-

当使用kafka-topics.sh脚本为某个topic增加分区数量时,同样还是由控制器负责让新分区被其他节点感知到。

在kafka集群启动的时候,会自动选举一台broker作为controller来管理整个集群,选举的过程是集群中每个broker都会尝试在zookeeper上创建一个 /controller临时节点,zookeeper会保证有且仅有一个broker能创建成功,这个broker就会成为集群的总控器controller。当这个controller角色的broker宕机了,此时zookeeper临时节点会消失,集群里其他broker会一直监听这个临时节 点,发现临时节点消失了,就竞争再次创建临时节点,就是我们上面说的选举机制,zookeeper又会保证有一个broker 成为新的controller。具备控制器身份的broker需要比其他普通的broker多一份职责,具体细节如下:

-

监听broker相关的变化。为Zookeeper中的/brokers/ids/节点添加BrokerChangeListener,用来处理broker增减的变化。

-

监听topic相关的变化。为Zookeeper中的/brokers/topics节点添加TopicChangeListener,用来处理topic增减 的变化;为Zookeeper中的/admin/delete_topics节点添加TopicDeletionListener,用来处理删除topic的动作。

-

从Zookeeper中读取获取当前所有与topic、partition以及broker有关的信息并进行相应的管理。对于所有topic 所对应的Zookeeper中的/brokers/topics/[topic]节点添加PartitionModificationsListener,用来监听topic中的 分区分配变化。

-

更新集群的元数据信息,同步到其他普通的broker节点中。

二、Partition副本选举Leader机制

1、controller感知到分区leader所在的broker挂了(controller监听了很多zk节点可以感知到broker存活),

2、controller会从ISR列表(参数unclean.leader.election.enable=false的前提下)里挑第一个broker作为leader(第一个broker最先放进ISR列表,可能是同步数据最多的副本),

3、如果参数unclean.leader.election.enable为true,代表在ISR列表里所有副本都挂 了的时候可以在ISR列表以外的副本中选leader,这种设置,可以提高可用性,但是选出的新leader有可能数据少很多。副本进入ISR列表有两个条件:

-

副本节点不能产生分区,必须能与zookeeper保持会话以及跟leader副本网络连通

-

副本能复制leader上的所有写操作,并且不能落后太多。(与leader副本同步滞后的副本,是由replica.lag.time.max.ms 配置决定的,超过这个时间都没有跟leader同步过的一次的副本会被移出ISR列表)

三、消费者消费消息的offset记录机制

每个consumer会定期将自己消费分区的offset提交给kafka内部topic:consumer_offsets,提交过去的时候,key是consumerGroupId+topic+分区号,value就是当前offset的值,kafka会定期清理topic里的消息,最后就保留最新的 那条数据因为consumer_offsets可能会接收高并发的请求,kafka默认给其分配50个分区(可以通过offsets.topic.num.partitions设置),这样可以通过加机器的方式抗大并发。

四、消费者Rebalance机制

rebalance就是说如果消费组里的消费者数量有变化或消费的分区数有变化,kafka会重新分配消费者消费分区的关系。 比如consumer group中某个消费者挂了,此时会自动把分配给他的分区交给其他的消费者,如果他又重启了,那么又会把一些分区重新交还给他。注意:rebalance只针对subscribe这种不指定分区消费的情况,如果通过assign这种消费方式指定了分区,kafka不会进 行rebanlance。如下情况可能会触发消费者rebalance

- 消费组里的consumer增加或减少了

- 动态给topic增加了分区

- 消费组订阅了更多的topic

rebalance过程中,消费者无法从kafka消费消息,这对kafka的TPS会有影响,如果kafka集群内节点较多,比如数百 个,那重平衡可能会耗时极多,所以应尽量避免在系统高峰期的重平衡发生。

Rebalance过程如下

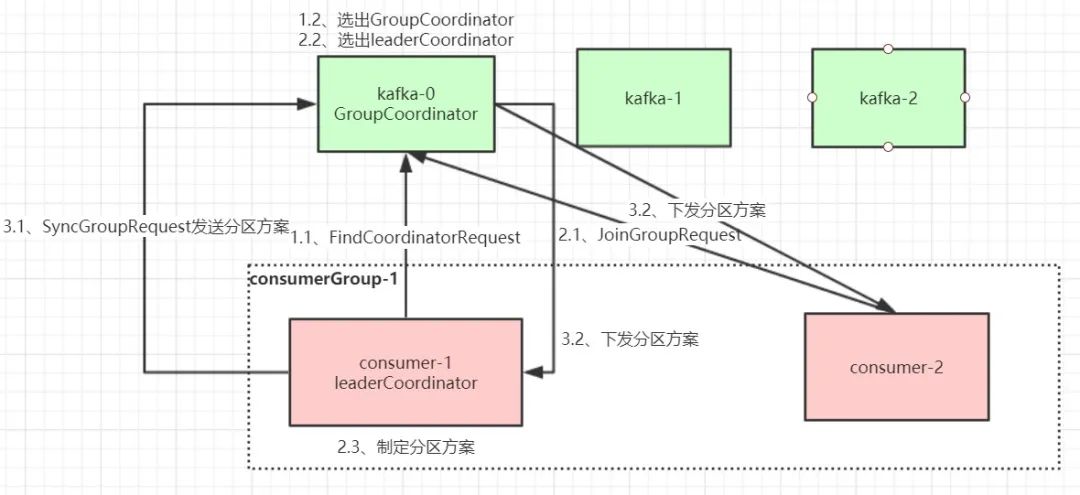

第一阶段:选择组协调器

组协调器GroupCoordinator:每个consumer group都会选择一个broker作为自己的组协调器coordinator,负责监控这个消费组里的所有消费者的心跳,以及判断是否宕机,然后开启消费者rebalance。consumer group中的每个consumer启动时会向kafka集群中的某个节点发送FindCoordinatorRequest 请求来查找对应的组协调器GroupCoordinator,并跟其建立网络连接。

组协调器选择方式:

通过如下公式可以选出consumer消费的offset要提交到consumer_offsets的哪个分区,这个分区leader对应的broker就是这个consumergroup的coordinator

公式:hash(consumergroup id) % consumer_offsets主题的分区数

第二阶段:加入消费组(JOIN GROUP)

在成功找到消费组所对应的GroupCoordinator 之后就进入加入消费组的阶段,在此阶段的消费者会向GroupCoordinator发送 JoinGroupRequest请求,并处理响应。然后GroupCoordinator从一个consumergroup中选择第一个加入group的consumer作为leader(消费组协调器),把consumergroup情况发送给这个leader,接着这个leader会负责制定分区方案。

第三阶段:同步分组方案(SYNC GROUP)

consumer leader通过给GroupCoordinator发送SyncGroupRequest,接着GroupCoordinator就把分区方案下发给各个consumer,

他们会根据指定分区的leaderbroker进行网络连接以及消息消费。

参考:https://zhuanlan.zhihu.com/p/374931386