Task05:卷积神经网络基础;leNet;卷积神经网络进阶

学习笔记见:https://www.cnblogs.com/guohaoblog/p/12325038.html

卷积神经网络基础

1、假如你用全连接层处理一张256×256的彩色(RGB)图像,输出包含1000个神经元,在使用偏置的情况下,参数数量是:

A、65536001

B、65537000

C、196608001

D、196609000

答:选择D

图像展平后长度为3×256×256,权重参数和偏置参数的数量是3×256×256×1000+1000=196609000。

2、假如你用全连接层处理一张256×256的彩色(RGB)图像,卷积核的高宽是3×3,输出包含10个通道,在使用偏置的情况下,这个卷积层共有多少个参数:

A、90

B、100

C、280

D、300

答:选择B

输入通道数是3,输出通道数是10,所以参数数量是10×3×3×3+10=280。

3、conv2d = nn.Conv2d(in_channels=3, out_channels=4, kernel_size=3, padding=2),输入一张形状为3×100×100的图像,输出的形状为:

A、3×102×102

B、3×100×100

C、4×102×102

D、4×100×100

答:选择C

输出通道数是4,上下两侧总共填充4行,卷积核高度是3,所以输出的高度是104−3+1=102,宽度同理可得。

4、关于卷积层,以下哪种说法是错误的:

A、1×1卷积可以看作是通道维上的全连接

B、某个二维卷积层用于处理形状为3×100×100的输入,则该卷积层无法处理形状为3×256×256的输入

C、卷积层通过填充、步幅、输入通道数、输出通道数等调节输出的形状

D、两个连续的3×3卷积核的感受野与一个5×5卷积核的感受野相同

答:选择B

A项:假设我们将通道维当作特征维,将高和宽维度上的元素当成数据样本,那么1×1卷积可看作通道维上的全连接。主要有两大作用:①实现跨通道的交互和信息整合 ②进行卷积核通道的降维和升维。

B项::对于高宽维度,只要输入的高宽(填充后的)大于或等于卷积核的高宽即可进行计算

C和D项正确

5、关于池化层,以下哪种说法是错误的:

A、池化层不参与反向传播

B、池化层没有模型参数

C、池化层通常会减小特征图的高和宽

D、池化层的输入和输出具有相同的通道数

答:选择A

池化层有参与模型的正向计算,同样也会参与反向传播,只是池化层没有模型参数。

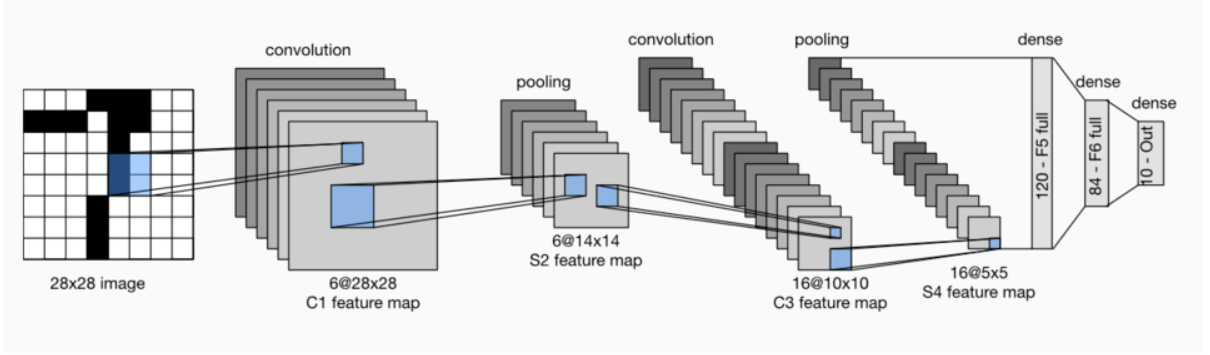

LeNet

1、关于LeNet,以下说法中错误的是:

A、LeNet主要分为两个部分:卷积层块和全连接层块

B、LeNet的绝大多数参数集中在卷积层块部分

C、LeNet在连接卷积层块和全连接层块时,需要做一次展平操作

D、LeNet的卷积层块交替使用卷积层和池化层。

答:选择B

LeNet模型中,90%以上的参数集中在全连接层块。

2、关于卷积神经网络,以下说法中错误的是:

A、因为全连接层的参数数量比卷积层多,所以全连接层可以更好地提取空间信息

B、使用形状为2×2,步幅为2的池化层,会将高和宽都减半

C、卷积神经网络通过使用滑动窗口在输入的不同位置处重复计算,减小参数数量

D、在通过卷积层或池化层后,输出的高和宽可能减小,为了尽可能保留输入的特征,我们可以在减小高宽的同时增加通道数

答:选择A

①全连接层把图像展平成一个向量,在输入图像上相邻的元素可能因为展平操作不再相邻,网络难以捕捉局部信息。而卷积层的设计,天然地具有提取局部信息的能力。

②卷积层的参数量更少

卷积神经网络进阶

1、关于AlexNet描述错误的是

A、用Dropout来控制全连接层的模型复杂度

B、包含有5层卷积和2层全连接隐藏层,以及1个全连接输出层

C、将LeNet中的ReLU激活函数改成了sigmoid激活函数。

D、首次证明了学习到的特征可以超越⼿⼯设计的特征

答:选择C

2、下列哪个网络串联多个由卷积层和“全连接”层构成的小⽹络来构建⼀个深层⽹络:

A、AlexNet

B、VGG

C、NiN

D、GoogLeNet

答:选择C

这个选项容易误选B,VGG:通过重复使⽤简单的基础块来构建深度模型。NiN:串联多个由卷积层和“全连接”层构成的小⽹络来构建⼀个深层⽹络。

⽤输出通道数等于标签类别数的NiN块,然后使⽤全局平均池化层对每个通道中所有元素求平均并直接⽤于分类。

3、下列模型不是由基础块重复堆叠而成的是

A、AlexNet

B、VGG

C、NiN

D、GoogLeNet

答:选择A

AlexNet由5个卷积层+2个全连接隐藏层+1个全连接层组成

4、通道数为3,宽高均为224的输入,经过一层输出通道数为96,卷积核大小为11,步长为4,无padding的卷积层后,得到的feature map的宽高为

A、96

B、54

C、53

D、224

答:选择B

卷积计算公式: (n + 2p - f)/s + 1

⌊(224−11)/4⌋+1=54

5、关于VGG描述正确的是

A、使⽤全局平均池化层对每个通道中所有元素求平均并直接⽤于分类。

B、通过不同窗口形状的卷积层和最⼤池化层来并⾏抽取信息。

C、与AlexNet相比,难以灵活地改变模型结构。

D、通过重复使⽤简单的基础块来构建深度模型。

答:选择D

A项说的是NiN,B项说的是GoogLeNet,C项刚好说反了。