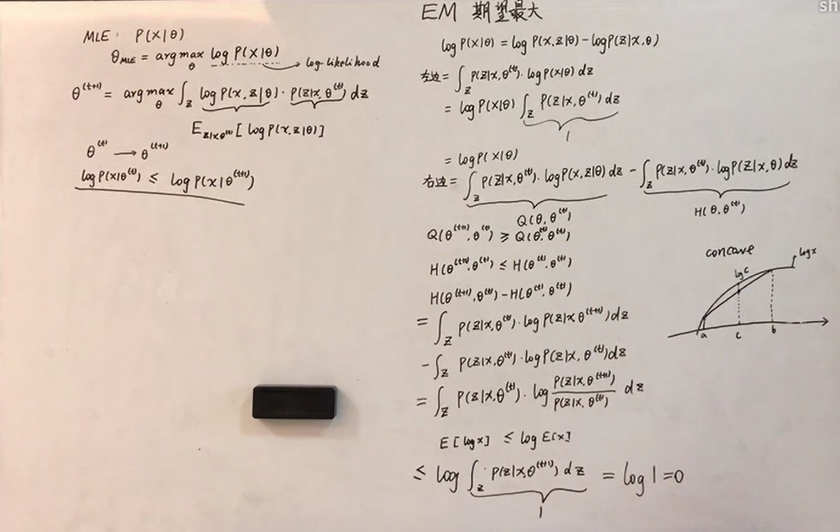

EM算法收敛性证明:

来源:B站up:shuhuai008,板书

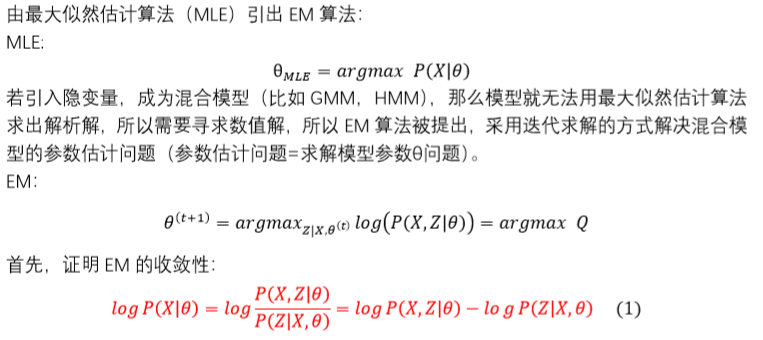

EM(expectation maximization algorithm):期望最大算法,分为“期望”和“最大两部分,分别用“E-step”和“M”step解决。

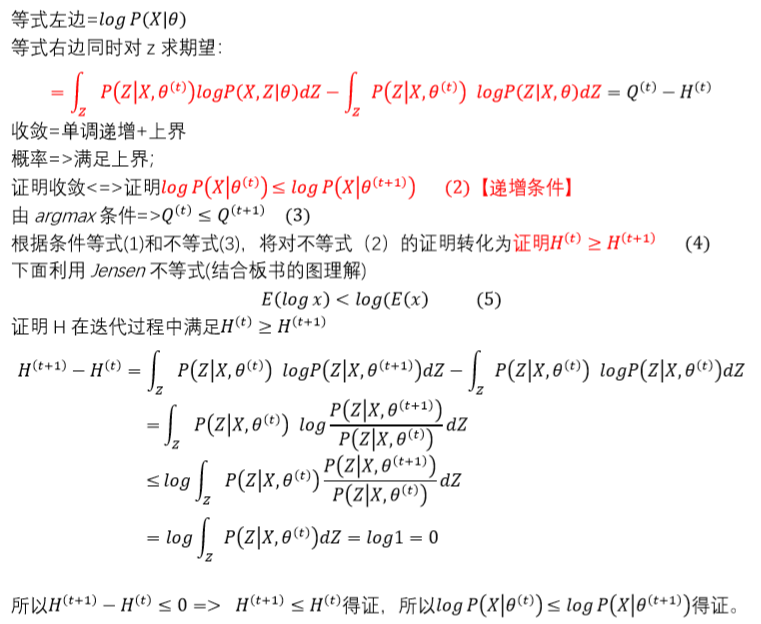

一、收敛性证明:

其中,Q(t)是Q(θ(t),θ(t))的简略表达; Q(t+1)是Q(θ(t),θ(t+1))的简略表达;H(t),H(t+1)同理,Q(θ(t),θ(t+1))这样的表达更严谨,因为Q是θ(t)和θ的函数,更准确的说是θ的函数,因为在迭代过程中θ(t)是已知量。但是为了更清晰地表达迭代过程,所以表达为Q(θ(t),θ)。

推导过程中需要注意的点:

①P(Z|X,θ)是后验概率,在EM算法中假设后验是能直接求出的,但是实际问题中不一定能够得到,所以提出了EM的各个变种算法。

②注意Q(θ(t),θ(t+1))中,θ(t+1))代入联合概率P(X,Z|θ(t+1));θ(t)代入条件P(Z|X,θ(t))

③(如下图)P(X,Z|θ)是X和Z的联合概率。为什么会有联合概率的引入?这个涉及到EM算法求解混合模型的思想是:求解模型参数θ问题=>转换成求解最大似然P(X|θ),简单模型可以直接求导得到解析解,但如果问题太过复杂,无法得到解析解,只能采用数值解法。数值解法的思想还是求解P(X|θ),只不过复杂问题的P(X|θ)不能直接得出,所以引入了隐变量Z,构造出了混合模型(也叫生成模型)GMM,HMM等,隐变量的出现将概率P(X|θ)进行分解,使得P(X|θ)=P(X,Z|θ)/P(Z|X,θ),从而将问题分解成更小的单位进行求解。

参考资料:

1.https://www.bilibili.com/video/BV1BW41117xo?p=9 ,作者:shuhuai008